Hadoop-Hbase大数据集群安装教程

"这篇文档详细介绍了如何在Linux环境下搭建Hadoop-HBase大数据处理环境,并涵盖了相关的组件如Zookeeper和Phoenix的安装与配置。整个过程包括了系统准备、各个组件的下载、配置、安装以及启动,同时也提及了一些常见的故障解决方法和额外的HBase使用技巧。"

在大数据处理领域,Hadoop和HBase是两个重要的开源工具。Hadoop是一个分布式文件系统(HDFS),用于处理和存储大规模数据,而HBase是一个基于Hadoop的数据存储系统,提供了高效的实时读写能力,适用于大数据的NoSQL场景。

一、集群环境总述

在开始安装前,首先需要一个稳定的Linux集群环境,通常选择CentOS或Ubuntu等服务器操作系统。集群中的每台主机需要分配好角色,例如主节点、从节点等,并确保网络连通性。

二、安装前准备

1. 创建专门的Hadoop用户,以提高安全性。

2. 设置静态IP地址,保证主机间的通信。

3. 关闭防火墙或设置允许Hadoop相关端口的规则。

4. 确保各主机的hostname和hosts文件配置正确,以便相互识别。

5. 安装Java并设置环境变量,因为Hadoop、HBase和Zookeeper都需要Java运行环境。

6. 配置SSH免密码登录,简化集群操作。

7. 进行时间同步,确保集群中所有节点的时间一致,这对于分布式计算非常重要。

三、安装Hadoop

1. 下载Hadoop的最新稳定版本,如2.7.1。

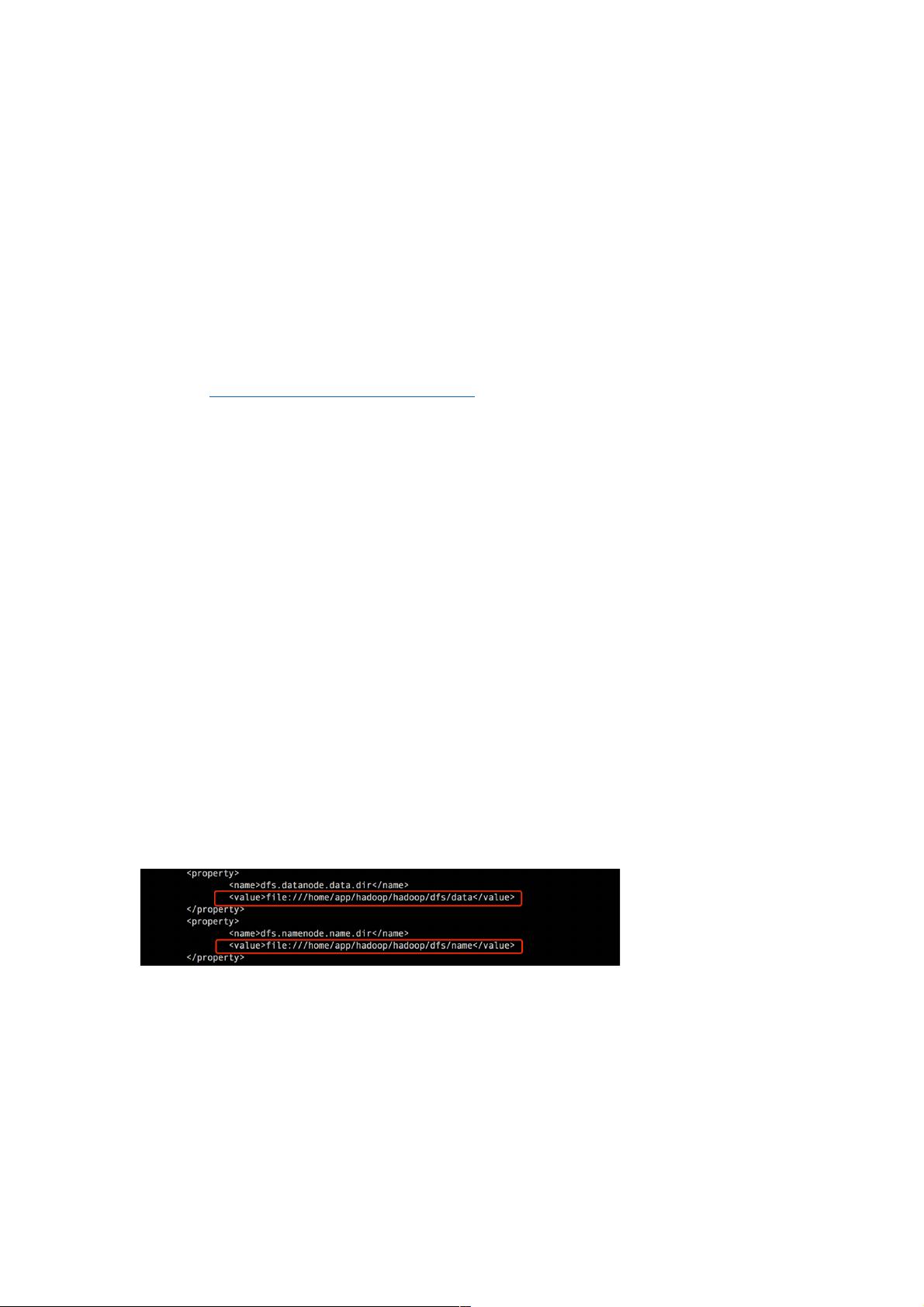

2. 配置Hadoop的配置文件如`core-site.xml`、`hdfs-site.xml`,定义NameNode和DataNode的相关参数。

3. 创建HDFS的目录结构,如`/usr/local/hadoop/data`,分别作为NameNode和DataNode的数据目录。

4. 启动Hadoop服务,包括NameNode、DataNode和SecondaryNameNode等。

5. 检查Hadoop服务是否正常运行,通过Web界面或命令行工具验证。

四、安装Zookeeper

1. 下载Zookeeper的最新版本,如3.4.6。

2. 配置Zookeeper的`zoo.cfg`文件,指定数据目录和客户端连接端口等。

3. 创建Zookeeper的数据目录,并初始化。

4. 将Zookeeper的服务添加到Hadoop的环境变量中,便于HBase调用。

5. 启动Zookeeper服务,并确保其运行正常。

五、安装HBase

1. 下载HBase的最新版本,如1.1.2。

2. 修改HBase的配置文件`hbase-site.xml`,设置Zookeeper地址和HBase的root目录。

3. 复制Hadoop的相关库文件到HBase的lib目录,使HBase能识别Hadoop环境。

4. 创建HBase的HDFS存储目录。

5. 启动HBase Master和RegionServer,通过Web界面或命令行工具检查运行状态。

六、安装Phoenix

1. 获取Phoenix的最新版本,如4.5.1。

2. 配置Phoenix的JDBC驱动,使其能连接到HBase。

3. 修改HBase的配置,启用对Phoenix的支持。

4. 使用Phoenix提供的SQL语句进行数据操作。

5. 查看Phoenix的运行状态,以确认安装成功。

七、常见故障

遇到RegionServer或Zookeeper异常时,可以尝试重启相关服务来解决问题。

八、其它

1. HBase支持分页查询,提高数据检索效率。

2. 可以通过Hadoop的MapReduce框架编译、打包并运行WordCount示例程序。

3. 对于64位系统,需要特定步骤编译Hadoop源代码。

4. Phoenix提供了一套SQL方言,方便开发者操作HBase。

5. Hive是基于Hadoop的数据仓库工具,适合离线分析,而HBase更适合实时在线查询。

6. 理解Hbase的配置文件内容,有助于优化HBase的性能。

7. 当NameNode出现问题时,可参考SecondaryNameNode的机制进行恢复。

搭建Hadoop-HBase大数据环境需要细心的配置和测试,一旦完成,将为大数据处理提供强大的基础设施。

相关推荐

无聊的职业生涯

- 粉丝: 10

最新资源

- 安装Oracle必备:unixODBC-2.2.11-7.1.x86_64.rpm

- Spring Boot与Camel XML聚合快速入门教程

- React开发新工具:可拖动、可调整大小的窗口组件

- vlfeat-0.9.14 图像处理库深度解析

- Selenium自动化测试工具深度解析

- ASP.NET房产中介系统:房源信息发布与查询平台

- SuperScan4.1扫描工具深度解析

- 深入解析dede 3.5 Delphi反编译技术

- 深入理解ARM体系结构及编程技巧

- TcpEngine_0_8_0:网络协议模拟与单元测试工具

- Java EE实践项目:在线商城系统演示

- 打造苹果风格的Android ListView实现与下拉刷新

- 黑色质感个人徒步旅行HTML5项目源代码包

- Nuxt.js集成Vuetify模块教程

- ASP.NET+SQL多媒体教室管理系统设计实现

- 西北工业大学嵌入式系统课程PPT汇总