Spark性能优化:理解核心概念与调优策略

130 浏览量

更新于2024-08-27

收藏 241KB PDF 举报

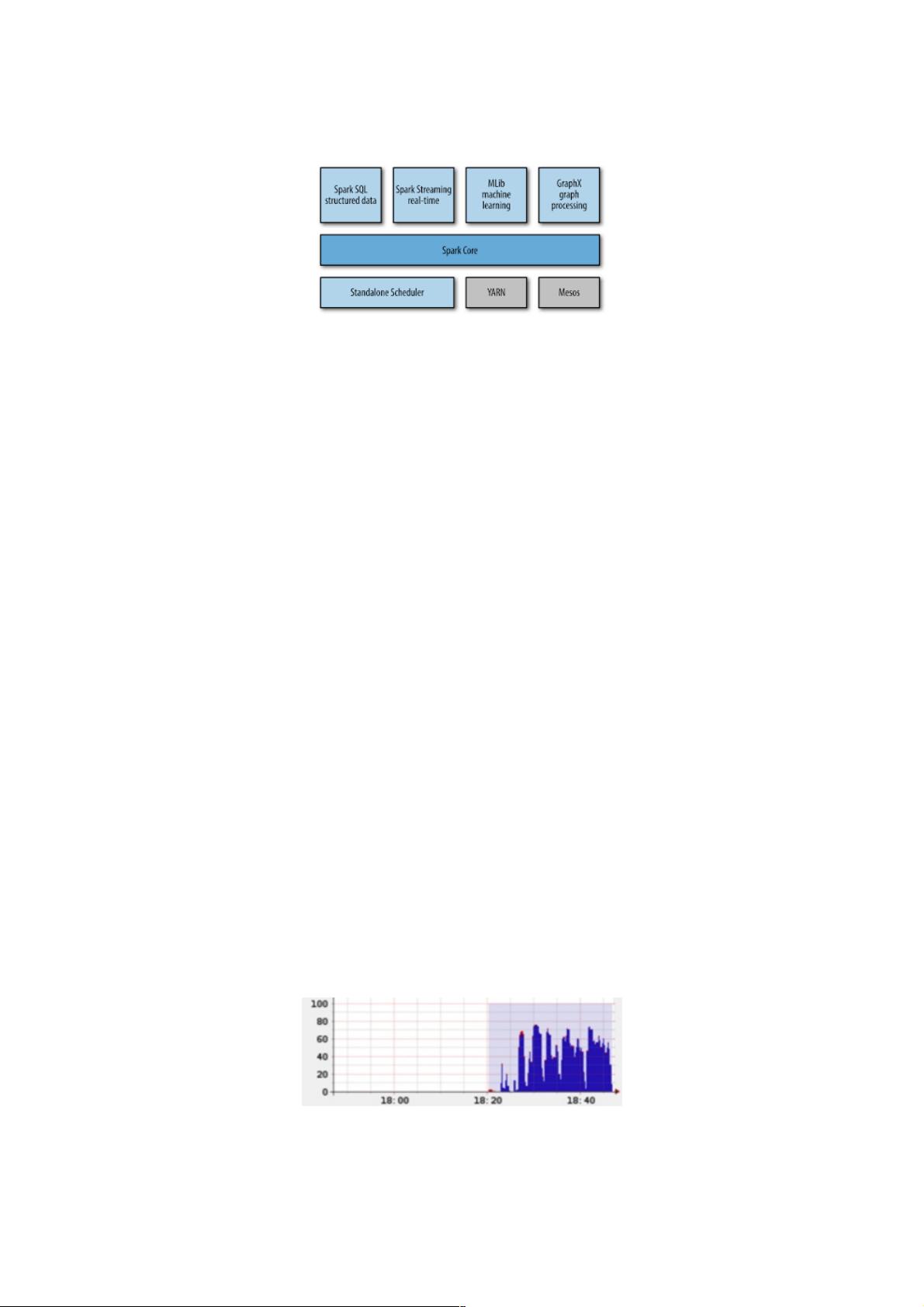

"Spark性能调优的关键在于理解其核心概念,包括worker、executor、task、stage、CPU core的分配以及partition和parallelism的优化。在Spark集群中,每一台主机(host)可运行多个worker,每个worker又可并行运行多个executor,任务(task)在executor上执行。理解stage的概念是关键,因为shuffle操作会分割stage,影响并行性。CPU core的合理分配对提升性能至关重要,避免executor过度占用core但未充分利用的情况。

在优化过程中,应当关注executor的内存使用,过多的executor可能导致内存紧张,引发数据溢出或内存错误。调整executor数量与core分配平衡,确保CPU利用率最大化,但同时要注意内存分配的合理性。

partition是数据分片,每个task处理一个partition,过多或过少都会影响性能。如果partition数量过少,每个task处理的数据量过大,可能导致内存压力;反之,如果过多,则task创建过多,增加调度开销。parallelism是并行度,与partition紧密相关,影响reduce操作的并行性。默认的并行度可以通过`spark.default.parallelism`设置,而map操作通常不会改变partition数量。

优化策略包括:根据数据规模和计算需求适当调整executor的数量和core分配,确保executor内存充足且避免数据溢出;合理设定partition数量以平衡数据处理量和并行效率;以及通过设置`spark.default.parallelism`控制默认的并行度,提高计算效率。此外,优化数据加载和持久化策略,减少shuffle操作,也能显著提升性能。例如,使用broadcast变量减少数据传输,或利用in-memory caching加速重复计算。

最后,注意监控系统资源,如CPU、内存和网络带宽的使用情况,及时识别瓶颈并进行针对性优化。使用Spark的性能监控工具,如Spark UI和metrics系统,可以帮助分析任务执行的性能指标,进一步指导调优工作。"

以上内容详细解释了Spark性能调优的主要方面,涵盖了从基础概念到具体实践的多个层次,旨在帮助用户更好地理解和优化其Spark应用的性能。

2018-09-30 上传

2017-12-29 上传

2019-03-21 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38706055

- 粉丝: 5

- 资源: 908

最新资源

- Flex垃圾回收与内存管理:防止内存泄露

- Python编程规范与最佳实践

- EJB3入门:实战教程与核心概念详解

- Python指南v2.6简体中文版——入门教程

- ANSYS单元类型详解:从Link1到Link11

- 深度解析C语言特性与实践应用

- Gentoo Linux安装与使用全面指南

- 牛津词典txt版:信息技术领域的便捷电子书

- VC++基础教程:从入门到精通

- CTO与程序员职业规划:能力提升与路径指南

- Google开放手机联盟与Android开发教程

- 探索Android触屏界面开发:从入门到设计原则

- Ajax实战:从理论到实践

- 探索Android应用开发:从入门到精通

- LM317T稳压管详解:1.5A可调输出,过载保护

- C语言实现SOCKET文件传输简单教程