美团技术团队分享:Spark性能调优实战与资源管理

需积分: 9 130 浏览量

更新于2024-07-19

收藏 2.71MB PDF 举报

本文档是关于Spark性能调优的详细指南,由美团技术团队整理,旨在帮助开发者理解和改进Spark应用的性能。内容分为两个主要部分:开发调优原则和资源调优。

在开发调优部分,作者列举了九个关键原则:

1. 避免创建重复的RDD,通过提供一个简单的例子来说明如何减少不必要的数据计算。

2. 尽可能复用同一个RDD,减少数据读取和计算成本。

3. 对多次使用的RDD进行持久化,介绍持久化级别的选择及其影响,并给出了代码示例。

4. 提倡使用Broadcast和map join来替代shuffle操作,降低网络通信开销。

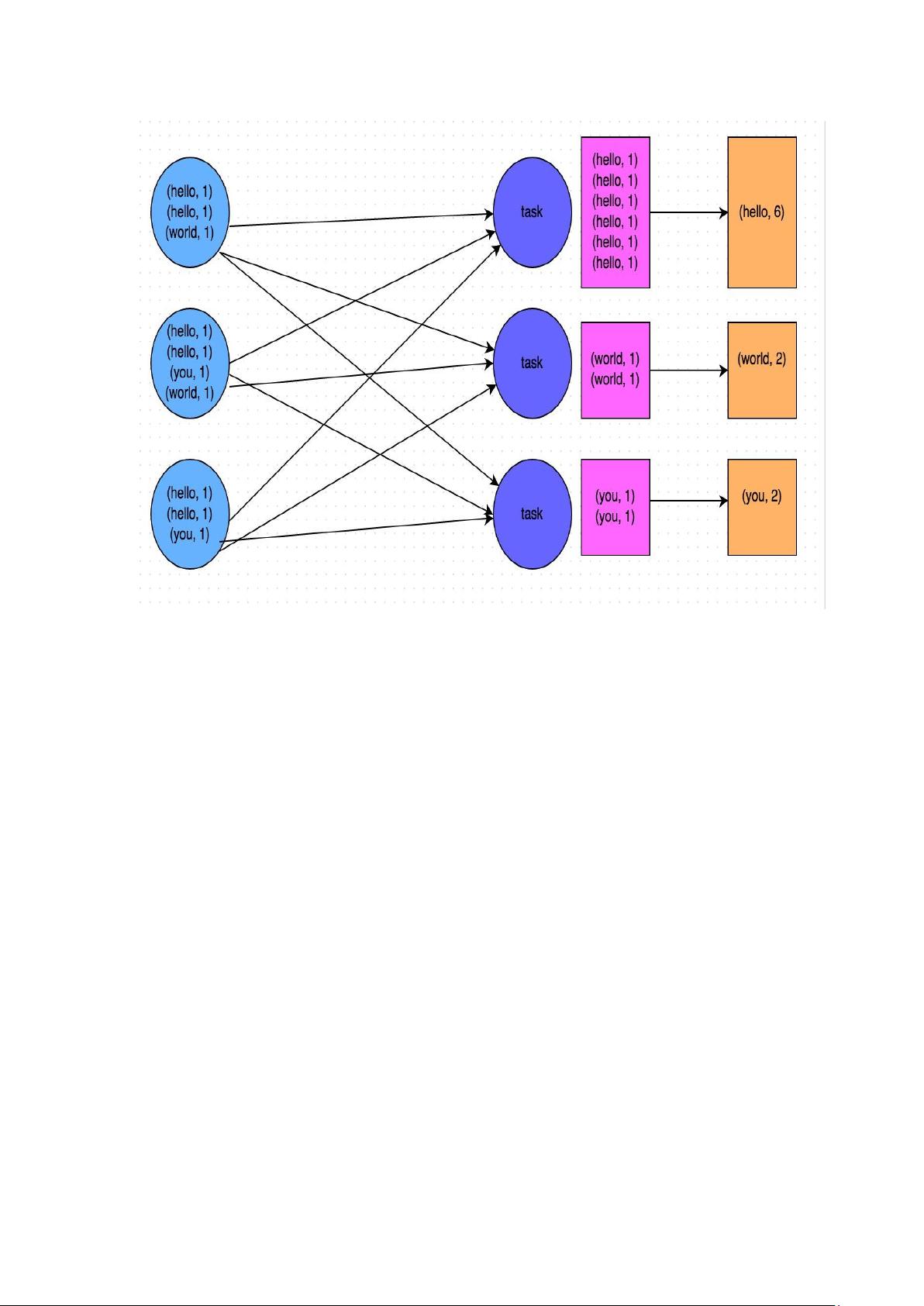

5. 强调map-side预聚合shuffle操作,提高处理效率。

6. 推荐使用高效算子,如reduceByKey和aggregateByKey代替groupByKey,以及mapPartitions和foreachPartitions等。

7. 在广播大变量时,给出代码示例并强调其在性能优化中的作用。

8. 使用Kryo进行序列化性能优化,减少内存消耗。

9. 优化数据结构,以提升数据访问速度。

资源调优部分涵盖了Spark作业的基本运行原理,包括资源参数的配置,如num-executors、executor-memory、executor-cores、driver-memory等。作者提供了这些参数的调整策略,并给出了参考示例,以确保任务的有效分布和资源的最大利用。

数据倾斜调优是另一个重要议题,它解释了数据倾斜的常见现象,即大部分任务快速执行,而少数任务耗时过长。作者分析了数据倾斜的原理,并提供方法来定位和解决代码中的问题,例如检查可能导致倾斜的代码段和优化策略。

这份文档不仅介绍了Spark性能调优的基本原则,还深入剖析了资源管理和数据倾斜的处理技巧,对于优化Spark应用程序的性能具有很高的实用价值。通过遵循这些指导,开发者可以显著提升Spark应用的执行效率和资源利用率。

2017-12-29 上传

2021-02-26 上传

2019-03-21 上传

2018-08-15 上传

2023-03-16 上传

2023-10-12 上传

cwbcom

- 粉丝: 4

- 资源: 12