Spark基础环境搭建与集群配置详解

需积分: 10 64 浏览量

更新于2024-07-19

收藏 3.53MB PDF 举报

本文档主要介绍了Spark编译与部署的基础环境搭建过程,适用于对Spark技术感兴趣的读者。作者石山园在博客<http://www.cnblogs.com/shishanyuan>上详细阐述了如何在Windows环境下使用VMware Workstation创建并配置CentOS 6.5 64位虚拟机作为Spark集群的基础样板机。以下是文章的主要知识点:

1. **运行环境说明**

- 主机环境:Windows 64位,配备双核4线程处理器、2.2G主频和10GB内存。

- 虚拟化软件:VMware Workstation 9.0.0 build-812388。

- 虚拟机环境:CentOS 6.5 64位,单核配置,1GB内存。

- 必要软件版本:

- JDK:1.7.0_55 64位

- Hadoop:2.2.0(需编译为64位)

- Scala:2.10.4

- Spark:1.1.0(需要手动编译)

2. **基础环境搭建步骤**

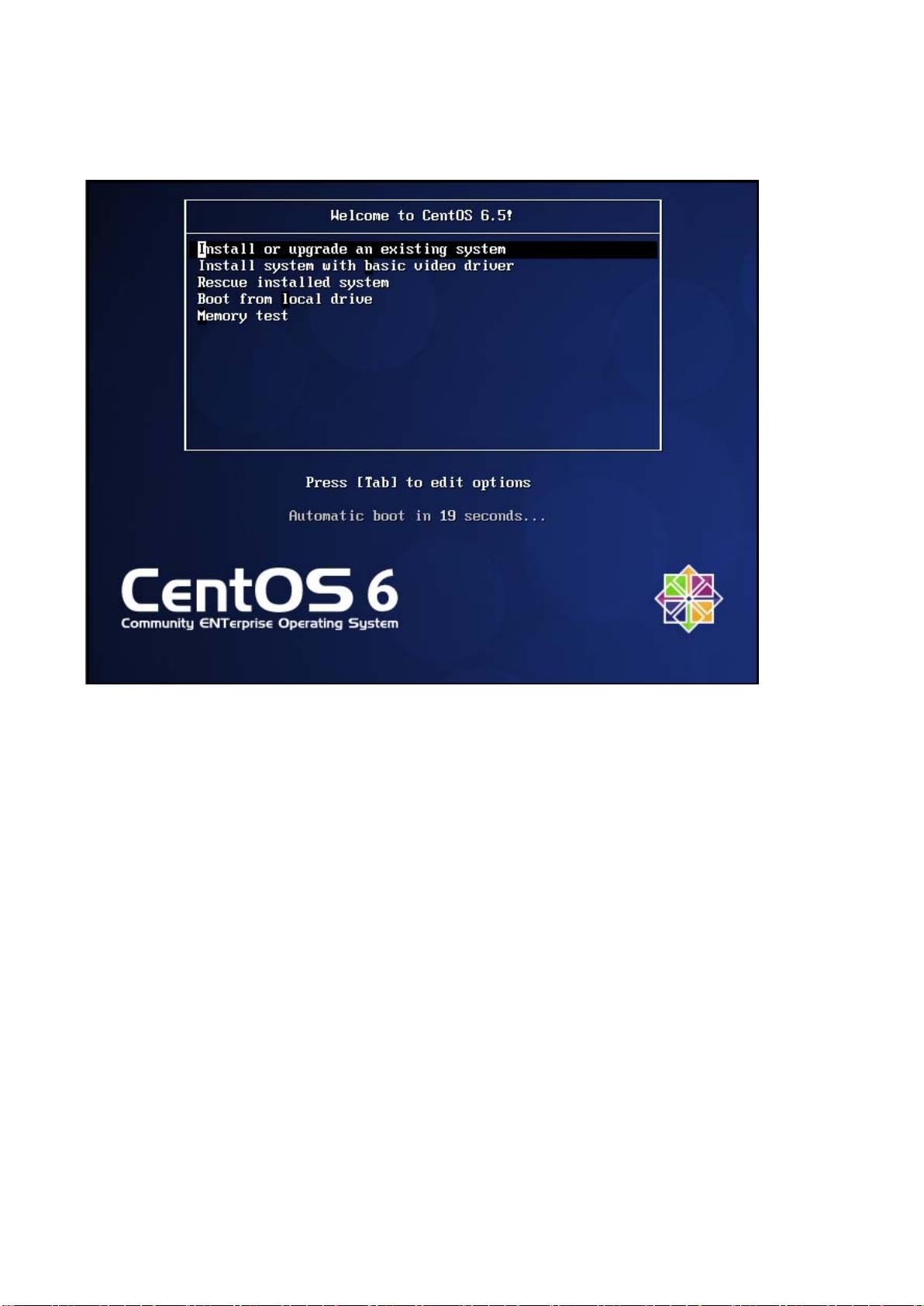

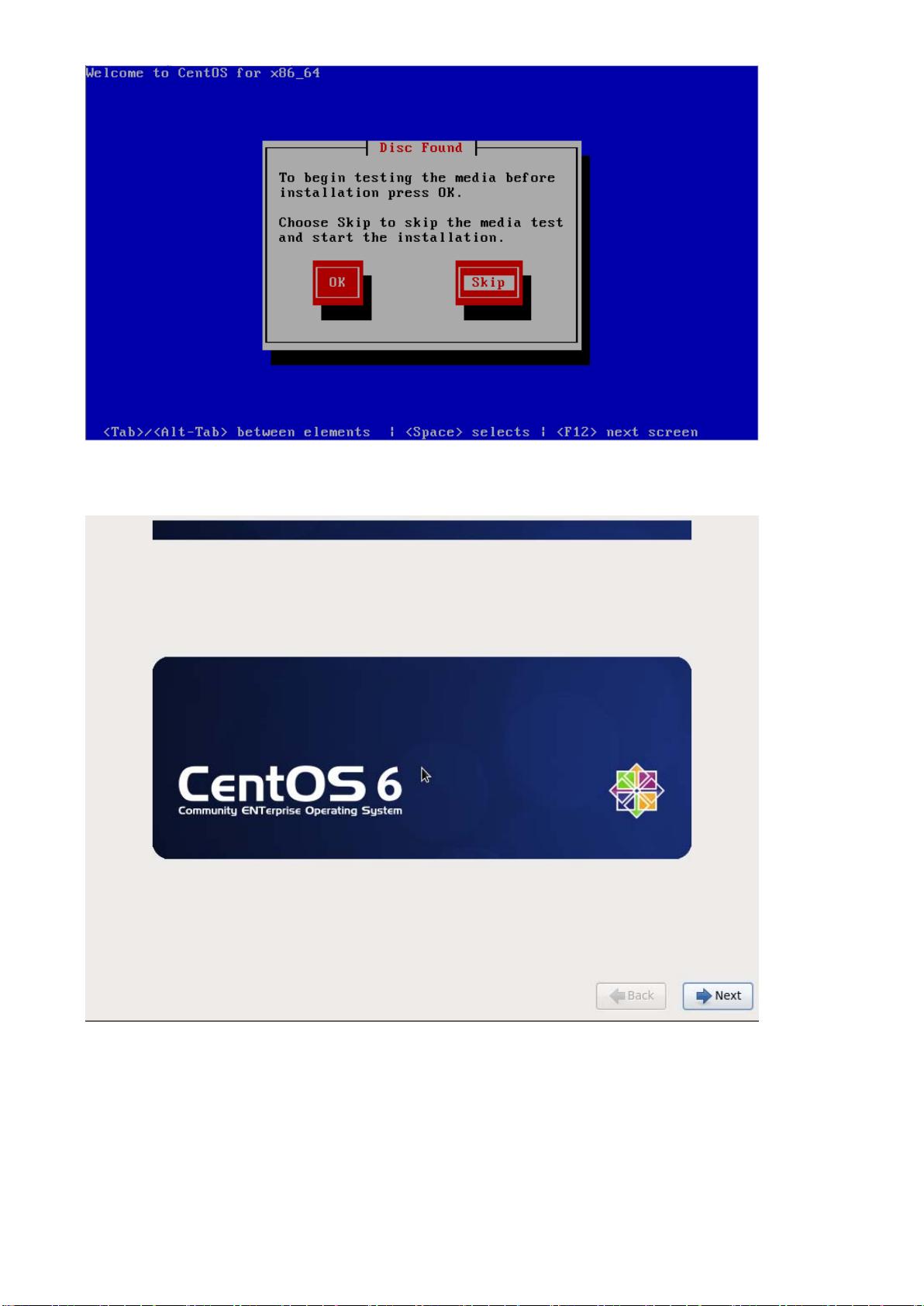

- **安装操作系统**:首先在Windows上创建一个CentOS 6.5 64位虚拟机。

- **系统环境设置**:

- 设置机器名和IP地址,以及Host映射文件,以便集群内部通信。

- 关闭防火墙和SELinux,以提高系统安全性。

- 更新OpenSSL,确保安全连接。

- 配置SSH无密码登录,简化运维操作。

- 安装JDK和Scala,这些是Spark运行的基础。

- **集群环境配置**:

- 复制样板机到其他节点,保持一致的配置。

- 设置每个节点的机器名和IP地址。

- 确保所有节点间的SSH免密登录。

- 可选地,设置机器启动模式。

3. **问题与解决方案**

- 文中提到的问题包括在安装CentOS时遇到的特定硬件兼容性问题(如Intel VT-x被禁用),以及如何解决sudoers文件权限问题等。

通过这篇文章,读者将学习到如何在虚拟化环境中为Spark构建基础环境,这对于理解和部署Spark分布式计算框架至关重要。对于想要进行大数据处理或分布式计算的开发者来说,理解并掌握这些基础设置步骤是不可或缺的。

2018-04-04 上传

2018-04-04 上传

2018-04-04 上传

2019-07-21 上传

2017-07-11 上传

2022-02-17 上传

2018-04-04 上传

2018-04-04 上传

l691635239

- 粉丝: 0

- 资源: 5

最新资源

- Apress Beginning PL/SQL From Novice to Professional Aug 2007

- ARM教程全集_是你进入ARM好帮手

- Python 中文手册

- DFD introduction

- STM32F10x参考手册

- 2006年下半年软件设计师试卷

- GDB不完全手册.doc

- Makefile详细操作指南.pdf

- gdb中文操作手册-debug

- 数据库第四版答案王珊主编

- stc12c4051ad

- QC API 编程实践,有点技术含量的好东东!

- 数据结构的链式基数排序

- div+css网页设计

- ubuntu8.04速成手册1.0pdf

- 基于FPGA的快速浮点除法器IP核的实现