深度学习中的神经微分方程模型

需积分: 0 37 浏览量

更新于2024-07-17

收藏 3.81MB PDF 举报

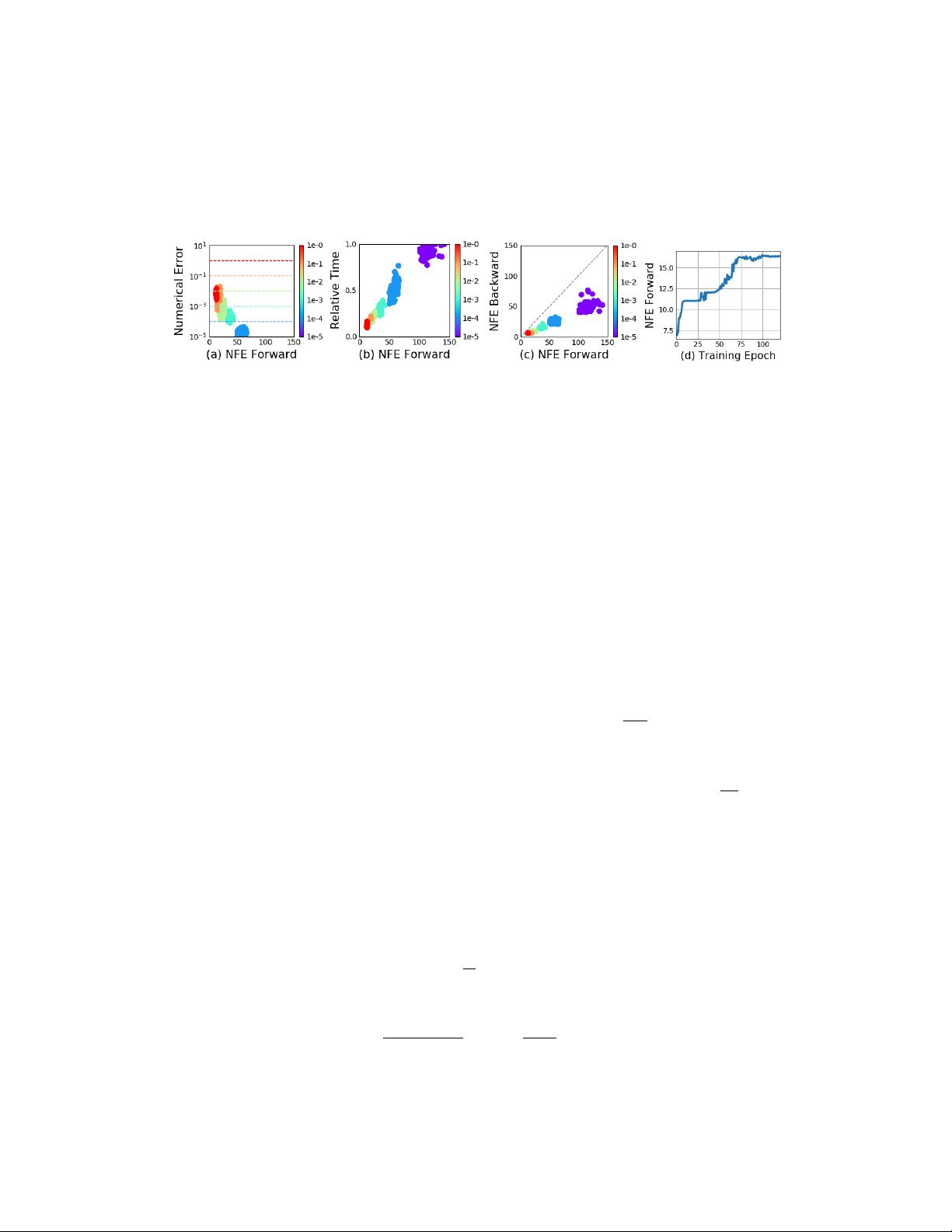

"这篇论文‘Neural Ordinary Differential Equations’由Ricky T. Q. Chen、Yulia Rubanova、Jesse Bettencourt和David Duvenaud等人撰写,来自多伦多大学和Vector Institute,主要探讨了一种新的深度神经网络模型——微分神经网络。该模型参数化隐藏状态的导数,利用神经网络来实现,通过黑盒微分方程求解器计算网络输出。这种连续深度模型具有恒定的内存成本,可以根据输入自适应地调整评估策略,并能明确地在数值精度和速度之间进行权衡。"

正文:

这篇论文引入的"Neural Ordinary Differential Equations(NDEs)"是一种深度学习的新方法,它改变了传统神经网络的设计思路。传统的深度学习模型通常由一系列离散的隐藏层组成,而NDEs则是通过定义隐藏状态的微分方程来建模,这使得模型能够以连续的方式表达复杂的动态过程。

在NDEs中,隐藏状态的演化不再通过固定结构的层进行,而是由一个神经网络来描述其时间导数。这个神经网络称为“微分方程网络”,它输出的是隐藏状态随时间变化的速度。通过使用黑盒微分方程求解器,我们可以得到隐藏状态在任意时间点的值,这种方法允许模型根据输入数据的特性动态地改变其处理方式。

论文展示了NDEs在连续深度残差网络和连续时间潜变量模型中的应用。连续深度残差网络(Continuous Residual Networks)扩展了传统的残差网络概念,使其能够在连续的时间域中工作,这有助于捕捉更精细的动态行为。另一方面,连续时间潜变量模型则提供了一种处理时间序列数据的新途径,它可以更好地模拟真实世界中连续变化的过程。

此外,论文还介绍了连续归一化流(Continuous Normalizing Flows),这是一种生成模型,它能够通过最大似然训练,无需对数据维度进行分区或排序。这一创新使得模型在训练时能更加灵活高效。

在训练方面,论文提出了一种方法,可以端到端地通过任何微分方程求解器进行反向传播,即使无法访问求解器的内部操作。这极大地扩展了NDEs在大型模型中的应用可能性,使得整个系统可以作为一个整体进行优化。

"Neural Ordinary Differential Equations"这篇论文为深度学习领域带来了革命性的创新,它将微分方程的概念融入神经网络,创建出更为灵活且适应性强的模型,对于理解和建模动态系统提供了新的工具和思路。这些模型不仅在理论上有重要意义,而且在实际应用中也展示出了强大的潜力,特别是在处理连续时间序列数据和生成模型的任务上。

366 浏览量

189 浏览量

179 浏览量

156 浏览量

133 浏览量

106 浏览量

293 浏览量

356 浏览量

261 浏览量

爱吃肉的悟空

- 粉丝: 105

- 资源: 12

最新资源

- 微信小程序-点餐

- ionicStudyWithTabs:带有 ngCordova 的离子模板项目

- note-taker

- XIANDUAN.rar

- 一种基于高通量测序的拷贝数变异检测自动化分析解读及报告系统.rar

- rasaxproject1

- GitHub Open All Notifications-crx插件

- gatsby-remark-component-images:一个Gatsby注释插件,将gatsby-plugin-sharp处理应用于html样式的markdown标签

- 易语言开关音频服务实现开关声音-易语言

- ComposeKmmMoviesApp

- HistogramComponentDemo.7z

- UA GPU-able Search-crx插件

- MYSQL数据库管理器(易语言2005年大赛三等奖)2010-10-27.rar

- native-api-notification-[removed]JavaScript中的本机通知API

- 将超像素作为输入MATLAB代码-laplacianseg:种子图像分割的拉普拉斯坐标

- MyDroid