Hadoop源代码深度解析:关键组件与依赖揭秘

需积分: 9 45 浏览量

更新于2024-07-20

收藏 5.91MB DOC 举报

Hadoop源代码分析深入探讨了Google的核心技术之一——分布式云计算平台,这个平台由一系列关键技术组成,包括Google Cluster、Chubby、GFS、BigTable和MapReduce。随着Apache社区对这些技术的开源实现,Hadoop项目应运而生,将这些技术进行了集成并发展,其中:

1. Chubby在Hadoop中被替换为ZooKeeper,负责分布式环境中的命名服务和统一认证。

2. Google File System (GFS) 的开源版本是Hadoop Distributed File System (HDFS),它作为分布式文件系统,为Hadoop生态系统提供了基础,允许数据在多台机器之间高效地存储和访问。

3. BigTable的开源对应是HBase,一个分布式数据库,适合大规模数据的存储和查询。

4. MapReduce的核心思想被Apache Hadoop发扬光大,成为了处理大数据的基石。

Hadoop的包结构和依赖关系较为复杂,这是因为它设计为一个高度模块化的框架,可以适应多种存储选项。例如,conf包依赖于fs包,因为配置文件的读取需要文件系统服务,而fs包又包含了对底层文件系统功能的抽象。这种设计使得Hadoop能够灵活地处理不同类型的存储,包括本地文件系统、分布式文件系统以及云存储服务,如Amazon S3。

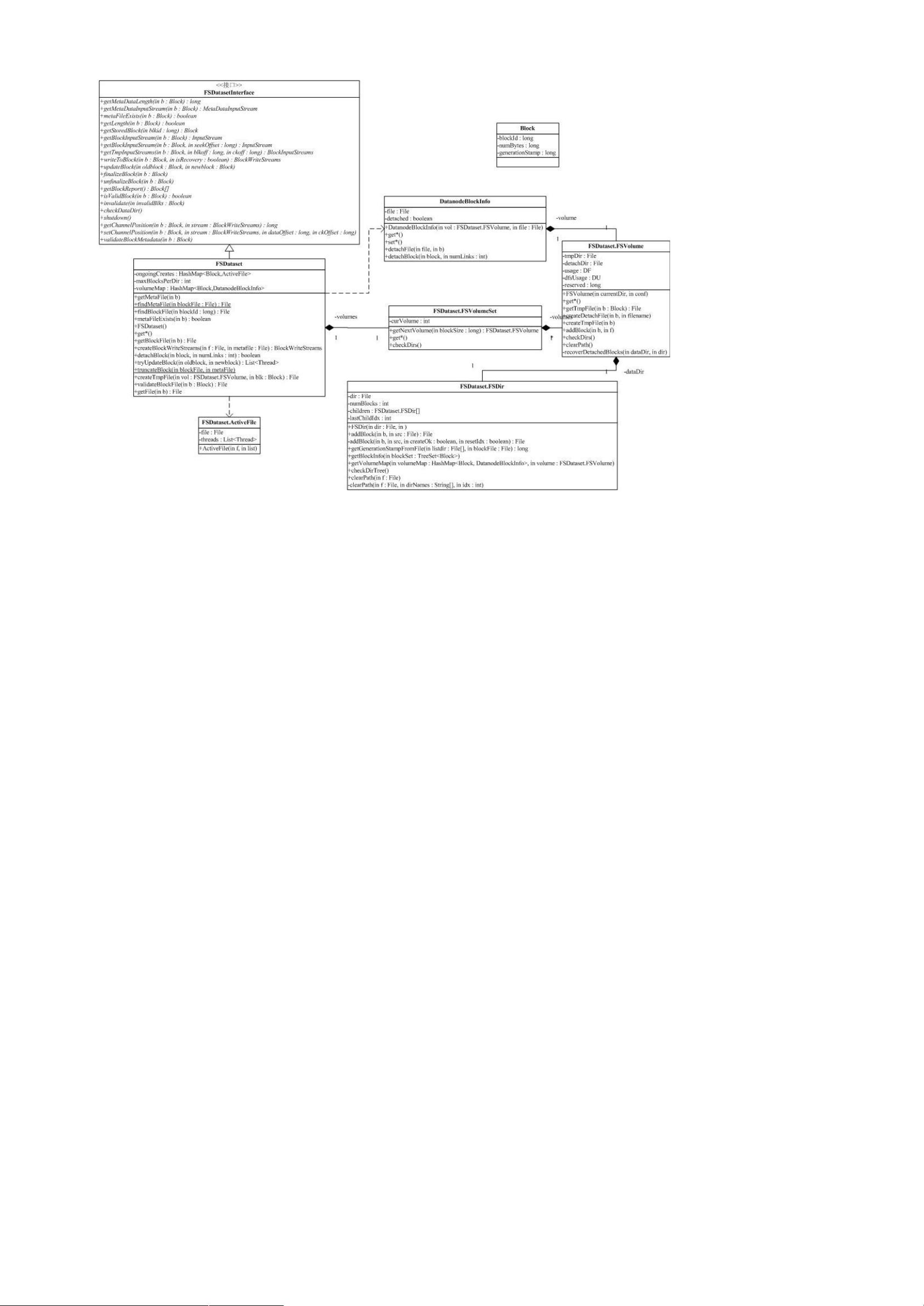

Hadoop的关键部分集中在图示中的蓝色区域,主要包括HDFS、MapReduce、YARN(Yet Another Resource Negotiator,任务调度器)、Hive(用于数据分析的工具)等组件。这些组件共同构建了一个强大的大数据处理平台,支持海量数据的分布式处理和分析。

理解HDFS有助于深入学习整个Hadoop生态系统,因为它是所有应用的基础。通过研究Hadoop的源代码,开发者可以洞察其分布式计算模型、数据存储策略、任务调度算法等核心原理,从而优化性能、解决故障和扩展系统能力。

在进行Hadoop源代码分析时,需要关注代码的组织结构、API接口、错误处理机制、线程管理以及资源管理等方面,这些都是确保Hadoop在实际生产环境中稳定运行的关键。同时,对于分布式系统的理解和分布式编程的经验也是必不可少的。随着Hadoop的不断迭代和发展,新的技术和优化也会融入到源代码中,因此持续学习和跟进最新进展也是开发者必备的素养。

2022-06-18 上传

2020-01-19 上传

2024-04-22 上传

2021-10-03 上传

2020-08-28 上传

2024-06-28 上传

127 浏览量

点击了解资源详情

点击了解资源详情