深度学习模型压缩与加速技术探析

140 浏览量

更新于2024-08-28

收藏 363KB PDF 举报

"深度学习模型压缩与加速综述"

在深度学习领域,模型压缩与加速是当前研究的热点问题,尤其对于资源有限的移动端设备来说,高效利用计算资源和存储空间至关重要。模型压缩主要目的是减小模型大小,降低计算复杂度,而加速网络设计则旨在在保持性能的同时,提高模型运行速度。

一、分组卷积

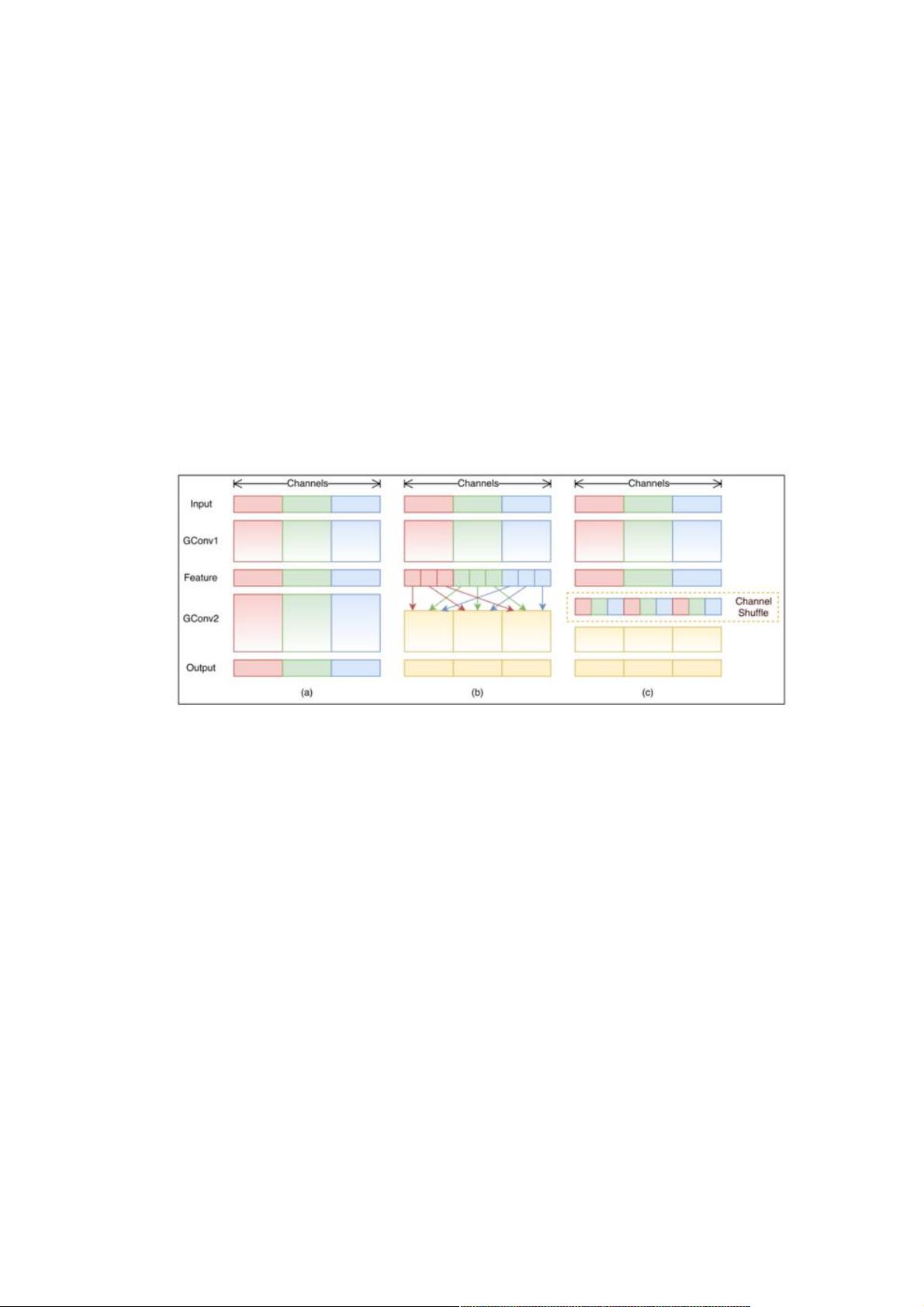

分组卷积是一种有效的模型压缩技术,它将输入特征映射(featuremaps)分为多个组,并对每个组独立执行卷积操作。这减少了参数数量和计算量,但可能导致不同组间的特征信息交流减少。为解决这一问题,出现了两种经典结构:ShuffleNet和MobileNet。

1) ShuffleNet结构:

ShuffleNet通过引入通道混洗操作解决了分组卷积的信息流通问题。在普通的分组卷积中,输出通道只与输入的特定通道相关,ShuffleNet则通过通道混洗确保了全局信息的流通,增强了网络的表达能力。

2) MobileNet结构:

MobileNet的核心是深度可分离卷积(depthwise separable convolutions),它将标准卷积分解为深度卷积(depthwise convolution)和1x1点卷积(pointwise convolution)。深度卷积针对每个通道单独进行,显著降低了计算量,随后的1x1卷积用于通道间的信息融合,进一步减少了计算成本。

二、分解卷积

分解卷积是另一种压缩策略,它将标准卷积分解为更小的卷积,例如将一个大核的卷积分解为几个小核的卷积。这种方法可以有效地减少参数数量,同时保持模型的表达能力。例如,可以将一个大尺寸的卷积核分解为多个小尺寸的卷积核组合,通过这种方式减少计算量,而不牺牲太多性能。

三、其他压缩与加速技术

除了分组卷积和分解卷积,还有其他技术也常用于模型压缩与加速,例如:

1) 权重量化:将模型的浮点权重转换为低精度整数,以减少存储需求并加快计算速度。

2) 模型剪枝:删除模型中对性能影响较小的权重或连接,精简网络结构。

3) 知识蒸馏:大型模型(教师模型)的输出被用来训练小型模型(学生模型),使学生模型能学习到教师模型的高级表示,同时保持较小的规模。

4) 弹性平均:在训练过程中使用一个移动平均版本的权重,可以提高模型的稳定性和推理速度。

深度学习模型压缩与加速的目标是在保证模型性能的前提下,优化模型的效率,使其能够在各种硬件平台上顺畅运行,尤其是在资源受限的移动设备上。随着研究的深入,更多创新的压缩与加速技术将持续涌现,推动深度学习的应用边界不断扩展。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-10-02 上传

2021-08-18 上传

点击了解资源详情

2020-08-20 上传

2020-08-23 上传

点击了解资源详情

weixin_38515897

- 粉丝: 2

- 资源: 961

最新资源

- 有100名囚犯让他们依次站成一排国王命令手下先干掉全部奇数位置处的人 再次干掉全部奇数位置处的直到最后剩下一个人为止剩最后幸存者

- 近箭牌

- MatrixOptim.jl:矩阵不确定性下的数据驱动决策

- CC2530-LedDemo.zip

- octo:JavaScript中的模糊库。 :sparkles:

- 数学建模-离散数学导论(第三版).zip

- 一款自定义的滑杆(Slider)(iOS源代码)

- Bing Pages-crx插件

- todolist-react:React的待办事项清单

- 位置优化

- 参考资料-力学传感器与单片机的接口设计.zip

- 状态:www.magicrobots.com:目前是使用ember-js构建的UNIX风格的命令行界面网站。 情侣游戏

- MVVM4Swift(iPhone源代码)

- cubemx移植精英版正点原子lcd

- streamlit_sanskrit:通过流式显示梵语

- 通知者:Aplicacion ejercicio PWA