ASCII码表详解:二进制与字符间的转换桥梁

需积分: 9 128 浏览量

更新于2024-09-16

收藏 28KB DOCX 举报

ASCII码表详细完全

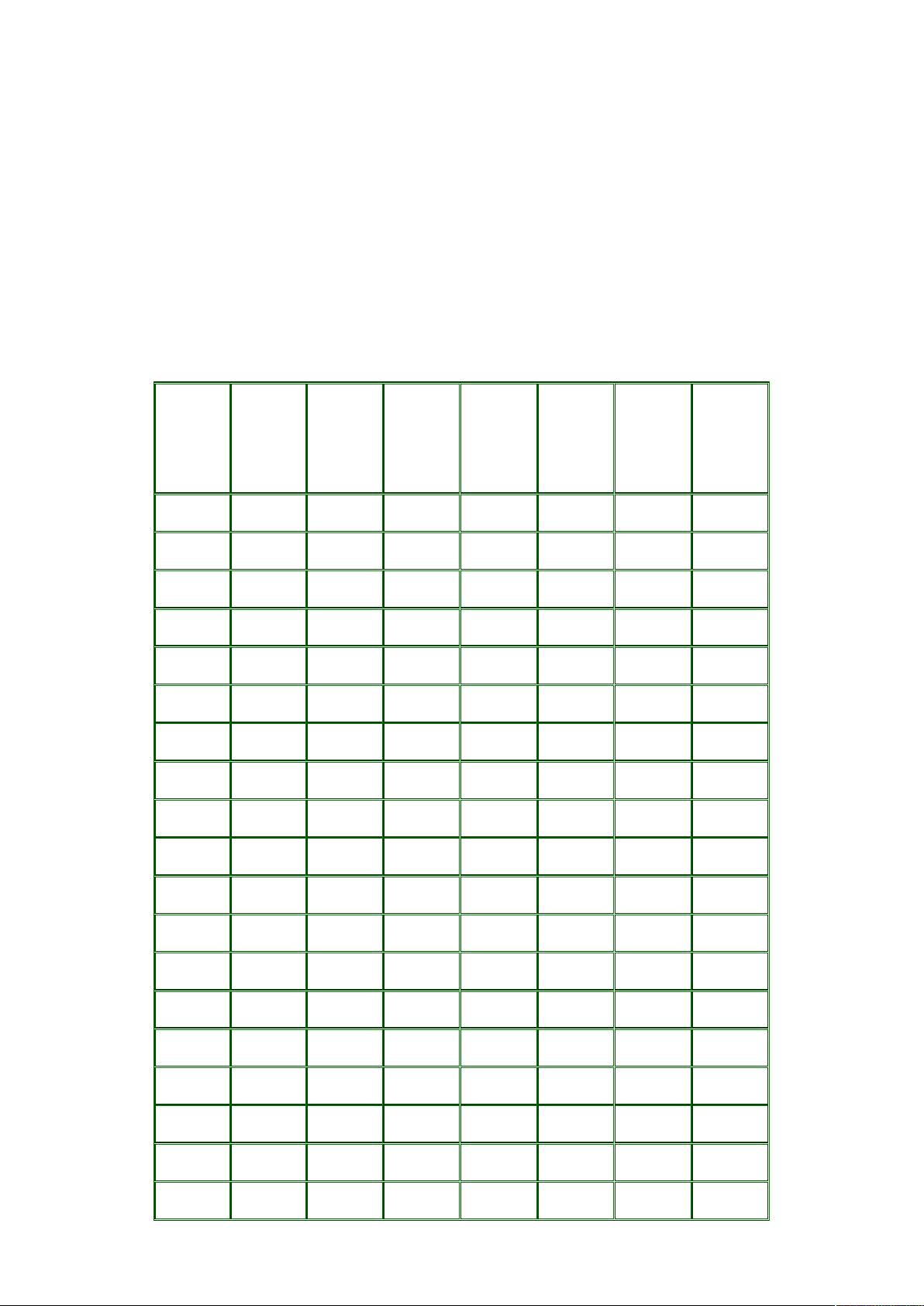

ASCII码表是计算机科学中的基础概念,它是一种字符编码标准,全称为美国信息交换标准代码(American Standard Code for Information Interchange),主要用于在计算机系统之间进行文本数据的标准化表示。ASCII码表最初是在20世纪50年代由美国制定,以解决早期计算机之间的通信问题,确保字符的一致性和兼容性。

ASCII码表采用的是7位二进制编码方式,能够表示128个不同的字符。这个编码系统将字符分为控制字符、数字字符、大写英文字母和小写英文字母四类。具体来说,ASCII码表按照以下结构进行:

1. **控制字符** (0-31): 包括各种控制信号,如起始字符(SOH)、结束字符(ETX)、回车(CR)、换行(LF)等,用于设备间的通信控制。

2. **特殊字符** (32-126): 主要包含非打印字符,如空格、制表符、分号、引号等,用于文本格式化和标点符号。

3. **数字字符** (48-57): 十进制数字0-9。

4. **大写英文字母** (65-90): A-Z。

5. **小写英文字母** (97-122): a-z。

值得注意的是,ASCII码表中的某些字符是扩展的,比如通过扩展ASCII(Extended ASCII)或Unicode来支持更多的字符,包括非拉丁字母和特殊符号。然而,随着计算机技术的发展,现代计算机系统通常使用Unicode编码,因为它能够处理更广泛的字符集。

在计算机内部,ASCII码是通过二进制形式存储的,对于用户来说,这些二进制数值会通过输入设备(如键盘)转换成可读的字符,输出设备(如显示器)则将这些字符编码转换为可见的字符显示。通过ASCII码表,人类和机器之间能够有效地交流和处理文本信息,这是计算机网络和通信的核心基础之一。

ASCII码表在信息技术领域具有重要地位,它是早期计算机系统的基础,并对现代计算机系统的字符编码标准产生了深远影响。理解和掌握ASCII码表有助于程序员、网络管理员以及任何与文本处理相关的专业人士更好地进行数据传输和处理。

2024-06-14 上传

2022-05-05 上传

2008-04-20 上传

点击了解资源详情

点击了解资源详情

2021-09-17 上传

2009-11-20 上传

2011-11-30 上传

HCY

- 粉丝: 7

- 资源: 59

最新资源

- MATLAB实现小波阈值去噪:Visushrink硬软算法对比

- 易语言实现画板图像缩放功能教程

- 大模型推荐系统: 优化算法与模型压缩技术

- Stancy: 静态文件驱动的简单RESTful API与前端框架集成

- 掌握Java全文搜索:深入Apache Lucene开源系统

- 19计应19田超的Python7-1试题整理

- 易语言实现多线程网络时间同步源码解析

- 人工智能大模型学习与实践指南

- 掌握Markdown:从基础到高级技巧解析

- JS-PizzaStore: JS应用程序模拟披萨递送服务

- CAMV开源XML编辑器:编辑、验证、设计及架构工具集

- 医学免疫学情景化自动生成考题系统

- 易语言实现多语言界面编程教程

- MATLAB实现16种回归算法在数据挖掘中的应用

- ***内容构建指南:深入HTML与LaTeX

- Python实现维基百科“历史上的今天”数据抓取教程