Hadoop源代码深度解析:Google云计算核心技术与Apache开源项目

需积分: 9 41 浏览量

更新于2024-07-25

收藏 5.91MB DOC 举报

Hadoop是一个开源的分布式计算框架,最初由Google的工程师们开发并用于处理大规模数据集,特别是用于云计算环境。它的核心竞争力源于其五个关键组件,即GoogleCluster、Chubby、GFS、BigTable和MapReduce。这些技术构成了Google的计算基础设施,后来在Apache上发展成了Hadoop项目,并分别对应着:

1. Chubby(ZooKeeper):Google的Chubby是一个分布式锁服务,提供了强一致性的关键值存储,而ZooKeeper是Hadoop中的一个类似服务,用于维护集群的状态和配置信息。

2. GFS(Google File System):这是一个分布式文件系统,被Hadoop的HDFS所取代,HDFS(Hadoop Distributed File System)是一个高效、可靠的分布式文件系统,支持大规模数据存储和处理。

3. BigTable:一个分布式数据库系统,HBase是其开源版本,用于存储和管理结构化和半结构化的海量数据,与Hadoop集成提供强大的数据分析能力。

4. MapReduce:Google的并行编程模型,被Hadoop的MapReduce实现,这是一种分布式数据处理模型,将复杂的计算任务分解为一系列可并行执行的小任务。

Hadoop的设计理念是将计算任务分布在网络上的多台机器上,通过数据的分片和并行处理来提高性能和容错性。HDFS作为基础,允许数据在集群节点间透明地存储和访问,而MapReduce则负责处理这些数据,执行各种计算操作。

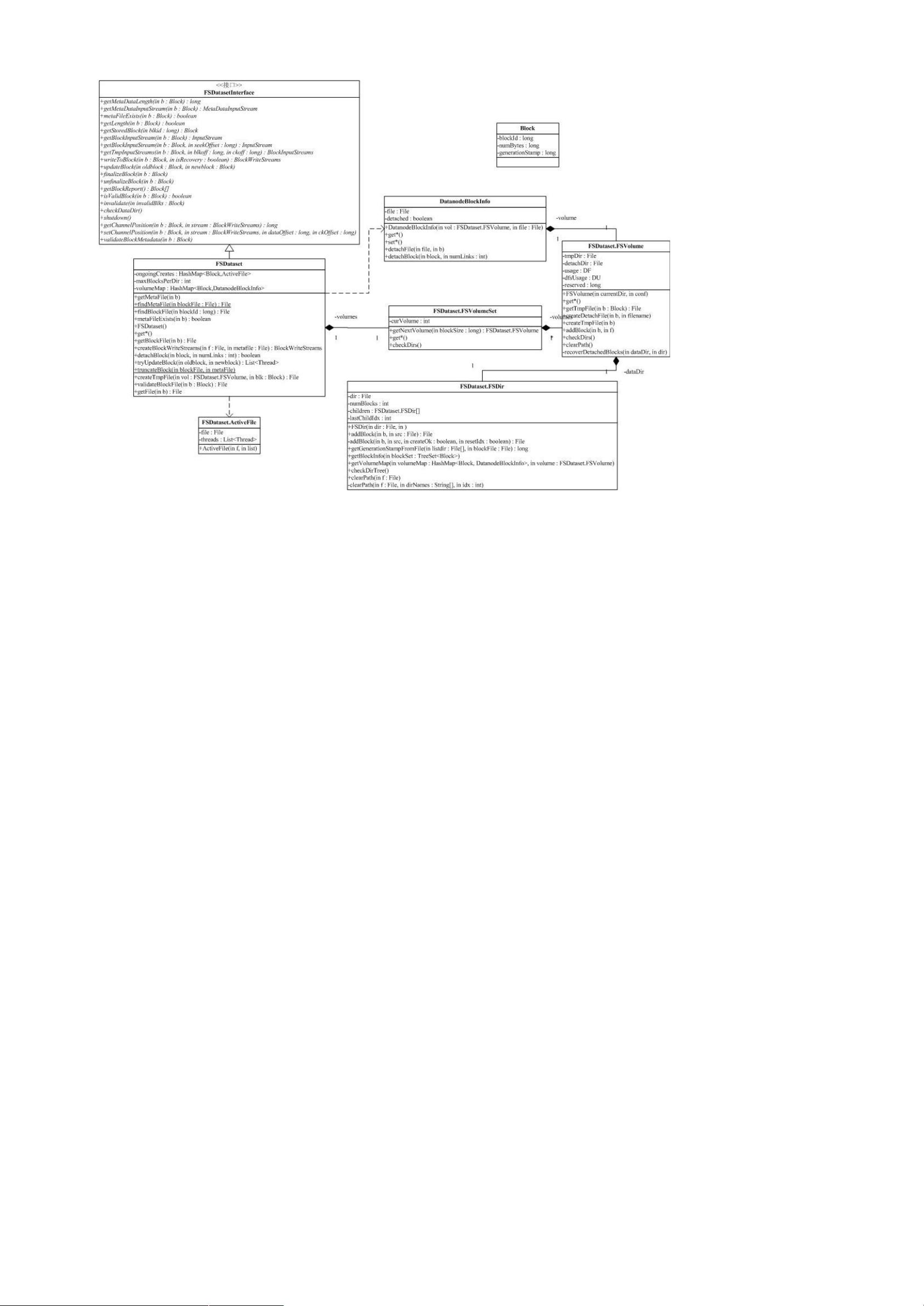

在Hadoop的源代码分析中,重点在于理解蓝色部分所示的组件,包括HDFS和MapReduce。HDFS的复杂依赖关系反映了分布式文件系统设计的挑战,如对底层实现的抽象,以及配置管理的需求。此外,工具包(如conf)与fs的交互也展示了Hadoop在组织功能时的层次结构。

通过深入学习Hadoop源代码,开发者可以理解分布式计算架构的设计原则,提高对大数据处理和云计算的理解,同时也能适应不断涌现的基于类似思想的开源项目,如Facebook的Hive,它们都是大数据技术生态系统中的重要组成部分。

773 浏览量

2017-10-31 上传

2018-12-15 上传

2023-07-13 上传

2023-05-23 上传

2023-10-14 上传

2023-06-05 上传

2023-06-13 上传

2023-12-20 上传

u010800988

- 粉丝: 0

- 资源: 2

最新资源

- Hadoop生态系统与MapReduce详解

- MDS系列三相整流桥模块技术规格与特性

- MFC编程:指针与句柄获取全面解析

- LM06:多模4G高速数据模块,支持GSM至TD-LTE

- 使用Gradle与Nexus构建私有仓库

- JAVA编程规范指南:命名规则与文件样式

- EMC VNX5500 存储系统日常维护指南

- 大数据驱动的互联网用户体验深度管理策略

- 改进型Booth算法:32位浮点阵列乘法器的高速设计与算法比较

- H3CNE网络认证重点知识整理

- Linux环境下MongoDB的详细安装教程

- 压缩文法的等价变换与多余规则删除

- BRMS入门指南:JBOSS安装与基础操作详解

- Win7环境下Android开发环境配置全攻略

- SHT10 C语言程序与LCD1602显示实例及精度校准

- 反垃圾邮件技术:现状与前景