Apache Flink:统一流批处理的大数据引擎

147 浏览量

更新于2024-08-29

收藏 558KB PDF 举报

Apache Flink是当前数据处理领域的重要开源项目,它专注于分布式数据流处理和批量数据处理,旨在为用户提供一个统一的平台来应对不同类型的应用需求,如流处理和批处理。Flink的核心理念是将流处理视为无限数据流,而批处理则作为有界数据流的特殊形式,这与传统的解决方案如MapReduce、Samza、Storm和Spark等有着显著区别。

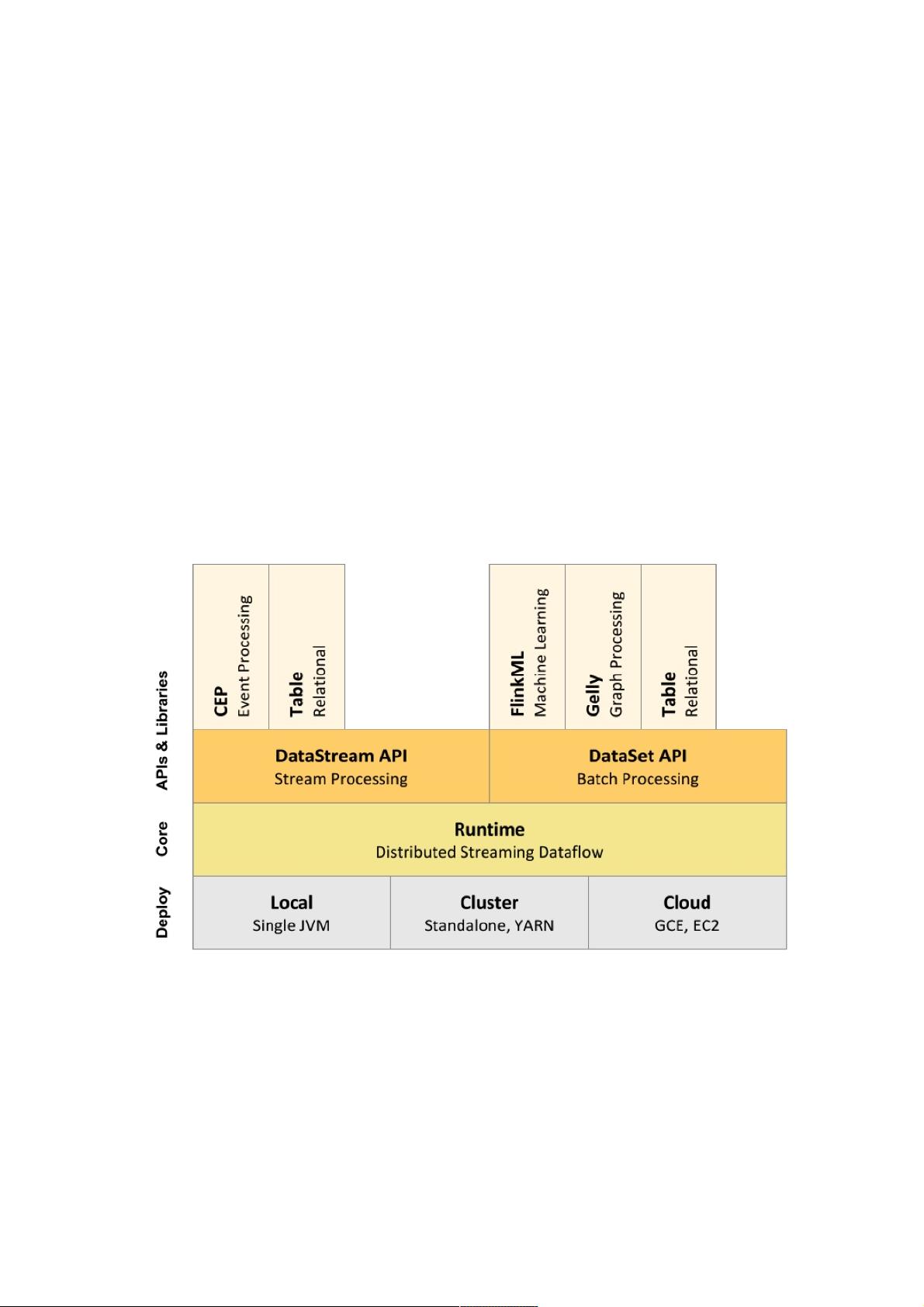

Flink的设计目标是简化开发者在处理实时和批量数据时的选择,通过其FlinkRuntime,Flink提供了一致的编程模型,支持流处理API和批处理API,使得开发者无需为每种类型的任务编写单独的代码。这种统一性使得Flink在处理低延迟、Exactly-once保证的流处理任务以及高吞吐、高效处理的批处理任务时都表现出色。

在内存管理和语言实现方面,Flink与Spark有所不同。Spark倾向于使用RDD作为核心抽象,而在Flink中,尽管早期版本也依赖于类似的概念,但后续版本更加强调了内存管理和流处理的优化。Flink通过引入DataStream API和Table API,提供了更直观和高效的编程接口,支持SQL查询,进一步提升了用户体验。

在性能和扩展性方面,Flink以其低延迟、高吞吐量和容错能力闻名,特别适合实时分析和复杂事件处理。然而,与Spark相比,Flink在易用性和社区生态上可能稍显不足,特别是对于初学者来说,Spark的用户基础和丰富的生态系统可能更具吸引力。

总结来说,Apache Flink是大数据处理领域的一股重要力量,通过其独特的设计理念和统一的编程模型,为实时和批量数据处理提供了强大的工具。理解和掌握Flink,可以帮助开发人员更有效地处理大规模数据,并且能够在日益竞争激烈的数据处理市场中脱颖而出。

2020-06-28 上传

2022-04-20 上传

2021-12-03 上传

点击了解资源详情

2019-04-19 上传

2019-09-18 上传

2021-03-25 上传

weixin_38551143

- 粉丝: 3

- 资源: 937

最新资源

- Haskell编写的C-Minus编译器针对TM架构实现

- 水电模拟工具HydroElectric开发使用Matlab

- Vue与antd结合的后台管理系统分模块打包技术解析

- 微信小游戏开发新框架:SFramework_LayaAir

- AFO算法与GA/PSO在多式联运路径优化中的应用研究

- MapleLeaflet:Ruby中构建Leaflet.js地图的简易工具

- FontForge安装包下载指南

- 个人博客系统开发:设计、安全与管理功能解析

- SmartWiki-AmazeUI风格:自定义Markdown Wiki系统

- USB虚拟串口驱动助力刻字机高效运行

- 加拿大早期种子投资通用条款清单详解

- SSM与Layui结合的汽车租赁系统

- 探索混沌与精英引导结合的鲸鱼优化算法

- Scala教程详解:代码实例与实践操作指南

- Rails 4.0+ 资产管道集成 Handlebars.js 实例解析

- Python实现Spark计算矩阵向量的余弦相似度