PLSA与EM算法详解:概率语言模型中的核心技术

下载需积分: 14 | PDF格式 | 1.3MB |

更新于2024-07-17

| 38 浏览量 | 举报

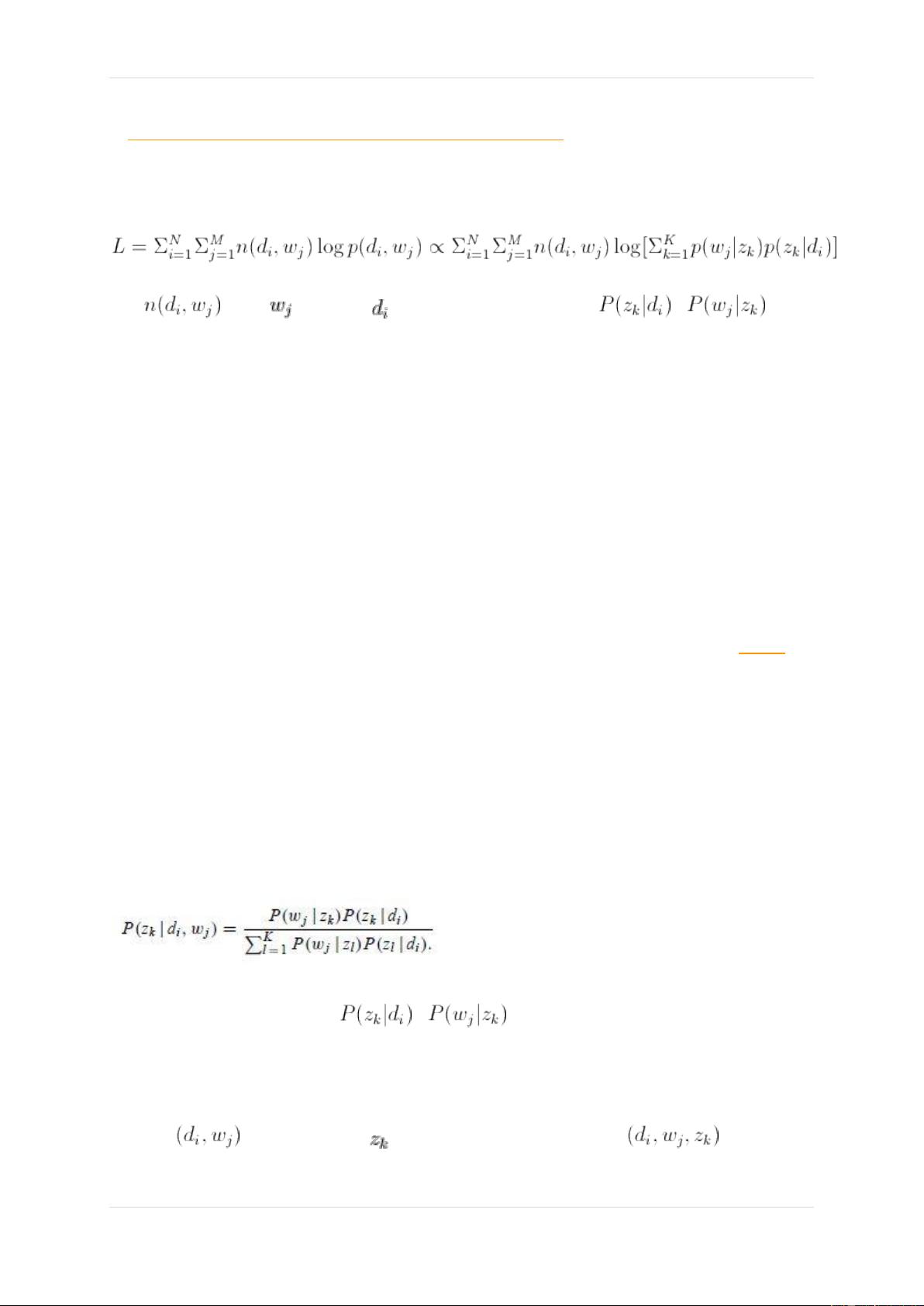

PLSA (Probabilistic Latent Semantic Analysis) 及 EM 算法是概率语言模型的重要组成部分,它们在大数据分析和自然语言处理中扮演着关键角色。PLSA 是一种隐式主题模型,它通过引入潜在语义来解决传统词袋模型的一词多义和一义多词问题。在词项文档矩阵中,PLSA 使用SVD (奇异值分解) 技术将复杂的词汇空间转换为较低维度的表示,这有助于减少误差并提高模型的解释性。

EM (Expectation Maximization) 算法在此过程中扮演了参数估计的角色。EM 是一种迭代优化方法,特别适合于那些包含不可观测隐变量的概率模型,如PLSA中的潜在主题。在PLSA中,每个文档被假设为由多个潜在主题的混合而成,而每个主题又有自己的词分布。EM算法分为两个步骤:

1. 期望步(Expectation):在给定当前参数估计的情况下,计算每个文档中每个主题的混合比例和每个主题的词分布的期望值,这一步涉及对隐变量的期望。

2. 最大化步(Maximization):基于期望步得到的期望值,更新模型参数以最大化似然函数,通常使用这些期望值作为真实数据的近似,即使实际数据不可见。

在应用PLSA时,通过EM算法可以估计混合语言模型中词项的概率以及混合高斯模型GMM的参数,从而更好地理解文档的主题分布。整个过程是一个迭代的过程,直到模型收敛或达到预设的迭代次数。

然而,为了进一步改进PLSA,LDA (Latent Dirichlet Allocation) 被提出,它引入了超参数,并且通常采用Gibbs Sampling来进行参数估计,相比于EM,Gibbs Sampling是一种马尔可夫链蒙特卡洛(MCMC)方法,能够在大规模数据集上进行更有效的估计。在后续的系列文章中,会详细介绍LDA及其变体,如Twitter LDA、TimeUserLDA、ATM、Labeled-LDA和MaxEnt-LDA等,这些模型在特定场景下具有更高的灵活性和性能。

PLSA与EM算法结合,为理解和分析文本数据提供了强大的工具,广泛应用于信息检索、文本分类、情感分析等多个领域,是现代数据科学和人工智能中的基础技术之一。

相关推荐

maxwelltanplus

- 粉丝: 1

最新资源

- 实现大图倒影效果的源码工具介绍

- PHP版Google PageRank查询工具源码发布

- C++高效日志打印技巧与实践

- 2018版北大及科技核心目录专业汇编

- USB CDC类代码移植教程与正点原子开发板应用

- 实现双选系统前端页面的核心开发工作

- 探索Div左侧菜单栏的实现与源码解析

- 游戏地图制作利器:全面的2D与2.5D编辑器工具

- 部署Opengrok查看源码环境指南

- C#中GDAL301版本DLL文件集

- 网奇CMS v5.7:功能全面的.NET网站管理系统

- 网页设计利器PicPick:便捷的源码工具使用教程

- Tomcat8.0解压版使用与说明

- 实现基于JAVA的简易网络资源下载器

- JavaWeb标签大全的开发与编辑技巧

- Matlab GUI布局工具箱:ButtonGroupforHG2组件开发