机器学习十大算法详解:从入门到理解

版权申诉

134 浏览量

更新于2024-07-02

1

收藏 1.84MB DOCX 举报

"本文档主要介绍了机器学习中的十大常用算法,旨在让读者轻松理解这些算法的基本概念和应用场景。没有复杂的数学推导,而是通过简洁的解释和示例来介绍。"

在机器学习领域,掌握常见的算法是至关重要的。以下是文档中提到的十大常用算法:

1. 马尔可夫决策过程 (Markov Decision Process, MDP):马尔可夫决策过程是一种统计模型,用于描述一个随时间的动态系统,其中未来状态只依赖于当前状态,不依赖于过去的历史状态。MDP常用于强化学习,帮助智能体在环境中学习最优策略。

2. 决策树 (Decision Tree):决策树是一种监督学习算法,主要用于分类和回归任务。通过树状结构进行决策,每个内部节点代表一个特征测试,每个分支代表一个测试输出,而叶节点则对应类别标签或连续值。

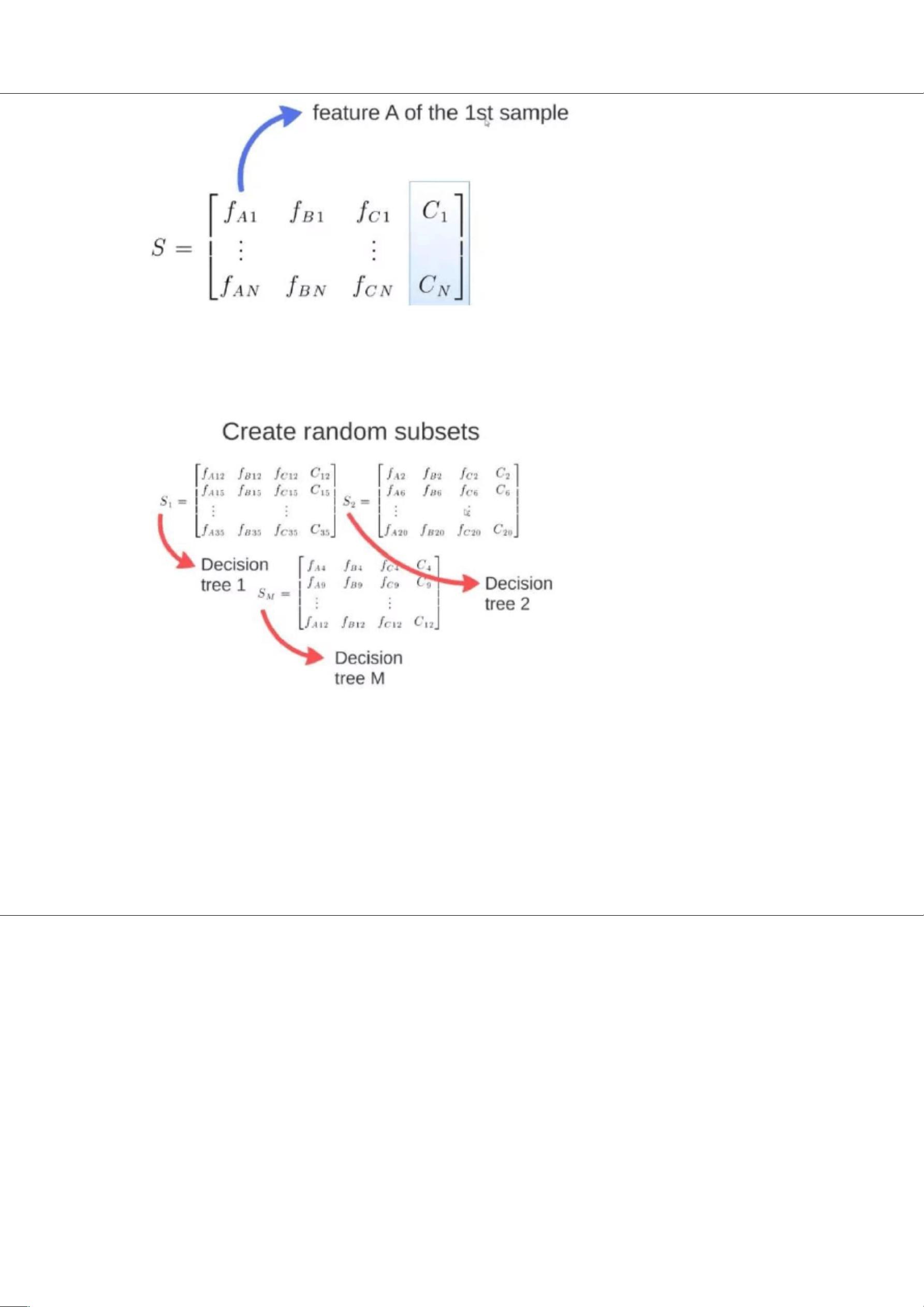

3. 随机森林 (Random Forest):随机森林是基于多个决策树的集成学习方法,通过随机选择特征和样本构建多棵决策树,然后取多数投票或平均值作为最终预测结果,增强了模型的稳定性和准确性。

4. 支持向量机 (Support Vector Machine, SVM):SVM是一种二分类模型,寻找最优超平面将数据分为两类,使两类之间的间隔最大化。当数据线性不可分时,可以使用核函数(如高斯核)实现非线性分类。

5. 逻辑回归 (Logistic Regression):虽然名字中有“回归”,但逻辑回归实际上是用于分类任务的。通过sigmoid函数将线性模型的输出映射到(0,1)之间,表示概率。对于二分类问题,概率大于0.5的归为一类,小于0.5的归为另一类。

6. 朴素贝叶斯 (Naive Bayes):朴素贝叶斯是一种基于贝叶斯定理的分类方法,假设特征之间相互独立,从而简化了模型。尽管这个假设在实际中往往过于简单,但在很多情况下仍然表现出良好的性能。

7. K近邻 (K-Nearest Neighbors, KNN):KNN是一种基于实例的学习,通过找到最近的K个邻居的类别来决定新样本的类别。K值的选择会影响模型的复杂度和泛化能力。

8. Adaboost:Adaboost是一种迭代的弱学习器组合方法,通过加权多数投票的方式,逐步提高弱分类器的性能,最终形成强分类器。

9. 梯度提升机 (Gradient Boosting Machines, GBM):GBM是另一种集成学习方法,通过连续迭代构建一系列弱预测器,并将它们的预测误差作为下一个预测器的输入,以最小化整体误差。

10. 神经网络 (Neural Networks):神经网络是由多层节点(神经元)组成的模型,模仿人脑的工作原理。通过反向传播算法调整权重,以最小化损失函数,适用于多种任务,包括分类、回归和图像识别等。

以上算法在实际问题中各有优势,根据问题类型和数据特性选择合适的算法至关重要。了解这些基础算法能帮助初学者快速入门机器学习,并为进一步深入研究奠定坚实的基础。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-09-29 上传

2019-08-19 上传

2022-12-17 上传

2024-09-29 上传

2022-09-20 上传

2024-09-29 上传

不吃鸳鸯锅

- 粉丝: 8548

- 资源: 2万+

最新资源

- IETI-LAB7-2021

- emd.rar_matlab例程_matlab_

- Xbee-boss:使用Paul Malmstem的python xbee库

- ETL_Project:GWU Bootcamp ETL项目

- OpenCV-MinGW-Build::eyes:MinGW在Windows上编译的OpenCV32位和64位版本。 包括OpenCV 3.3.1、3.4.1、3.4.1-x64、3.4.5、3.4.6、3.4.7、3.4.8-x64、3.4.9、4.0.0-alpha-x64、4.0.0- rc-x64、4.0.1-x64、4.1.0、4.1.0-x64、4.1.1-x64、4.5.0-with-contrib

- data-structures-and-algorithms

- contentful.swift:与Contentful的内容交付API的令人愉快的Swift接口

- StackStockRouter

- speaker_recognition.rar_语音合成_matlab_

- Allow CORS: Access-Control-Allow-Origin-crx插件

- pairgame-heroku

- 参考资料-WI-NK0103公司会议制度管理规定(09.04.30改).zip

- Golang_Homework

- TopAnimes是一个示例动漫Android应用程序-Android开发

- Landing-Page:我的编程产品组合的目标页面

- 快车时间