Hive实战:创建与加载数据到数据仓库

需积分: 0 100 浏览量

更新于2024-08-03

收藏 569KB DOCX 举报

“Hive-数据仓库实战”

在大数据处理领域,Hive是一个至关重要的数据仓库工具,它在数据挖掘、数据聚合以及统计分析中扮演着核心角色。尤其是在电信行业中,Hive被广泛用于分析用户的流量、费用、套餐等信息,帮助企业进行深度的数据洞察,以优化服务和套餐设计。本实验旨在帮助用户掌握Hive的基本操作,并学会通过Hue界面执行HQL(Hive查询语言)。

实验内容分为两个主要任务:Hive创建表和加载数据。

任务一:Hive创建表

Hive提供了创建表的语句,允许用户定义表结构。创建表的基本语法如下:

1. 创建内部表:

内部表是Hive默认的表类型,数据存储在Hive的元数据和HDFS中,由Hive管理。例如,创建一个名为cx_stu01的内部表,包含name、gender和age三个字段,类型分别为string和int,数据以逗号分隔:

```

CREATE TABLE cx_stu01 (name string, gender string, age int) ROW FORMAT DELIMITED FIELDS TERMINATED BY ',' STORED AS TEXTFILE;

```

显示所有表的命令是`SHOW TABLES;`。

2. 创建外部表:

外部表则将数据存储的管理权交给了用户,只在Hive中保存元数据。当删除外部表时,HDFS上的数据不会被删除。创建一个名为cx_stu02的外部表:

```

CREATE EXTERNAL TABLE cx_stu02 (name string, gender string, age int) ROW FORMAT DELIMITED FIELDS TERMINATED BY ',' STORED AS TEXTFILE;

```

任务二:Hive加载数据

在创建了外部表后,需要将数据从本地系统加载到HDFS,然后通过Hive进行访问。以下是一个示例流程:

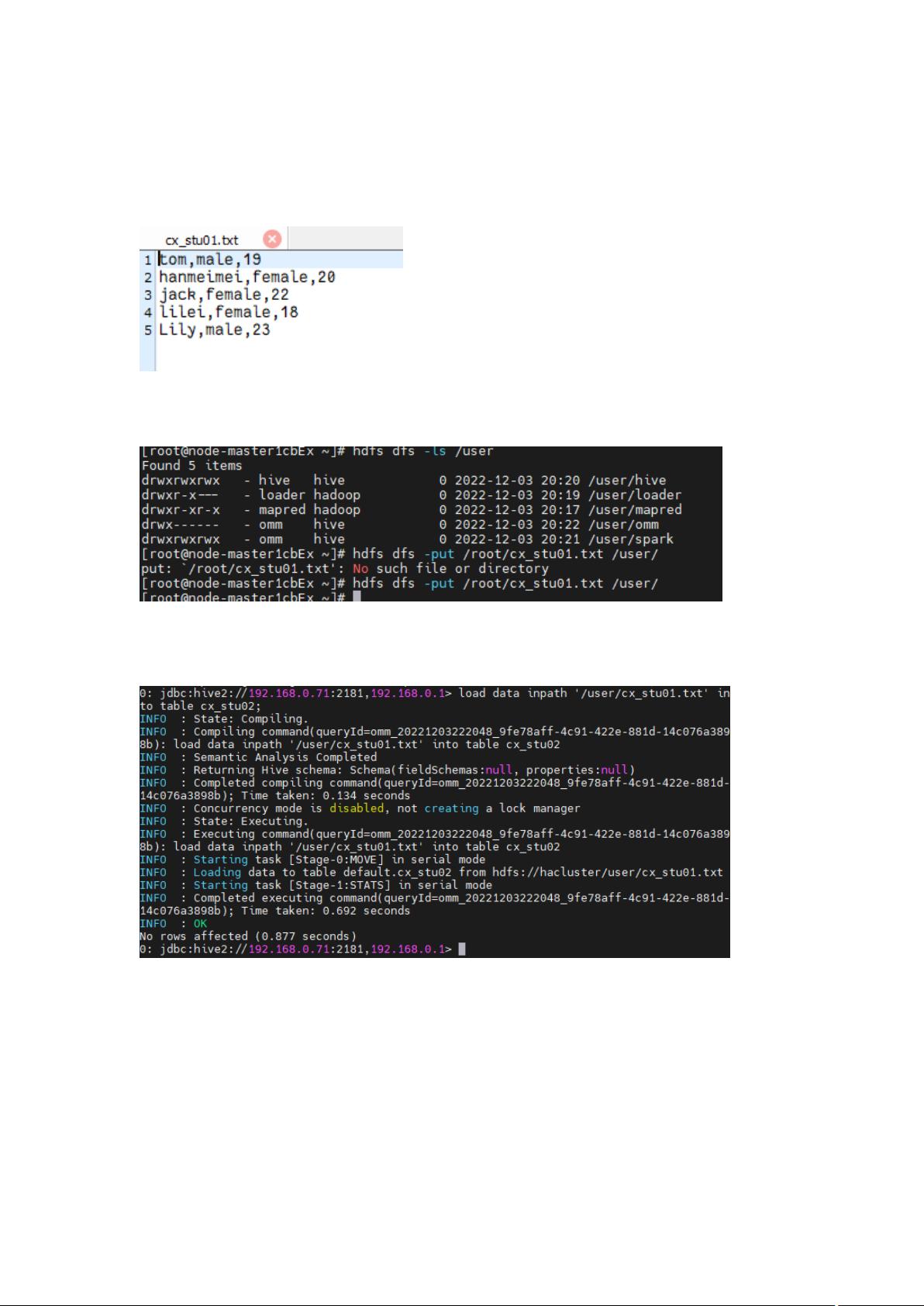

1. 使用文本编辑器在Linux环境中创建数据文件cx_stu01.txt,并输入相应数据,如姓名、性别和年龄。

2. 使用`hdfs dfs -put`命令将数据文件上传到HDFS指定路径,例如`/user/stu01/`:

```

hdfs dfs -put cx_stu01.txt /user/stu01/

```

3. 进入Hive环境(如通过Beeline),使用LOAD DATA命令将HDFS上的数据加载到外部表中:

```

LOAD DATA LOCAL INPATH '/home/stu01/cx_stu01.txt' INTO TABLE cx_stu02;

```

这个过程确保了数据可以从HDFS中读取并用于分析。

通过这两个任务,用户不仅学会了如何在Hive中创建和管理表,还了解了数据的导入流程。这为后续的数据查询、聚合和分析奠定了基础。在实际应用中,这些技能对于理解大规模数据集并从中提取有价值的信息至关重要。

2022-04-10 上传

2022-04-07 上传

点击了解资源详情

点击了解资源详情

2024-01-16 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

2022-08-07 上传

爆炸西蓝花

- 粉丝: 46

- 资源: 6

最新资源

- 火炬连体网络在MNIST的2D嵌入实现示例

- Angular插件增强Application Insights JavaScript SDK功能

- 实时三维重建:InfiniTAM的ros驱动应用

- Spring与Mybatis整合的配置与实践

- Vozy前端技术测试深入体验与模板参考

- React应用实现语音转文字功能介绍

- PHPMailer-6.6.4: PHP邮件收发类库的详细介绍

- Felineboard:为猫主人设计的交互式仪表板

- PGRFileManager:功能强大的开源Ajax文件管理器

- Pytest-Html定制测试报告与源代码封装教程

- Angular开发与部署指南:从创建到测试

- BASIC-BINARY-IPC系统:进程间通信的非阻塞接口

- LTK3D: Common Lisp中的基础3D图形实现

- Timer-Counter-Lister:官方源代码及更新发布

- Galaxia REST API:面向地球问题的解决方案

- Node.js模块:随机动物实例教程与源码解析