构建高效代理池:Python3 爬虫代理管理与检测

197 浏览量

更新于2024-08-30

收藏 382KB PDF 举报

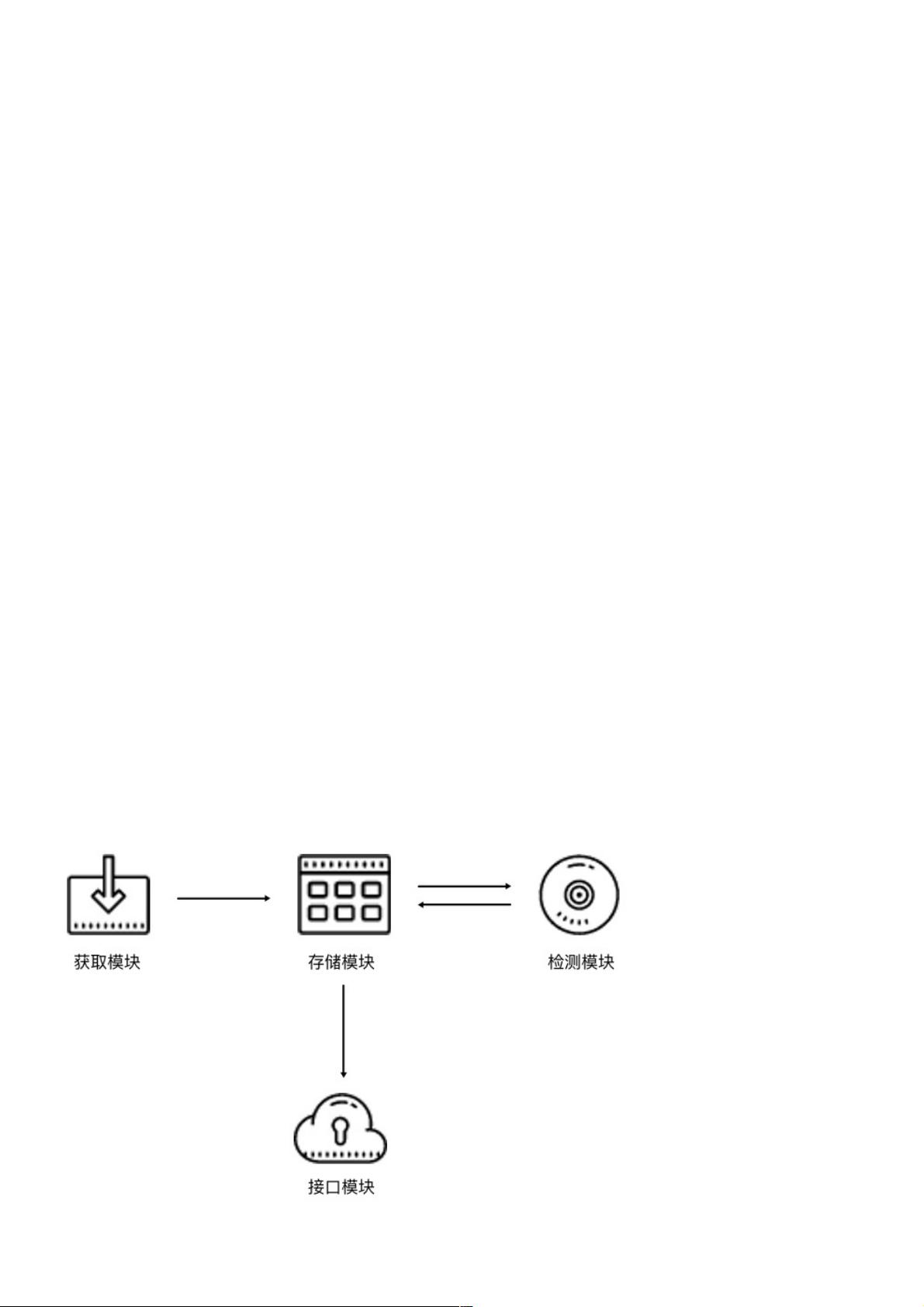

"本文主要讲解如何构建一个高效易用的Python3代理池,以解决爬虫过程中因目标网站封IP而导致的问题。代理池的核心在于筛选和维护可用的代理,通过定期抓取、存储、检查和提供接口四个主要模块实现。"

在Python3爬虫中,代理池是一个重要的工具,它能够帮助我们绕过目标网站对IP的限制,提高爬虫的稳定性和效率。在实际应用中,代理资源可以从免费和付费渠道获取,但这些代理的可用性无法保证,因为可能有其他用户同时使用导致IP被封或服务器出现问题。因此,建立一个代理池,对代理进行有效管理至关重要。

首先,搭建代理池前需要准备以下组件:

1. 安装并运行Redis数据库,用于存储代理信息。

2. 安装必要的Python库:Aiohttp、Requests、RedisPy、PyQuery和Flask。这些库分别用于异步请求、常规HTTP请求、与Redis交互、解析HTML和构建Web服务接口。

代理池的四个基本模块包括:

1. 获取模块:该模块定期从各种代理源抓取新的代理,包括免费和付费资源。为了提高质量,应优先选择高匿名代理,并确保从多个来源抓取以增加多样性。

2. 存储模块:存储模块采用Redis的SortedSet(有序集合)来存储代理,确保代理的唯一性,并记录每个代理的可用状态。Redis的SortedSet允许根据分数排序元素,非常适合用来记录代理的可用性评分。

3. 检测模块:定期检测存储的代理是否有效。通过访问特定的检测链接(最好是目标网站的URL)来评估代理的性能。每次检测后更新代理的分数,可用代理得满分,不可用代理分数递减,达到某个阈值后从数据库中移除。

4. 接口模块:提供API接口对外服务,让其他程序能安全地获取和使用代理。通过Web服务的方式避免直接暴露数据库连接信息,提高安全性。

在实现代理池的过程中,需要注意几点:

- 调整检测频率和策略,避免过于频繁的检测导致额外的压力。

- 设计合理的代理评分系统,既能反映代理的真实可用性,又能在短时间内做出响应。

- 使用异步操作提高效率,例如使用Aiohttp进行并发请求。

- 针对不同的目标网站,可能需要调整检测链接和判断标准,以优化代理的使用效果。

通过以上步骤,我们可以构建一个能够自动维护和优化的代理池,从而提高爬虫工作的效率和稳定性。在实际项目中,可以根据需求进行调整和扩展,如增加日志记录、异常处理和监控功能,进一步提升代理池的实用性。

2024-03-20 上传

2022-05-29 上传

点击了解资源详情

2021-10-25 上传

2024-10-06 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38499503

- 粉丝: 8

- 资源: 975

最新资源

- C语言数组操作:高度检查器编程实践

- 基于Swift开发的嘉定单车LBS iOS应用项目解析

- 钗头凤声乐表演的二度创作分析报告

- 分布式数据库特训营全套教程资料

- JavaScript开发者Robert Bindar的博客平台

- MATLAB投影寻踪代码教程及文件解压缩指南

- HTML5拖放实现的RPSLS游戏教程

- HT://Dig引擎接口,Ampoliros开源模块应用

- 全面探测服务器性能与PHP环境的iprober PHP探针v0.024

- 新版提醒应用v2:基于MongoDB的数据存储

- 《我的世界》东方大陆1.12.2材质包深度体验

- Hypercore Promisifier: JavaScript中的回调转换为Promise包装器

- 探索开源项目Artifice:Slyme脚本与技巧游戏

- Matlab机器人学习代码解析与笔记分享

- 查尔默斯大学计算物理作业HP2解析

- GitHub问题管理新工具:GIRA-crx插件介绍