VmWare中Hadoop2.6.5全分布式集群搭建教程

需积分: 5 104 浏览量

更新于2024-07-09

收藏 1.22MB PDF 举报

"Hadoop2.6.5全分布式集群搭建"

在本文中,我们将探讨如何在VmWare虚拟环境中搭建一个基于Hadoop 2.6.5版本的全分布式集群。Hadoop是一个开源的分布式计算框架,它允许在廉价硬件上处理和存储大量数据。Hadoop的主要目标是提供高可靠性和高容错性的数据存储与大规模数据处理的能力。

1. Hadoop的核心功能

- 分布式文件存储:Hadoop分布式文件系统(HDFS)是Hadoop的核心组件,它提供了一个高吞吐量的数据访问平台,适合大规模数据集的存储。

- 分布式计算:通过MapReduce编程模型,Hadoop允许用户编写并行处理程序来处理存储在HDFS上的数据。

2. Hadoop的发展历程

- 谷歌的创新:谷歌提出了GFS(Google File System)用于分布式存储,GoogleMapReduce用于分布式计算,以及BigTable作为分布式数据库。这些概念启发了Hadoop的诞生。

- Hadoop的演进:HDFS模仿了GFS,Hadoop MapReduce借鉴了GoogleMapReduce的思想,形成了Hadoop的核心组件。除此之外,Hadoop生态还包括YARN(Yet Another Resource Negotiator)用于资源管理和调度,以及HBase、Hive、Pig等数据处理工具。

3. 集群搭建前的准备工作

- 软件需求:为了管理Linux虚拟机,你需要Xshell(或其他SSH客户端如SecureCRT、Putty)来远程连接,Xftp(或WinSCP)来传输文件。此外,确保安装了对应Linux版本的JDK、Hadoop安装包以及Linux操作系统。

- VmWare安装:虽然在描述中没有详细说明,但VmWare是虚拟化软件,用于创建和管理虚拟机环境。

4. 搭建步骤

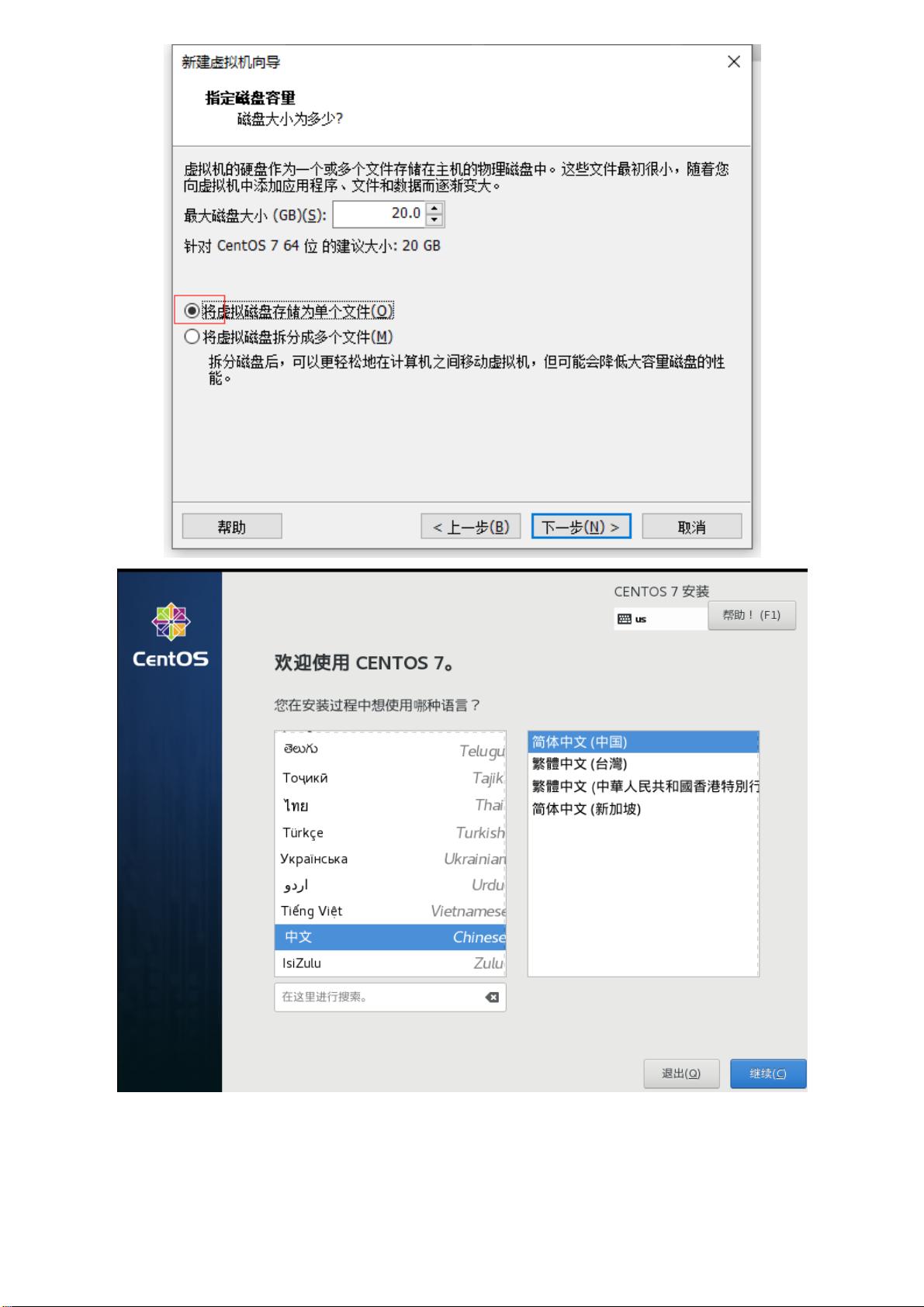

- 创建虚拟机:在VmWare中新建虚拟机,指定Linux操作系统(如CentOS)的镜像文件。

- 配置网络:设置虚拟机之间的网络连接,通常使用NAT模式或桥接模式,以便它们能够相互通信。

- 安装Linux:按照安装向导进行,创建用户和密码(如示例中的root/123456)。

- 安装JDK:在Linux中安装Java开发工具包,因为Hadoop依赖于Java运行环境。

- 安装Hadoop:解压Hadoop安装包,配置相关环境变量,包括HADOOP_HOME和PATH。

- 初始化HDFS和YARN:执行格式化HDFS、启动Hadoop服务等操作。

5. Linux基本操作

- 文件和目录管理:使用`ls`查看目录内容,`pwd`查看当前路径,`whoami`查看当前用户,`cd`切换目录。

- 文件操作:使用`touch`创建新文件,`echo`输出文本,`mv`移动或重命名文件,`tar`压缩和解压缩,`cp`复制文件。

- 文件系统结构:了解`/`根目录,`/home`用户主目录,以及`/etc`配置文件目录等。

在搭建过程中,需要注意配置Hadoop的配置文件,如`core-site.xml`、`hdfs-site.xml`和`mapred-site.xml`,确保集群中的节点能够正确通信,并且数据能够正确地在节点间分布和处理。此外,安全设置也是重要的一环,尤其是在生产环境中,需要考虑权限控制和防火墙设置。一旦集群搭建完成,你就可以在Hadoop平台上进行大数据处理任务了。

140 浏览量

2018-01-24 上传

140 浏览量

131 浏览量

346 浏览量

168 浏览量

2021-03-23 上传

2018-02-09 上传

463 浏览量

wsrxiaochou

- 粉丝: 0

- 资源: 5

最新资源

- WAP-209-MMSEncapsulation-20010601-a.pdf

- ejb3.0实例教程.pdf

- Spring 总结(1) 自用

- MPlayer中文文档

- Ant使用指南.pdf

- linux指令大全.doc

- manning_-_java_development_with_ant.pdf

- CatiaV5学习资料

- Hibernate In Action

- c语言百道编程题目和题目的分析讲解

- Java.Persistence.with.Hibernate.pdf

- 操作系统复习提纲计算机专业

- Hibernate原理與快速入門.pdf

- TortoiseSVN-1.5.6-zh_CN.pdf

- 基于51单片机的温度测量系统

- 中国3s发展现状调查