深度学习安全威胁:攻击方式与GAN攻击解析

"本文汇总了深度学习的攻击方式,包括成员推理攻击、模型反演攻击、GAN攻击、降维攻击和其他相关攻击手段。重点探讨了生成对抗网络(GAN)在攻击中的应用,阐述了GAN的工作原理及其在深度学习安全领域的潜在威胁。"

深度学习攻击是当前人工智能领域的重要关注点,因为它们可能破坏系统的安全性,导致误判、漏判甚至系统崩溃。其中,GAN(生成对抗网络)攻击是一种利用GAN模型来生成逼真数据,从而对深度学习模型进行攻击的方法。

生成对抗网络由两部分组成:生成模型G和判别模型D。G的目标是学习真实数据的分布,通过噪声向量z生成看似真实的样本。D的任务则是区分生成样本与真实样本,试图正确判断每个样本的来源。两者在训练过程中相互博弈,使得G的生成能力逐渐提高,而D的辨别能力也随之增强。

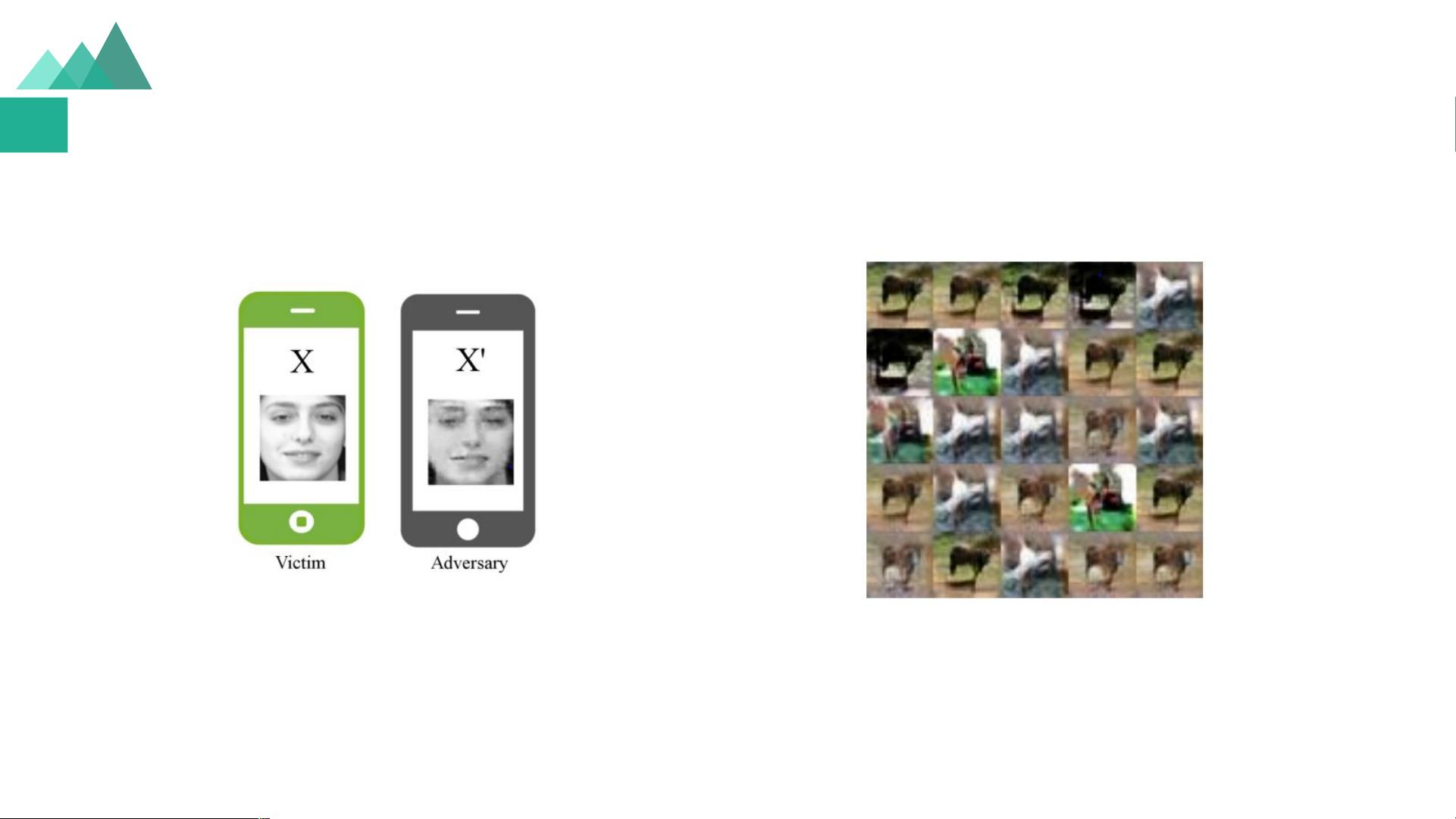

GAN攻击者通常会伪装成正常参与者,参与协同训练过程。他们可以获取并使用模型参数,利用GAN生成恶意样本,通过训练这些样本来计算梯度,然后将更新的参数上传回服务器。这样的攻击策略允许攻击者持续窃取敏感信息,甚至可能推断出受害者不公开的特征。

评估GAN攻击的影响时,我们发现它并不直接干扰差分隐私机制,但会在模型学习阶段持续活跃,通过共享梯度来获取更多信息。即使在差分隐私的约束下,只要训练能够收敛,GAN攻击仍然有效,只是收敛速度可能较慢。攻击者可以生成与真实数据相似的样本,但这些样本并非实际数据,且生成成本较高。此外,这种攻击主要在模型训练期间发挥作用。

除了GAN攻击,还有其他类型的深度学习攻击,如成员推理攻击,攻击者通过观察模型的输出推断出训练数据中的特定样本是否被用于训练;模型反演攻击则试图从模型的输出反推出输入数据的原始信息。降维攻击通常涉及在低维度空间中寻找数据的弱点,以提高攻击的成功率。

深度学习的安全性是多方面的挑战,需要在模型设计、训练过程和数据保护等多个层面采取措施来防御这些攻击。开发者和研究人员必须意识到这些潜在的威胁,采取适当的防御策略,如使用差分隐私、模型压缩、安全的训练协议等,以确保深度学习系统的安全性和用户隐私。

2011-06-29 上传

2020-04-18 上传

2021-02-08 上传

2021-03-18 上传

2019-05-07 上传

2018-08-08 上传

李小喵喵呆

- 粉丝: 4

- 资源: 7

最新资源

- 解决Eclipse配置与导入Java工程常见问题

- 真空发生器:工作原理与抽吸性能分析

- 爱立信RBS6201开站流程详解

- 电脑开机声音解析:故障诊断指南

- JAVA实现贪吃蛇游戏

- 模糊神经网络实现与自学习能力探索

- PID型模糊神经网络控制器设计与学习算法

- 模糊神经网络在自适应PID控制器中的应用

- C++实现的学生成绩管理系统设计

- 802.1D STP 实现与优化:二层交换机中的生成树协议

- 解决Windows无法完成SD卡格式化的九种方法

- 软件测试方法:Beta与Alpha测试详解

- 软件测试周期详解:从需求分析到维护测试

- CMMI模型详解:软件企业能力提升的关键

- 移动Web开发框架选择:jQueryMobile、jQTouch、SenchaTouch对比

- Java程序设计试题与复习指南