使用CNN+RNN进行图像描述生成

需积分: 10 103 浏览量

更新于2024-07-17

收藏 8.14MB DOCX 举报

“图像语义,图像自动描述,CNN,RNN,LSTM,Attention机制,Encoder-Decoder模型”

图像语义是指对图像内容的理解和解释,包括识别图像中的对象、场景、行为等,并能用自然语言进行准确描述。在计算机视觉和自然语言处理领域,图像语义的研究聚焦于如何让机器理解并生成描述图像的文本,这一过程被称为图像caption生成。

图像caption的任务是通过算法自动生成描述图像内容的一段文字,这涉及到了计算机视觉(CV)和自然语言处理(NLP)的结合。最常见的一种方法是采用卷积神经网络(CNN)和循环神经网络(RNN),尤其是长短期记忆网络(LSTM)的组合。

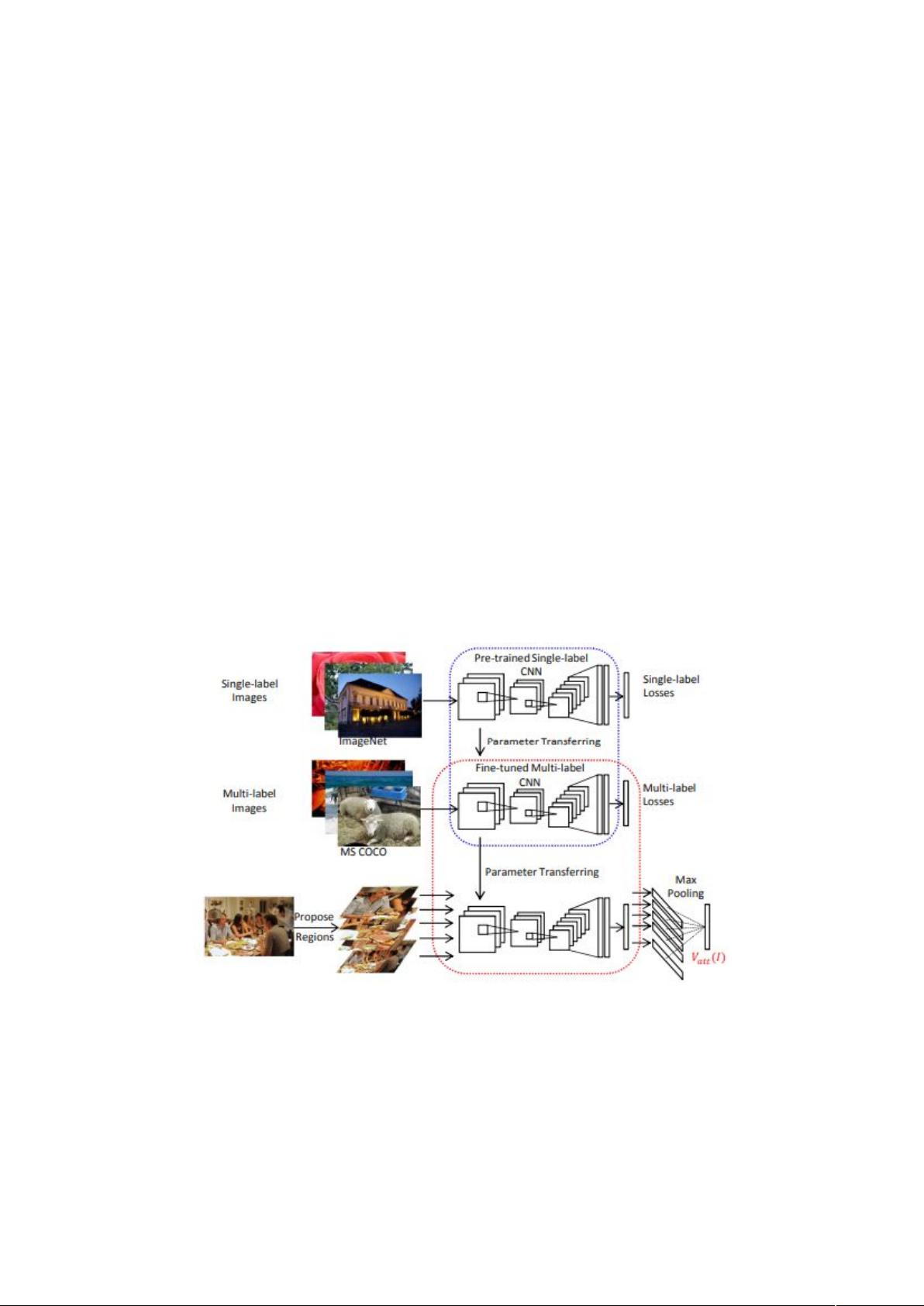

在基本的解决方案中,首先使用CNN从图像中提取高层特征。CNN通过对图像的多个层次进行卷积操作,形成feature map,捕获图像的空间和语义信息。然后,通常采取全局平均池化,将feature map中的每个点的特征向量取平均,生成一个单一的特征向量,作为RNN(如LSTM)的输入,用于生成描述。

RNN在解码阶段工作,根据接收到的图像特征和之前生成的单词序列,逐步预测下一个单词。然而,这种基础架构存在局限性。当生成的语义描述变长时,RNN在解码后期无法有效地利用图像特征。此外,传统的Encoder-Decoder结构中,整个图像的信息被编码成一个单一的上下文向量c,随着caption长度增加,c可能无法存储足够的信息,导致描述的准确性下降。

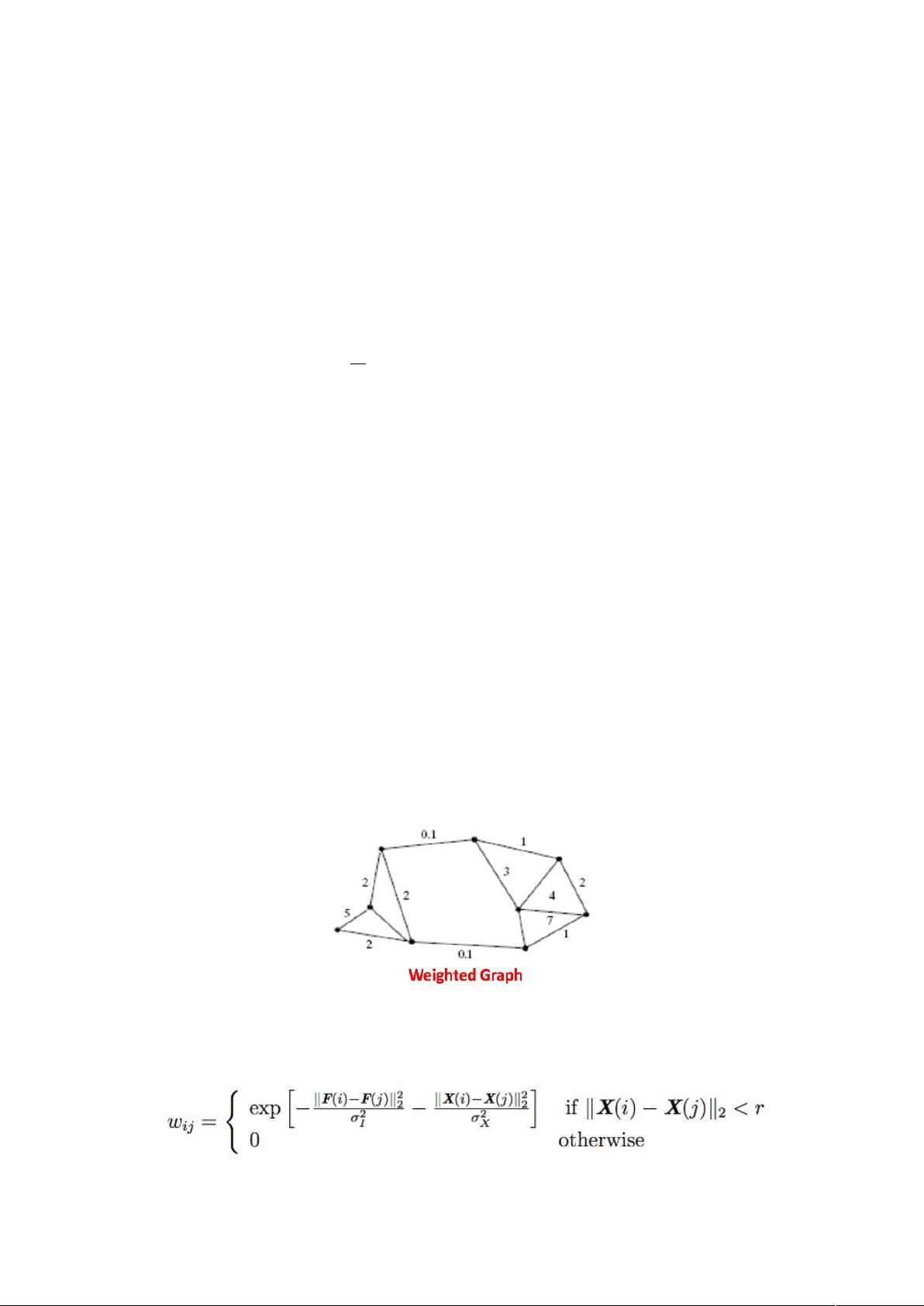

为了解决这个问题,研究人员引入了注意力机制(Attention Mechanism)。在《Show and Tell: A Neural Image Caption Generator》这篇论文中,Google提出了一种改进的Encoder-Decoder模型。在这个模型中,CNN不再只生成一个单一的c,而是产生一系列的特征向量,对应于feature map的不同位置。在Decoder的每个时间步,它不仅基于当前的词向量,还会根据需要动态地关注image feature map的不同部分,生成当前单词的context向量。这种方法允许Decoder在生成caption的过程中,根据需要更加灵活地访问图像信息,从而提高了caption的质量和准确性。

图像语义的研究促进了计算机对图像的理解,并推动了图像自动描述技术的发展。通过结合CNN和RNN(LSTM)以及引入注意力机制,现代的模型能够更准确地捕捉和表达图像的复杂内容,生成更加贴近人类理解的图像描述。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-03-07 上传

2019-01-29 上传

2018-05-22 上传

2023-12-29 上传

2023-09-24 上传

Josephq_ssp

- 粉丝: 3

- 资源: 16

最新资源

- FACTORADIC:获得一个数字的阶乘基数表示。-matlab开发

- APIPlatform:API接口平台主页接口调用网站原始码(含数十项接口)

- morf源代码.zip

- 参考资料-附件2 盖洛普Q12 员工敬业度调查(优秀经理与敬业员工).zip

- MyJobs:Yanhui Wang 使用 itemMirror 和 Dropbox 管理作业的 SPA

- SiFUtilities

- PrivateSchoolManagementApplication:与db连接的控制台应用程序

- python-sdk:MercadoLibre的Python SDK

- Docket-App:笔记本Web应用程序

- Crawler-Parallel:C语言并行爬虫(epoll),爬取服务器的16W个有效网页,通过爬取页面源代码进行确定性自动机匹配和布隆过滤器去重,对链接编号并写入url.txt文件,并通过中间文件和三叉树去除掉状态码非200的链接关系,将正确的链接关系继续写入url.txt

- plotgantt:从 Matlab 结构绘制甘特图。-matlab开发

- 【精品推荐】智慧体育馆大数据智慧体育馆信息化解决方案汇总共5份.zip

- tsu津

- houdini-samples:各种Houdini API的演示

- parser-py:Python的子孙后代工具

- proton:Vue.js的无渲染UI组件的集合