TensorFlow在NLP中的应用:深度学习与词向量模型

148 浏览量

更新于2024-08-27

收藏 680KB PDF 举报

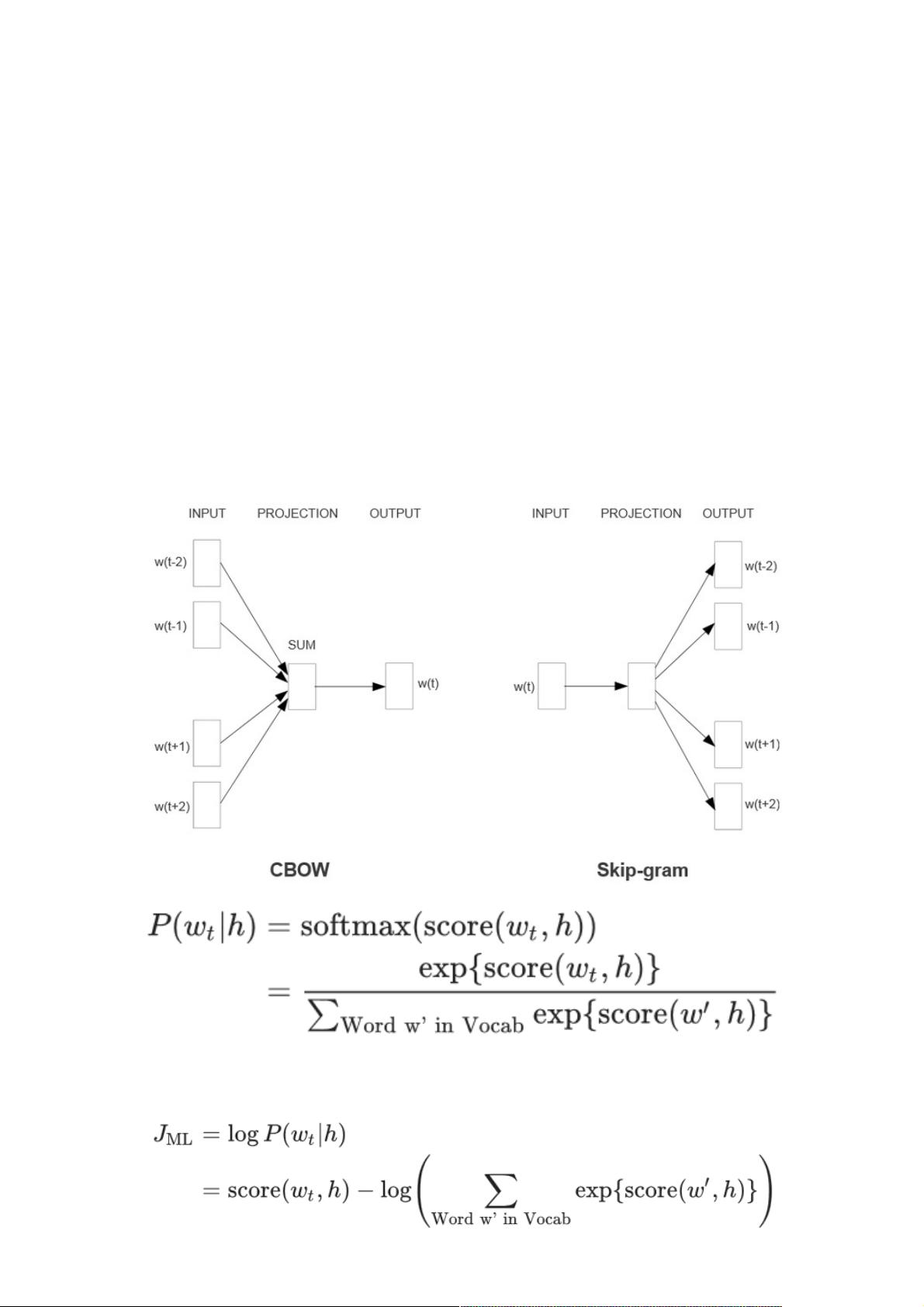

"本文主要探讨了深度学习在自然语言处理(NLP)领域的应用,特别是通过TensorFlow这一强大的工具。文章介绍了NLP的基本概念,强调了深度学习在文本分析、机器翻译、自动问答等任务中的重要性。文章还提到了谷歌的word2vec工具,它将词语转化为词向量,促进了文本的数字化处理。此外,文中还讨论了谷歌的SyntaxNet框架和tf-seq2seq模型,这两个工具分别提升了语言理解和自动翻译的效率。重点讲述了TensorFlow在词向量生成、RNN/LSTM语言预测和自动翻译模型中的应用,并对Word2Vec的数学原理进行了简要介绍,包括CBOW和Skip-gram模型的工作机制。"

深度学习在NLP领域的应用已经越来越广泛,TensorFlow作为一个强大的开源库,为开发这些应用提供了便利。在NLP中,深度学习主要涉及到表征学习,即通过神经网络学习到的词向量能捕捉到词汇的语义信息。word2vec作为谷歌发布的工具,是这一过程的关键,它通过训练将单词映射为高维向量,使得计算机能够理解语言的结构和含义。

TensorFlow在NLP中的应用包括词向量生成模型,如word2vec的CBOW和Skip-gram模型。CBOW模型试图预测中心词,而Skip-gram模型则预测上下文词,这两种模型都能揭示词与词之间的关系。通过优化目标函数,word2vec能够学习到词向量,使得语义相近的词在向量空间中的距离较近。

RNN(循环神经网络)和LSTM(长短时记忆网络)是深度学习中常用于处理序列数据的模型,尤其适合于语言这种有时间依赖性的数据。在TensorFlow中,这些模型可以用来进行语言预测任务,即给定前面的一部分文本,预测下一个可能的单词。LSTM通过其独特的门控机制解决了RNN中梯度消失和爆炸的问题,更好地捕捉长期依赖。

自动翻译是NLP中的另一个重要应用,TensorFlow提供的tf-seq2seq框架就是一个用于实现这一任务的通用编码器/解码器模型。它利用深度学习模型将源语言的序列转化为目标语言的序列,极大地推动了机器翻译的进展。

TensorFlow为NLP提供了一个强大的平台,使得研究人员和开发者能够构建和优化各种模型,解决从词向量生成到复杂对话系统等一系列自然语言处理问题。随着深度学习技术的不断发展,TensorFlow在NLP领域的应用前景将持续扩大。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-10-07 上传

2018-03-24 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38546817

- 粉丝: 8

- 资源: 911