Apache Hive:Hadoop数据仓库详解与建表策略

48 浏览量

更新于2024-08-28

收藏 430KB PDF 举报

Apache Hive 是一个重要的数据仓库工具,它构建在 Hadoop 之上,专为大规模、结构化数据处理而设计。Hive 的核心优势在于它能够将结构化的数据文件(如文本、JSON 或 Parquet 等格式)映射成类似关系型数据库的表,并使用 HQL(Hive Query Language)进行查询,从而简化数据分析和管理。Hive 以其出色的扩展性和容错能力,被广泛应用于离线数据仓库的构建。

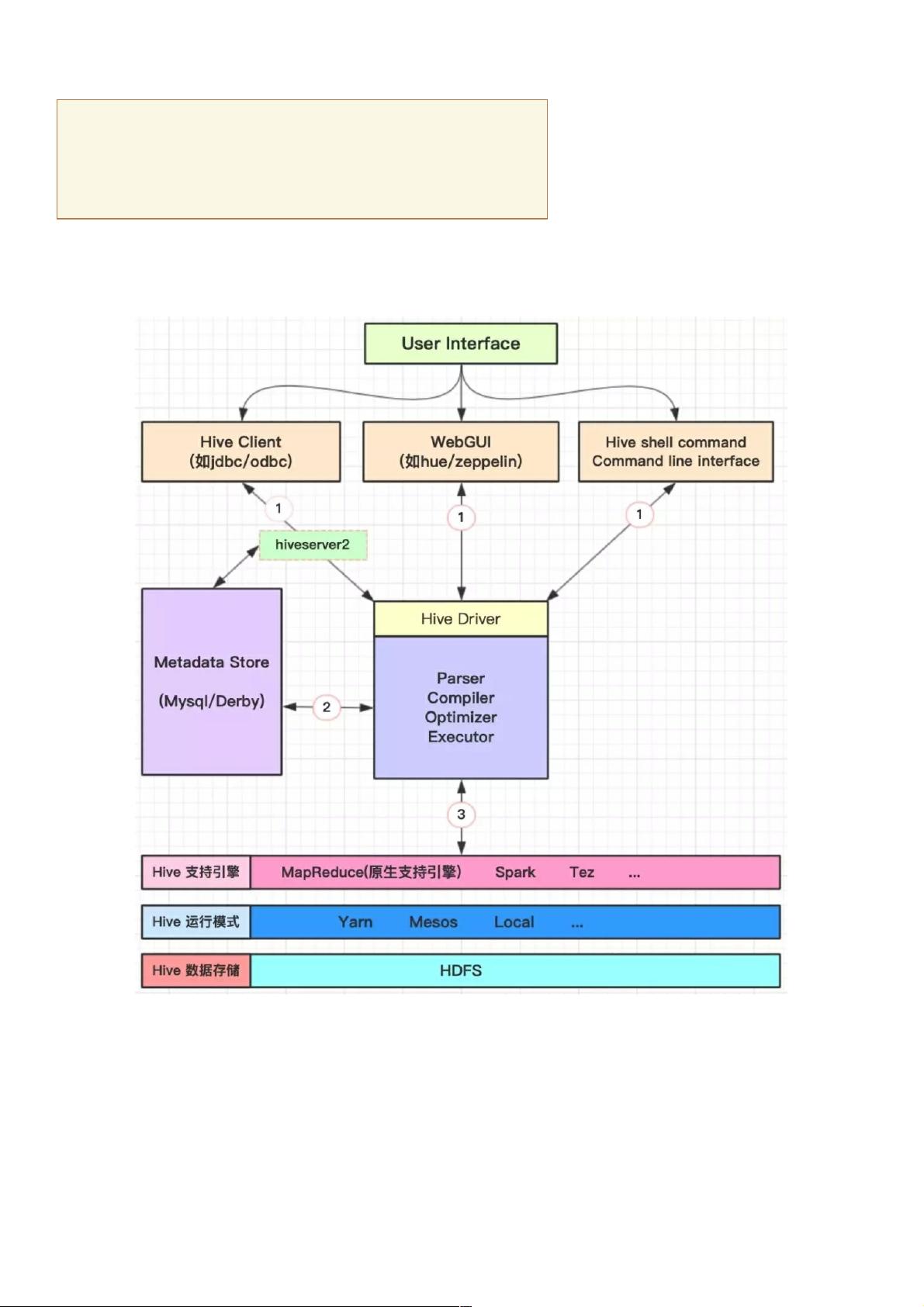

1. Hive 架构:

- 存储:Hive 基于 HDFS(Hadoop 分布式文件系统)进行底层存储,支持多种数据格式,包括文本、JSON、Parquet 等。在创建表时,只需要指定列名、分隔符等信息,Hive 自动解析数据。

- 压缩支持:Hive 支持多种压缩格式,如 bzip2、gzip、lzo 和 snappy,其中 parquet + snappy 是常见的存储组合。

- 计算引擎:Hive 最初使用 MapReduce 作为其计算引擎,但为了提高效率,现在也支持 Spark 和 Tez 等其他计算框架。

- 元数据管理:Hive 内置的 Derby 数据库用于存储元数据,但由于并发性能较差且不支持多会话,生产环境中常选择 MySQL 作为元数据存储库。

- 查询执行流程:Hive 查询首先通过解析器、编译器、优化器进行词法和语法分析,然后生成查询计划并存储在 HDFS 中,最后转换为 MapReduce 任务执行。

2. Hive 的建表方式:

- 使用 `CREATE [EXTERNAL]TABLE` 语句创建表,可指定表名、列名、数据类型及注释。表可以被标记为外部表,允许数据存储在其他位置。

- 可以根据需要添加分区(`PARTITIONED BY`),集群(`CLUSTERED BY`)以及排序(`SORTED BY`)特性,定义数据的存储逻辑和查询性能优化。

- `ROWFORMAT` 选项用于指定数据在文件中的存储格式,`STORED AS` 用于指定文件格式,`LOCATION` 指定表在 HDFS 的存储路径。

Apache Hive 提供了一种统一的接口来操作和管理大规模的结构化数据,极大地简化了数据仓库的构建和维护。通过了解其架构、建表方式和查询执行机制,开发人员可以更有效地利用 Hadoop 集群进行数据处理和分析。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-07-29 上传

2018-07-29 上传

2023-04-26 上传

2023-04-26 上传

2023-04-26 上传

weixin_38701312

- 粉丝: 8

- 资源: 947

最新资源

- MATLAB实现小波阈值去噪:Visushrink硬软算法对比

- 易语言实现画板图像缩放功能教程

- 大模型推荐系统: 优化算法与模型压缩技术

- Stancy: 静态文件驱动的简单RESTful API与前端框架集成

- 掌握Java全文搜索:深入Apache Lucene开源系统

- 19计应19田超的Python7-1试题整理

- 易语言实现多线程网络时间同步源码解析

- 人工智能大模型学习与实践指南

- 掌握Markdown:从基础到高级技巧解析

- JS-PizzaStore: JS应用程序模拟披萨递送服务

- CAMV开源XML编辑器:编辑、验证、设计及架构工具集

- 医学免疫学情景化自动生成考题系统

- 易语言实现多语言界面编程教程

- MATLAB实现16种回归算法在数据挖掘中的应用

- ***内容构建指南:深入HTML与LaTeX

- Python实现维基百科“历史上的今天”数据抓取教程