Python爬虫模拟登录GitHub实战教程

182 浏览量

更新于2024-08-29

收藏 1.2MB PDF 举报

本文主要介绍了如何使用Python爬虫模拟登录GitHub网页,以便在登录后获取特定的用户数据,如注册号码。模拟登录的过程涉及到解析网页请求参数,特别是动态参数`authenticity_token`,并利用Python的requests库来实现网络请求。

在Python爬虫中,模拟登录通常分为以下几个步骤:

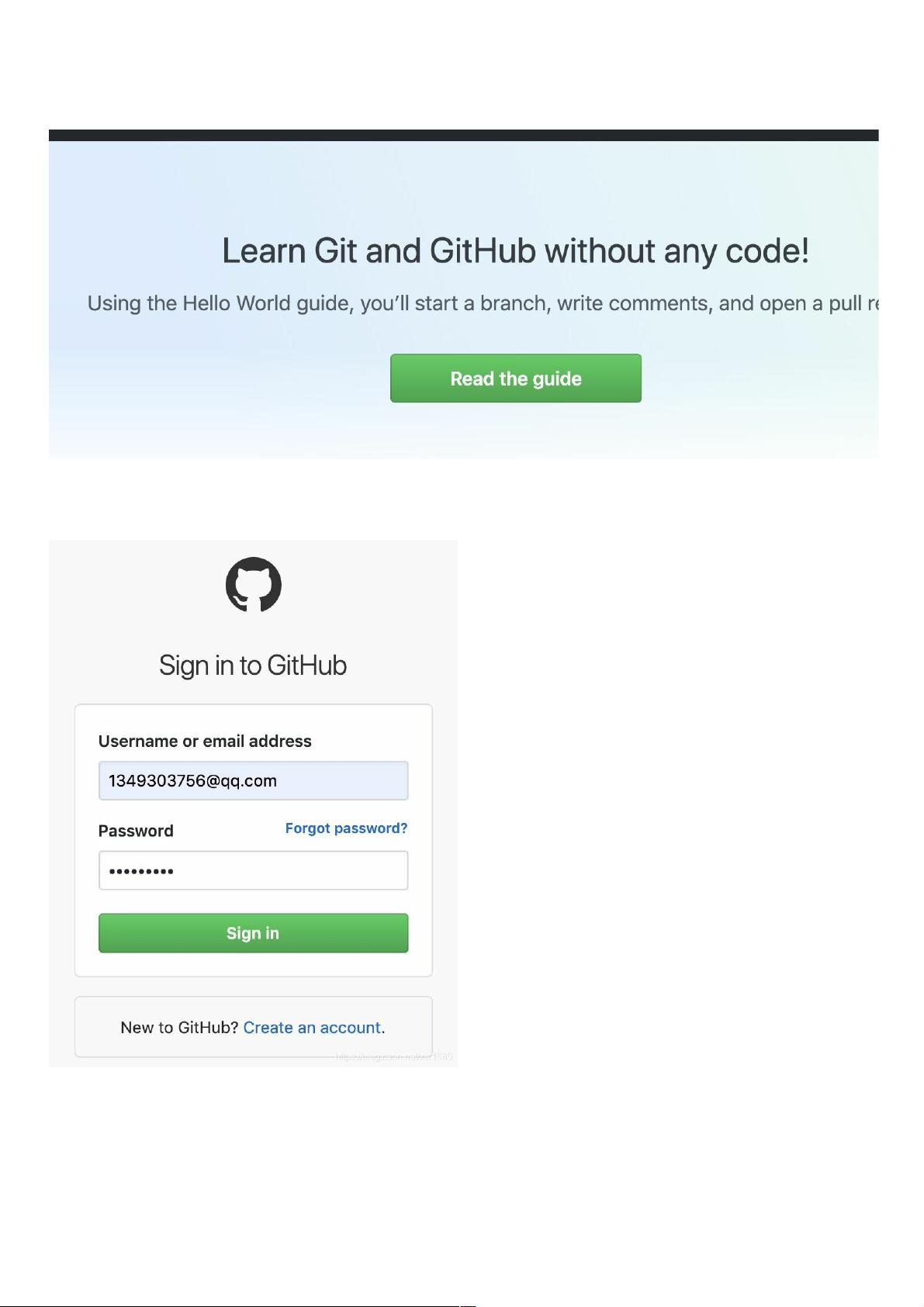

1. 查看请求参数:首先,你需要访问GitHub的登录页面,并输入账号和密码。然后使用浏览器的开发者工具(如Chrome的F12或右键检查)来监控网络请求。重点寻找名为`session`的登录请求。

2. 分析请求头和表单数据:在`session`请求的`RequestHeaders`中,关键信息包括`Host`(主页面地址)、`Referer`(请求来源)和`User-Agent`(浏览器标识)。在`FormData`中,你需要找到动态参数`authenticity_token`,以及登录所需的`login`(用户名)和`password`(密码)。

3. 获取动态参数:`authenticity_token`是防止跨站请求伪造(CSRF)的安全令牌。退出登录后,再次打开登录页面,通过开发者工具检查HTML源码,搜索`authenticity_token`关键字,找到其对应的value值。

4. 编写爬虫代码:首先,导入必要的Python库,如requests和BeautifulSoup。创建一个包含必要请求头信息的字典,然后使用Session对象发送GET请求获取登录页面,从中提取`authenticity_token`。之后,构造包含所有登录参数的POST请求,包括用户名、密码和`authenticity_token`,并发送该请求以模拟登录。

5. 处理登录响应:如果登录成功,服务器通常会返回一个包含登录状态的响应。你可以通过检查响应状态码或解析响应内容来判断是否登录成功。一旦登录成功,你就可以发送后续请求来获取登录后才能看到的数据,例如GitHub的注册号码。

为了实现这个过程,你可以使用以下Python代码结构:

```python

import requests

from bs4 import BeautifulSoup

# 创建请求头

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'

}

# 获取登录页面

with requests.Session() as session:

login_page = session.get('https://github.com/login', headers=headers)

soup = BeautifulSoup(login_page.text, 'html.parser')

authenticity_token = soup.find('input', {'name': 'authenticity_token'}).get('value')

# 构造登录数据

data = {

'login': 'your_username',

'password': 'your_password',

'authenticity_token': authenticity_token

}

# 模拟登录

response = session.post('https://github.com/session', data=data, headers=headers)

if response.status_code == 200:

# 登录成功,后续可以访问需要登录的页面

pass

else:

print('登录失败')

```

以上代码仅为示例,实际使用时需要替换`your_username`和`your_password`为你自己的GitHub账户信息。此外,GitHub可能有反爬虫策略,如验证码、频率限制等,这可能需要更复杂的处理策略,如使用代理、设置延时等。务必遵守GitHub的使用条款,并尊重网站的robots.txt文件。

2020-12-20 上传

2023-03-30 上传

2023-03-16 上传

2023-07-11 上传

2023-06-06 上传

2023-08-31 上传

2023-10-18 上传

2023-06-07 上传

2023-12-21 上传

weixin_38557896

- 粉丝: 0

- 资源: 971

最新资源

- 十种常见电感线圈电感量计算公式详解

- 军用车辆:CAN总线的集成与优势

- CAN总线在汽车智能换档系统中的作用与实现

- CAN总线数据超载问题及解决策略

- 汽车车身系统CAN总线设计与应用

- SAP企业需求深度剖析:财务会计与供应链的关键流程与改进策略

- CAN总线在发动机电控系统中的通信设计实践

- Spring与iBATIS整合:快速开发与比较分析

- CAN总线驱动的整车管理系统硬件设计详解

- CAN总线通讯智能节点设计与实现

- DSP实现电动汽车CAN总线通讯技术

- CAN协议网关设计:自动位速率检测与互连

- Xcode免证书调试iPad程序开发指南

- 分布式数据库查询优化算法探讨

- Win7安装VC++6.0完全指南:解决兼容性与Office冲突

- MFC实现学生信息管理系统:登录与数据库操作