机器学习:范数规则化与防止过拟合

需积分: 0 85 浏览量

更新于2024-08-05

收藏 2.2MB PDF 举报

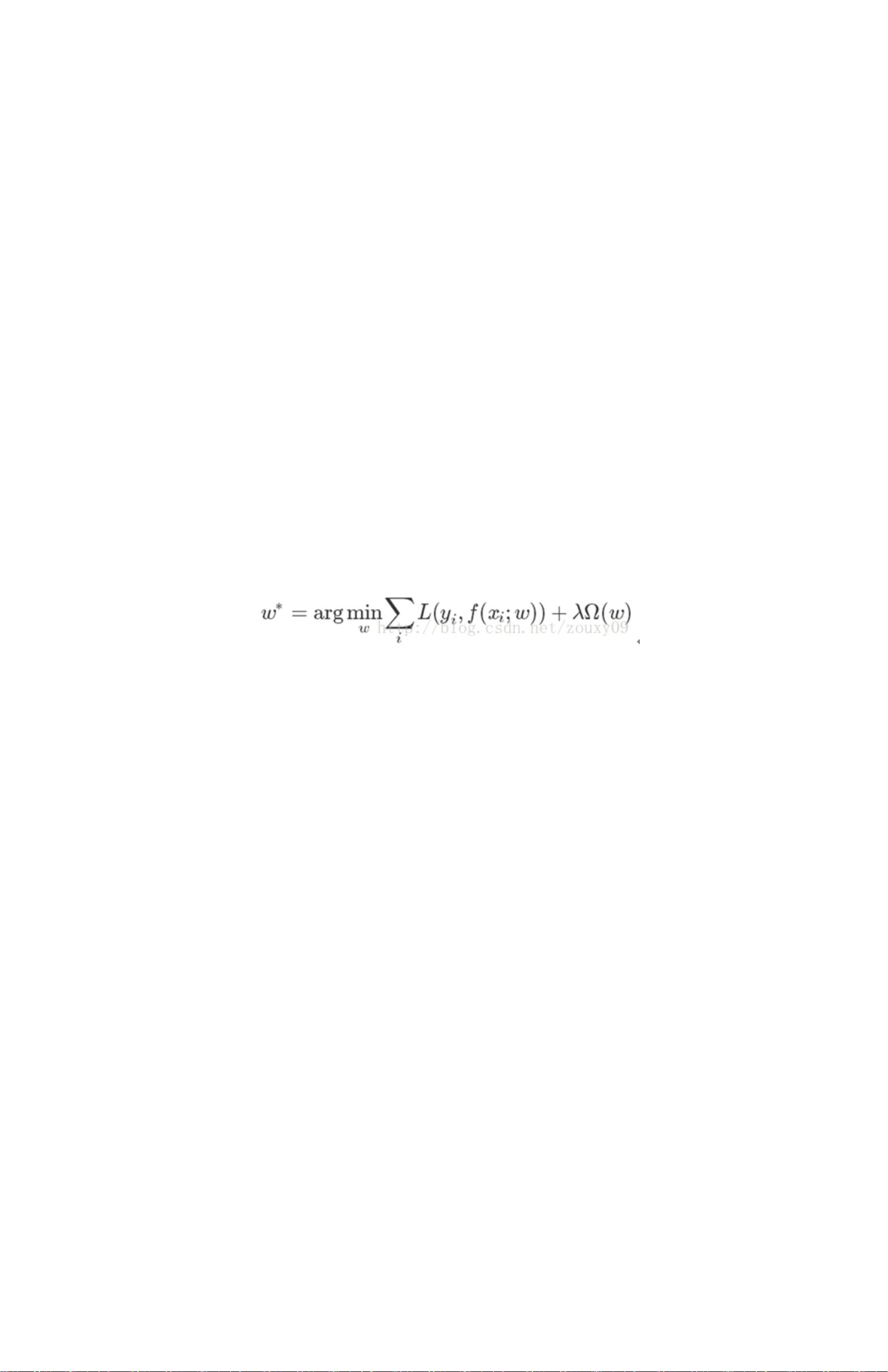

"本文主要探讨了机器学习中的范数规则化问题,特别是L0、L1、L2和核范数规则化在防止过拟合和提升模型泛化能力方面的作用。作者指出,规则化是确保模型简洁并具有良好泛化性能的关键,同时也能够根据先验知识约束模型特性。此外,文章提到了规则化与奥卡姆剃刀原则、贝叶斯估计以及结构风险最小化的关联。"

在机器学习中,范数规则化是一种常见的技术,用于防止过拟合,提高模型的泛化能力。过拟合发生时,模型过于复杂,过度适应训练数据,导致在新样本上的预测效果较差。为了解决这个问题,引入了规则化项,它是在模型的损失函数中添加一个惩罚因子,限制模型参数的复杂性。

L0范数表示参数向量中非零元素的个数,理想情况下,L0范数越小,模型的稀疏性越好,即模型中非零参数的数量较少,有利于特征选择。然而,L0范数的优化问题是NP难问题,不易求解。

相比之下,L1范数(也称为拉普拉斯范数)是参数向量中所有元素绝对值之和。L1范数的优化相对更容易,且通常能诱导出稀疏解,因此常用于特征选择和压缩。L1规则化通过惩罚模型参数的绝对值,倾向于产生一些接近零的参数值,从而达到稀疏化的效果。

L2范数(也称为欧几里得范数)是参数向量中所有元素平方和的平方根。L2规则化通过对参数的平方和进行惩罚,防止参数过大,有助于避免模型过拟合,保持模型的稳定性。L2规则化下的模型通常不会产生稀疏解,而是所有参数都较小但不为零。

核范数规则化通常应用于矩阵分解或机器学习中的核方法,如支持向量机(SVM)。它针对矩阵,计算其所有元素的平方和,有助于降低模型的复杂度,特别是在高维空间中寻找低秩解决方案,如在协同过滤中减少推荐系统的维度。

规则化项的选择取决于具体任务和先验知识。对于希望获得稀疏解的任务,如特征选择,L1规则化更为合适;而对于需要保持模型稳定性的场景,L2规则化更常见。此外,还可以结合L1和L2范数,形成Elastic Net,它同时鼓励稀疏性和整体模型的平滑性。

从贝叶斯角度,规则化项可以被视为模型参数的先验概率分布,这种先验信息有助于指导模型学习的方向。另一方面,规则化也可以被视为结构风险最小化策略的体现,通过在经验风险(即训练误差)上增加正则化项,以期望降低未来的预测风险。

范数规则化是机器学习中至关重要的组成部分,它帮助我们在追求模型对训练数据的拟合度和泛化能力之间找到平衡,同时也为我们提供了将领域知识融入模型的机会。正确理解和应用规则化技术,能够有效地提升模型的性能,减少不必要的复杂性,使得模型更加实用和可靠。

7338 浏览量

321 浏览量

185 浏览量

305 浏览量

169 浏览量

251 浏览量

230 浏览量

251 浏览量

140 浏览量

林祈墨

- 粉丝: 39

最新资源

- GuessNumber 2.0版本新增难度选择功能

- 联想一键恢复功能详解及NOVO按键操作指南

- Laravel 8食谱食材:掌握专业级代码轻松制作

- ASP.NET网上人才招聘系统源代码及论文全面解析

- C语言实现环形缓冲区的32位调试库

- qEdit: 基于Qt和C++的开源文本编辑器

- FortiClient 6.0.10.0297 安全软件:Windows系统安装与使用

- GNU Make第三版:深入掌握项目管理与扩展功能

- JUnit4.0版本核心jar包深入解析

- 掌握CSS弹性框与网格布局的秘诀

- 实现全动态的JSON级联select下拉框

- POSIX开源软件:电子商务平台的集成解决方案

- Linux内存管理与虚拟内存管理指南

- ASP科研项目管理系统源码与论文指南

- WPF中使用VideoCaptureElement实现拍照功能教程

- 基于ThinkPHP3.2的微信问卷考试系统源码发布