支持向量机:从线性分类到核函数解析

需积分: 3 33 浏览量

更新于2024-07-20

收藏 587KB PPTX 举报

"本文主要介绍了支持向量机(Support Vector Machine, SVM)的基本概念和核心原理,包括线性分类器、分类间隔、几何间隔、优化问题、线性不可分情况下的处理、核函数的选择以及松弛变量和惩罚因子的作用。"

支持向量机是一种监督学习模型,主要用于分类和回归分析。在机器学习领域,它因其优秀的泛化能力和处理小样本的能力而备受关注。SVM的核心思想是找到一个最优的分类边界,使得两类样本点之间的间隔最大。

1. 线性分类器:在SVM中,线性分类器是通过找到一个超平面来实现的,该超平面将数据集分为两类。对于二分类问题,这个超平面可以表示为w·x + b = 0,其中w是权重向量,x是输入样本,b是偏置项。

2. 分类间隔:分类间隔衡量的是样本点到超平面的距离,它与样本的分类标记yi有关。如果yi与超平面同侧,间隔为正;反之,为负。几何间隔是样本点到分类超平面的实际距离,考虑了样本的标记信息。

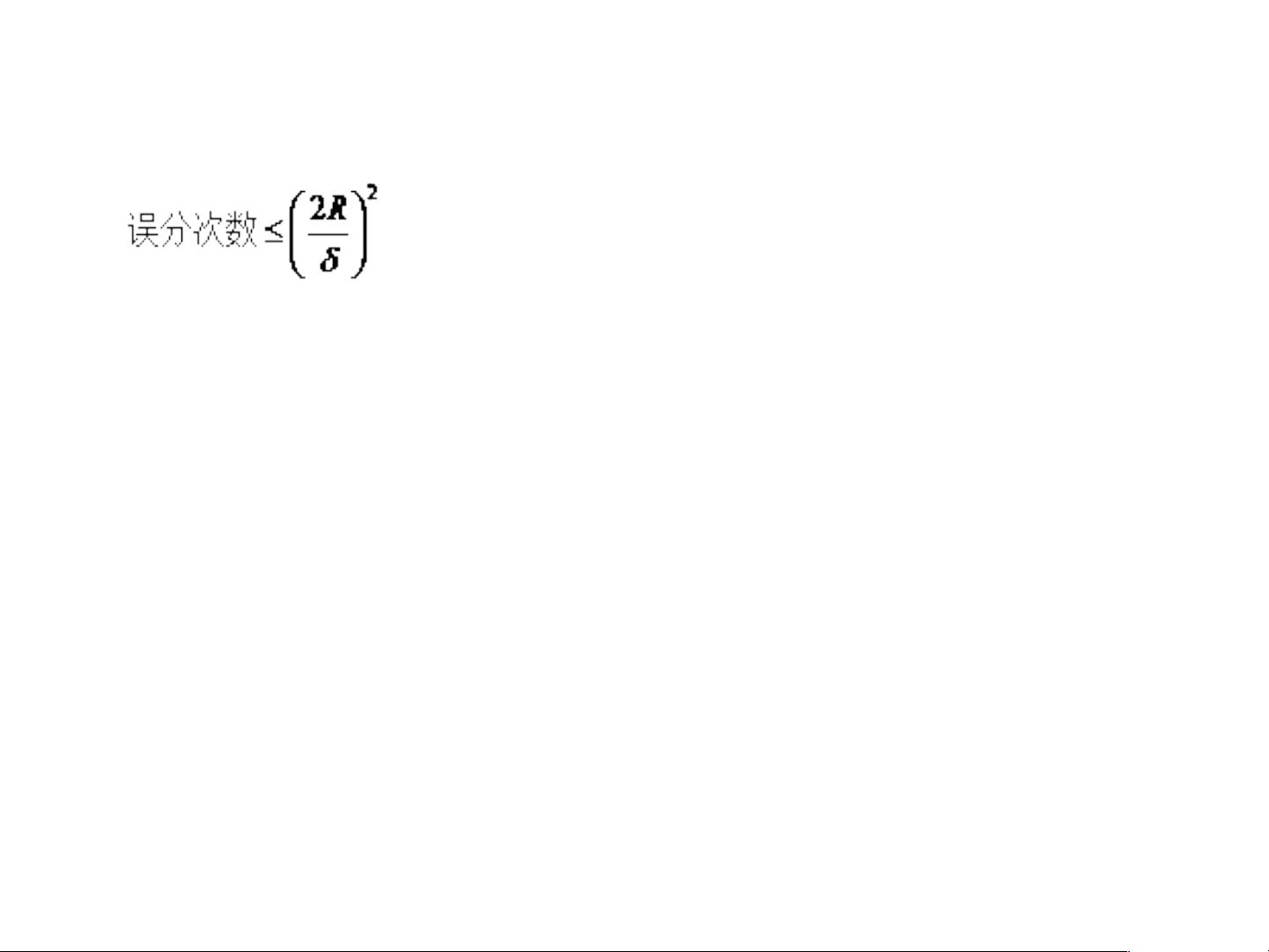

3. 寻优问题:SVM的目标是最大化几何间隔,同时满足所有样本点都在正确的一侧。这可以通过一个包含目标函数和约束条件的优化问题来表达,其中约束条件确保了样本点的位置。

4. 线性不可分:当数据在原始空间中线性不可分时,SVM引入核函数将数据映射到高维空间,使得在新空间中数据变得线性可分。常见的核函数包括线性核、多项式核、径向基函数(RBF)和Sigmoid核。

5. 核函数选择:选择合适的核函数是SVM中的关键步骤,但没有固定的规则。RBF核通常是一个安全的选择,因为它在很多情况下表现良好。

6. 松弛变量:为了处理非线性可分或噪声较大的数据,SVM引入了松弛变量,允许一部分样本点不完全满足分类条件。这增加了分类的鲁棒性,但同时也引入了损失。

7. 惩罚因子C:惩罚因子C控制了模型对误分类的容忍度。大C值倾向于找到间隔较大但可能有误分类的超平面,小C值则倾向于找到尽可能少误分类的超平面。

支持向量机通过寻找最优的分类边界和利用核函数映射,能够处理线性及非线性问题,并通过松弛变量和惩罚因子来适应数据的复杂性和噪声。在实际应用中,根据数据特性调整这些参数,可以帮助构建出高效且准确的分类模型。

2022-08-08 上传

2021-09-10 上传

2024-06-20 上传

2023-11-21 上传

2023-03-29 上传

2024-04-06 上传

2024-03-26 上传

2023-11-27 上传

2023-09-09 上传

叨叨叨猪

- 粉丝: 3

- 资源: 1

最新资源

- 磁性吸附笔筒设计创新,行业文档精选

- Java Swing实现的俄罗斯方块游戏代码分享

- 骨折生长的二维与三维模型比较分析

- 水彩花卉与羽毛无缝背景矢量素材

- 设计一种高效的袋料分离装置

- 探索4.20图包.zip的奥秘

- RabbitMQ 3.7.x延时消息交换插件安装与操作指南

- 解决NLTK下载停用词失败的问题

- 多系统平台的并行处理技术研究

- Jekyll项目实战:网页设计作业的入门练习

- discord.js v13按钮分页包实现教程与应用

- SpringBoot与Uniapp结合开发短视频APP实战教程

- Tensorflow学习笔记深度解析:人工智能实践指南

- 无服务器部署管理器:防止错误部署AWS帐户

- 医疗图标矢量素材合集:扁平风格16图标(PNG/EPS/PSD)

- 人工智能基础课程汇报PPT模板下载