流数据监控项目实践:Storm实时处理

155 浏览量

更新于2024-07-15

收藏 906KB PDF 举报

"本文主要介绍了Storm项目中的一个流数据监控模拟项目,涵盖了数据流的产生、处理和持久化,以及数据监控设计框架。"

在 Storm 项目中,流数据监控是一种重要的实时处理技术,用于对持续不断的数据流进行分析和管理。文章作者提到,他们计划通过一系列文章来分享关于 Storm 实时处理的代码实现,本文是系列的第一部分,主要关注项目的整体设计和基础架构。

1. 数据流产生:Spout

Spout 是 Storm 中数据流的源头,它负责生成或接收数据流。文章中提到了四种常用的数据流产生方式:

- 日志文件读取:直接从 log 文件中提取数据。

- 数据库获取:从 MySQL 或类似数据库中读取数据。

- 消息中间件:利用如 MetaQ 这样的中间件接收数据。

- 网络 socket:通过网络连接从远程服务接收数据。在本项目中,由于 MetaQ 尚未搭建,作者选择了读取日志文件作为数据源。

2. 数据处理:HandleBolt

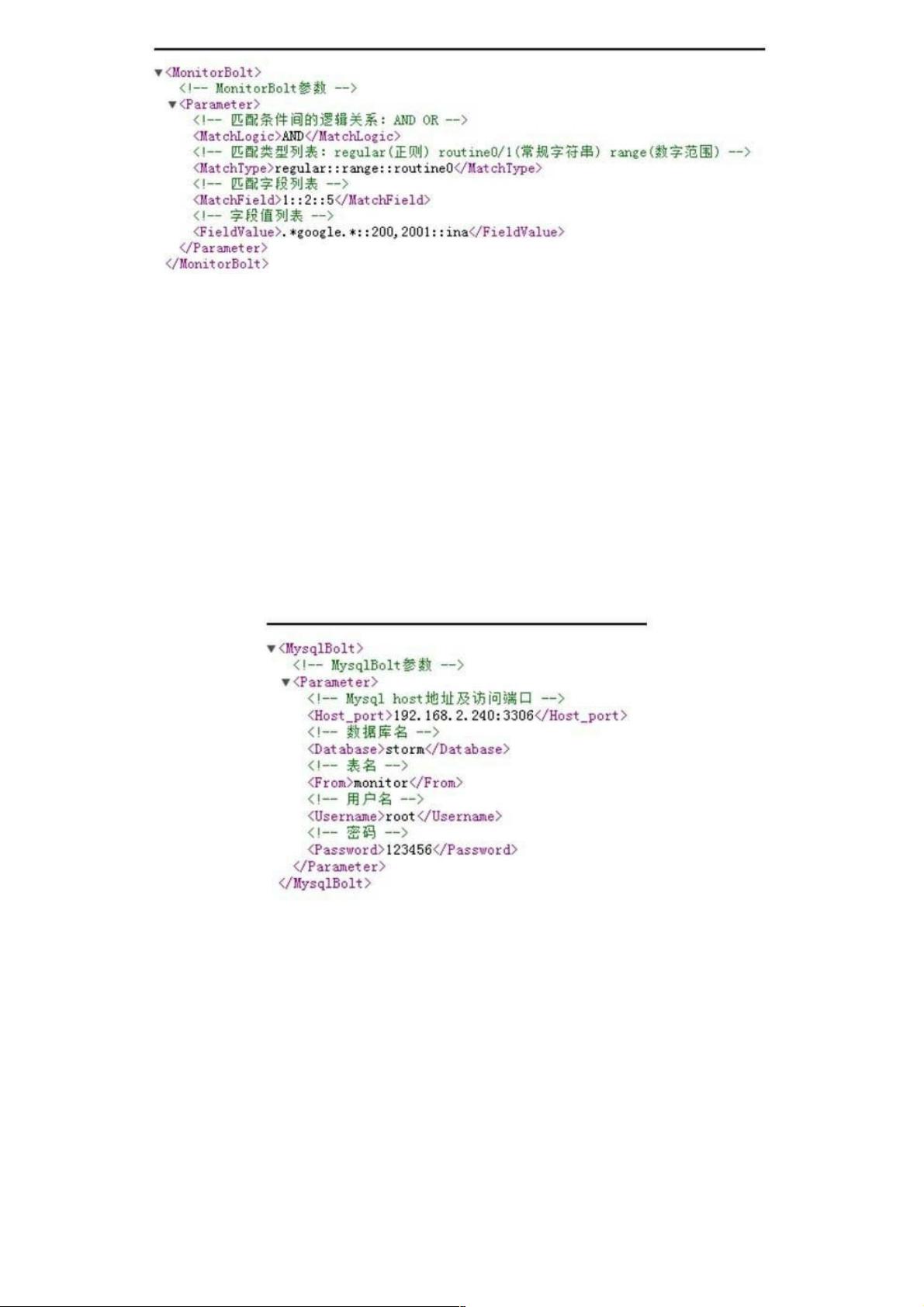

HandleBolt 是对数据进行各种操作的组件,包括过滤、添加、统计和监控等。在这个项目中,作者重点实现了数据监控功能,通过设定条件过滤数据,筛选出符合特定条件的数据进行进一步处理,支持多条件、多字段和多种逻辑判断的组合。

3. 数据持久化:LastingBolt

LastingBolt 负责将处理后的数据保存到持久化存储中。常见的持久化操作包括打印、写入文件、存储到数据库、发送到消息中间件或通过 Socket 发送。目前,项目实现了两种持久化策略:直接打印和存储到 MySQL 数据库,未来将扩展更多接口。

4. 数据监控设计框架

文章展示了数据监控的设计拓扑,由 ReadLogSpout 读取 domain.log 文件中的数据,然后传递给 MonitorBolt 进行处理。MonitorBolt 应用预定义的条件对数据进行筛选,保留需要监控的部分。这种设计允许系统实时地对流入的数据进行动态监控,及时发现异常情况。

通过这个流数据监控项目,读者可以了解到 Storm 在实时处理中的基本操作,包括数据的获取、处理和存储,以及如何构建一个简单的实时监控系统。后续文章将会逐步完善和扩展这个框架,包括引入其他数据源、增加更复杂的数据处理功能和持久化机制。

2015-09-22 上传

2015-09-22 上传

2015-09-22 上传

2023-06-12 上传

2024-06-13 上传

2024-06-13 上传

2023-04-25 上传

2023-09-09 上传

2023-06-11 上传

2023-04-19 上传

weixin_38593738

- 粉丝: 0

- 资源: 924

最新资源

- zlib-1.2.12压缩包解析与技术要点

- 微信小程序滑动选项卡源码模版发布

- Unity虚拟人物唇同步插件Oculus Lipsync介绍

- Nginx 1.18.0版本WinSW自动安装与管理指南

- Java Swing和JDBC实现的ATM系统源码解析

- 掌握Spark Streaming与Maven集成的分布式大数据处理

- 深入学习推荐系统:教程、案例与项目实践

- Web开发者必备的取色工具软件介绍

- C语言实现李春葆数据结构实验程序

- 超市管理系统开发:asp+SQL Server 2005实战

- Redis伪集群搭建教程与实践

- 掌握网络活动细节:Wireshark v3.6.3网络嗅探工具详解

- 全面掌握美赛:建模、分析与编程实现教程

- Java图书馆系统完整项目源码及SQL文件解析

- PCtoLCD2002软件:高效图片和字符取模转换

- Java开发的体育赛事在线购票系统源码分析