优化SVM:二阶多项式核与Kernel Trick简化计算

需积分: 0 4 浏览量

更新于2024-08-05

收藏 1.24MB PDF 举报

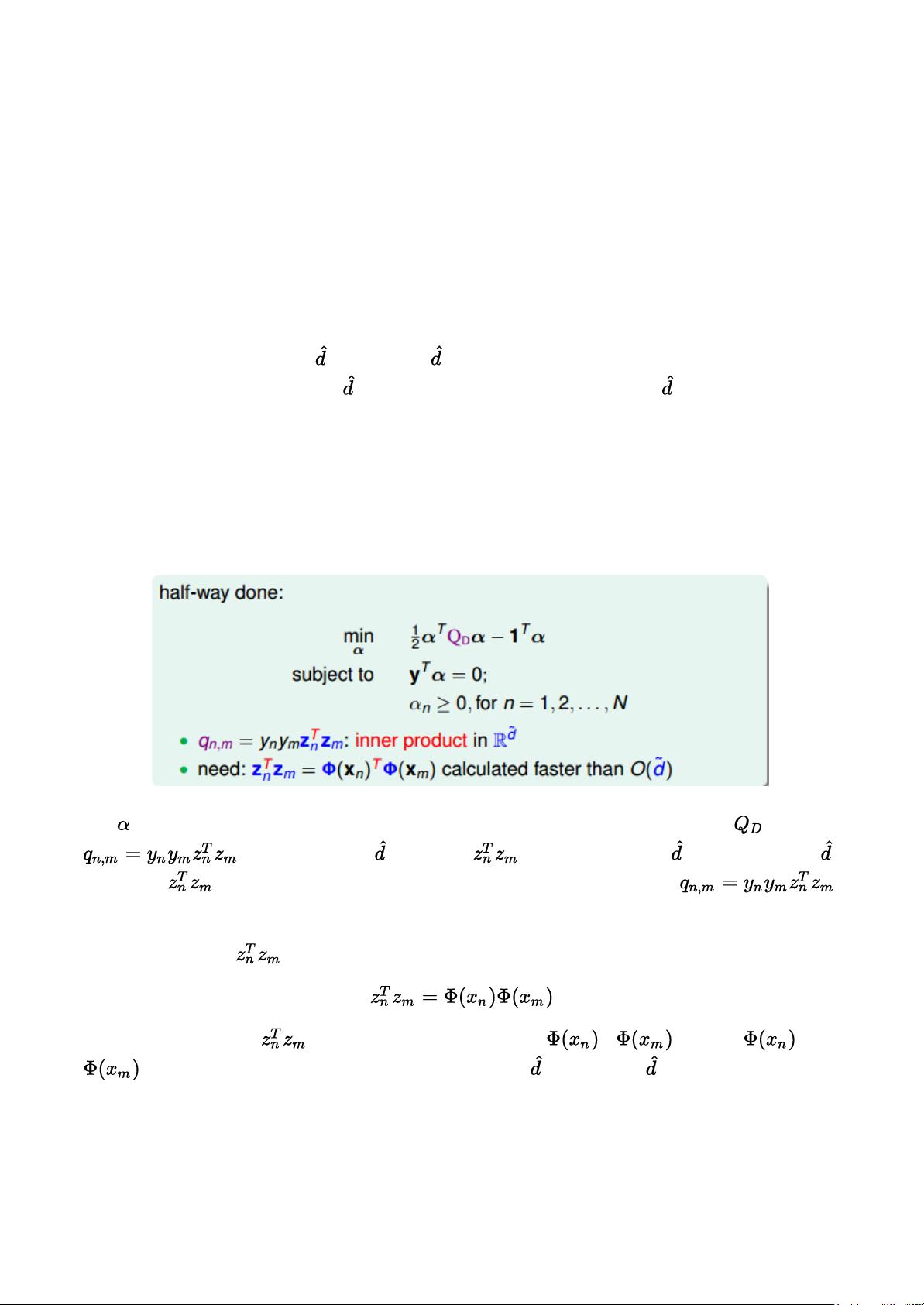

在林轩田的《机器学习技法》课程中,第三部分深入探讨了核支持向量机(Kernel Support Vector Machine,简称KSVM)的Kernel Trick。通常使用的二次多项式核函数是关键讨论点,其在标准形式下的SVM模型(如dual SVM)中,自由度决定了模型的复杂性和计算效率。自由度的增加会导致决策边界(SVM margin)变得更加复杂,且与高维特征空间中的内积计算直接相关,从而增加了计算的复杂度。

标准的二次多项式核函数形式为 \( K(x, x') = (x^T \cdot x' + c)^2 \),其中 \( c \) 是常数项。当样本数据维度 \( n \) 较大时,直接计算这种内积的复杂度随着维度的平方增长,成为优化问题(如QP)求解过程中的瓶颈。因此,通过Kernel Trick,将特征转换和内积计算结合在核函数\( K(x, x') \)中,能够将复杂的高维内积简化为低维空间的运算,从而避免了直接处理高维数据带来的计算困难。

具体来说,二阶多项式核函数的例子中,\( K(x, x') \) 可以表示为 \( (x^T \cdot x' + c)^2 \),在应用到SVM中时,系数 \( \alpha_i \) 中原本涉及 \( z \) 的部分被替换为 \( K(x_i, x_j) \),这样就消除了对原始特征空间 \( \mathcal{X} \) 的依赖,降低了计算量。通过这种方式,计算的复杂度不再依赖于特征空间的维度 \( n \),而是变为与样本空间维度 \( d \) 相关,大大提升了计算效率。

总结来说,Kernel Trick通过引入核函数,将非线性问题映射到低维空间中解决,这对于处理大规模或高维数据的SVM模型尤为重要,因为它允许我们在保持模型性能的同时,降低实际计算的复杂度。尽管二阶多项式核函数是一个特例,但它展示了这一方法的潜力,并为其他类型的核函数(如高斯核、多项式核等)提供了类似优化思路。通过理解并利用Kernel Trick,我们可以更有效地构建和训练复杂的机器学习模型。

106 浏览量

177 浏览量

181 浏览量

105 浏览量

2022-08-03 上传

2022-08-03 上传

106 浏览量

2022-08-03 上传

2022-08-03 上传

懂得越多越要学

- 粉丝: 28

- 资源: 307