信息论与编码第二版习题答案解析

需积分: 9 156 浏览量

更新于2024-07-27

收藏 4.48MB PDF 举报

信息论与编码答案

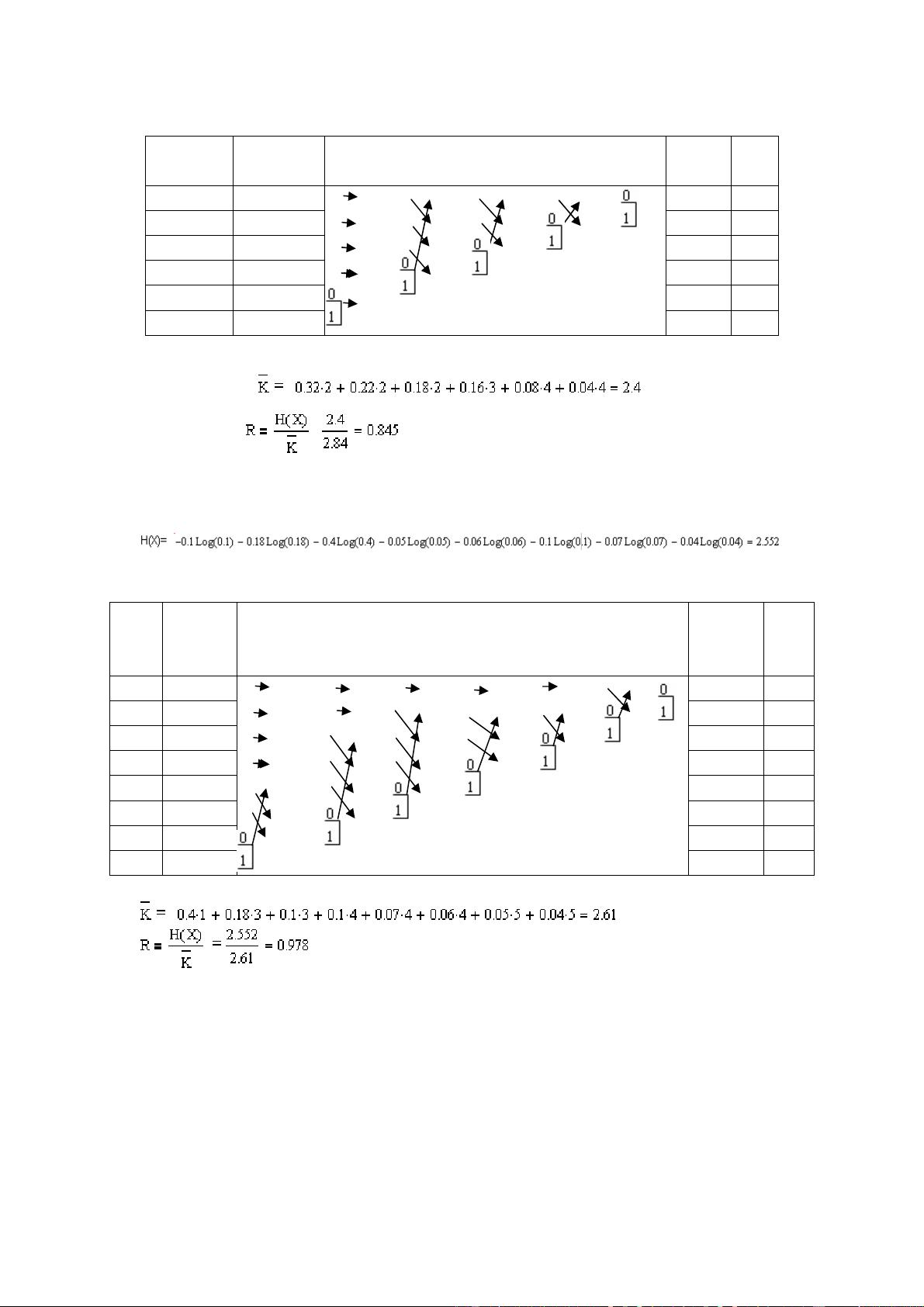

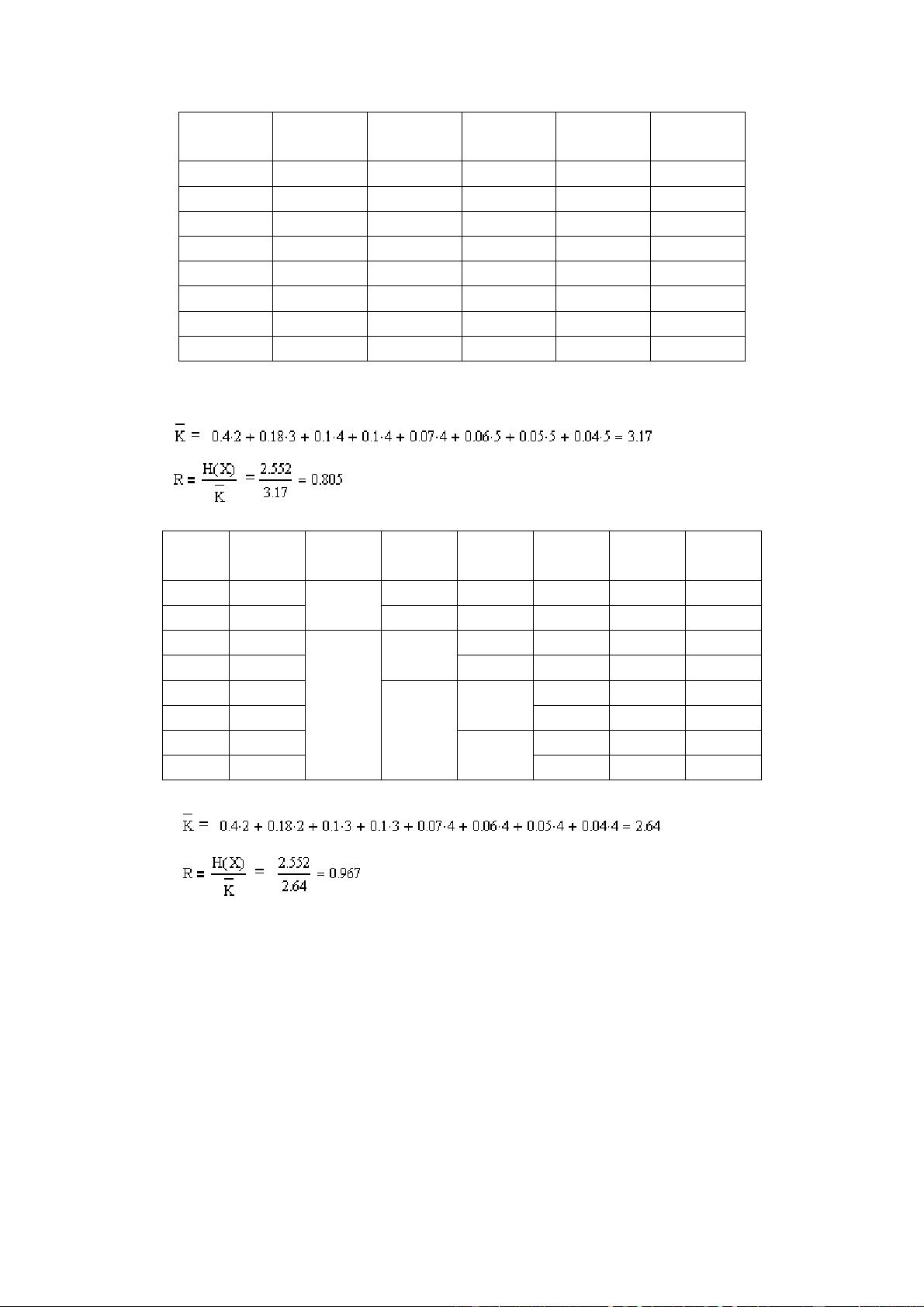

信息论与编码是计算机科学和信息技术的基础学科,涵盖信息的表示、存储、传输和处理等方面的知识。本节课答案涵盖信息论与编码的第二章信源及信源熵的知识点。

1. 信源熵(Source Entropy)

信源熵是指信源的不确定性或随机性,通常用符号H(X)表示。信源熵的计算方法有多种,包括直接计算、链式法则和条件熵计算等。

2. 信源熵的计算方法

信源熵的计算可以使用以下公式:

H(X) = - ∑[p(x) \* log2(p(x))]

其中,p(x)是信源的概率分布,log2是以2为底的对数。

3. 条件熵(Conditional Entropy)

条件熵是指在给定另外一个随机变量Y的条件下,信源X的不确定性。条件熵可以使用以下公式计算:

H(X|Y) = - ∑[p(x,y) \* log2(p(x|y))]

其中,p(x,y)是信源X和Y的联合概率分布,p(x|y)是信源X在给定Y的条件下的概率分布。

4. 互信息(Mutual Information)

互信息是指信源X和Y之间的相关性,通常用符号I(X;Y)表示。互信息可以使用以下公式计算:

I(X;Y) = H(X) + H(Y) - H(X,Y)

其中,H(X)和H(Y)是信源X和Y的熵,H(X,Y)是信源X和Y的联合熵。

5. 信源编码(Source Coding)

信源编码是指将信源的信息压缩到最小的比特数,以便于存储或传输。常用的信源编码方法包括Huffman编码、LZW编码等。

6. 信道编码(Channel Coding)

信道编码是指将信源信息编码以便于在信道中传输。常用的信道编码方法包括Hamming码、RS码等。

7. 信息论中的重要概念

信息论中还有许多其他重要概念,例如信息熵、相对熵、交叉熵等。这些概念都是信息论和编码理论的基础。

本节课答案涵盖了信息论与编码的第二章信源及信源熵的知识点,包括信源熵的计算、条件熵、互信息、信源编码和信道编码等。

114 浏览量

130 浏览量

点击了解资源详情

241 浏览量

2009-06-08 上传

152 浏览量

498 浏览量

jianzhuang22888

- 粉丝: 0

- 资源: 2

最新资源

- 易语言迷你SPY

- 03.2020保健品行业洞察及重点公司推荐.rar

- 随风资源互动共享系统 v1.1

- training2020

- openstad-react-admin

- 衡量其子项大小的小部件。-JavaScript开发

- 易语言远程控制本地控制台

- ios记忆力翻牌小游戏源码.rar

- docker-ejtserver:基于Alpine Linux的EJT许可证服务器映像

- 42nd-at-threadmill:SIMD加速的并发哈希表

- Arduino入门级DIY项目教程:绚丽五彩的智能IQ灯制作-电路方案

- project001:我的第一个项目

- Back_back2

- Discuz! 高贵典雅模板

- csso:具有结构优化功能CSS缩小器

- Cuomotype