机器学习基石:模型选择与验证策略

需积分: 0 130 浏览量

更新于2024-08-05

收藏 1.12MB PDF 举报

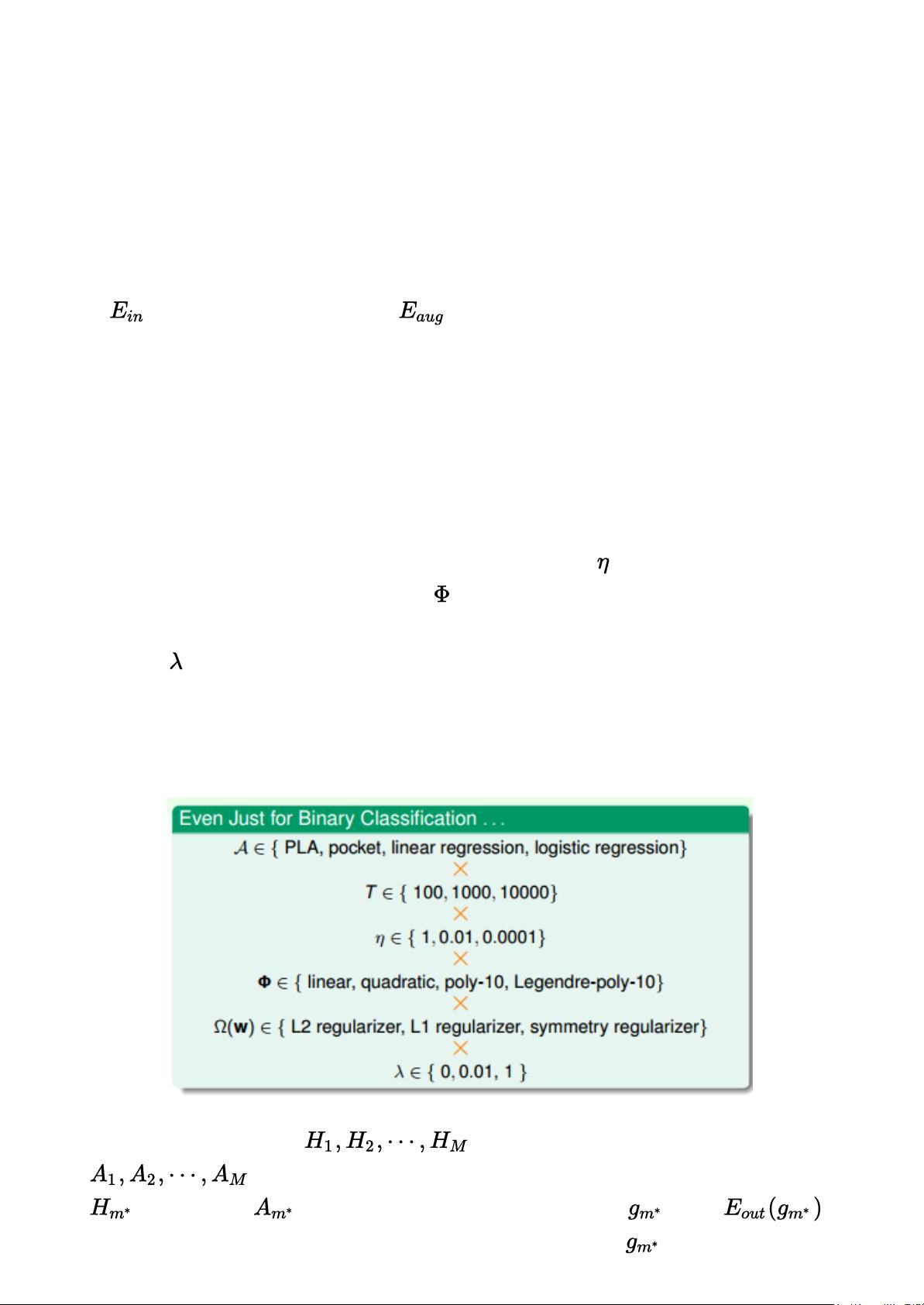

在林轩田的《机器学习基石》课程中,第15讲重点讨论了模型选择问题(Model Selection Problem)以及验证(Validation)方法在避免过拟合和提升模型泛化能力中的作用。在机器学习模型构建过程中,存在着众多参数和架构的决策,如算法选择(如PLA、pocket等)、迭代次数、学习率、特征转换类型(线性、多项式等)、正则化方式(L2、L1)和正则化系数等。这些选择对模型性能有着显著影响,目标是找到最优配置以达到最佳模型。

传统的模型选择方法包括直接比较每个模型在训练集上的性能指标,如误差平方和,选择使误差最小的模型。然而,这种方法存在局限性,因为训练误差低并不一定意味着模型具有良好的泛化能力,可能是因为过拟合导致的。过拟合的模型在新数据上的表现往往较差。

为了克服这个问题,引入了验证(Validation)的概念,其中一种方法是使用交叉验证(如Leave-One-Out Cross Validation 和 V-Fold)。Leave-One-Out Cross Validation 是一种将数据集分为N份,每次用N-1份进行训练,剩余一份用于验证,这样重复N次,每份数据都被用作一次验证。V-Fold 则是将数据集分为K个子集,进行K轮训练,每次用K-1个子集作为训练集,剩下的一个子集作为验证集。这两种方法可以更准确地评估模型的泛化能力,并且减少了因数据划分带来的偶然性。

另一种验证方法是使用独立的测试集,对模型在未见过的数据上的预测性能进行评估。如果测试误差(一般用损失函数衡量)较小,表明模型有较好的泛化能力。然而,选择测试集验证时,需要注意随着模型数量M的增加,验证复杂度也会相应提高,过度依赖测试集可能导致过度优化。

课程中引用的finite-Bin Hoffding不等式提供了一个量化模型选择的有效性的数学依据,它揭示了模型个数与验证结果稳定性的关系,帮助我们更好地平衡模型复杂度与泛化性能。通过合理的模型选择和验证策略,可以有效地提高机器学习模型的泛化能力,从而避免过拟合,确保模型在实际应用中表现出色。

2023-03-28 上传

2022-08-03 上传

2024-10-21 上传

2021-06-24 上传

2021-02-18 上传

2021-05-30 上传

2021-03-25 上传

2021-05-05 上传

2021-03-09 上传

王佛伟

- 粉丝: 21

- 资源: 319

最新资源

- 探索数据转换实验平台在设备装置中的应用

- 使用git-log-to-tikz.py将Git日志转换为TIKZ图形

- 小栗子源码2.9.3版本发布

- 使用Tinder-Hack-Client实现Tinder API交互

- Android Studio新模板:个性化Material Design导航抽屉

- React API分页模块:数据获取与页面管理

- C语言实现顺序表的动态分配方法

- 光催化分解水产氢固溶体催化剂制备技术揭秘

- VS2013环境下tinyxml库的32位与64位编译指南

- 网易云歌词情感分析系统实现与架构

- React应用展示GitHub用户详细信息及项目分析

- LayUI2.1.6帮助文档API功能详解

- 全栈开发实现的chatgpt应用可打包小程序/H5/App

- C++实现顺序表的动态内存分配技术

- Java制作水果格斗游戏:策略与随机性的结合

- 基于若依框架的后台管理系统开发实例解析

已收录资源合集

已收录资源合集