BERT模型在联合意图分类与插槽填充中的应用

需积分: 49 152 浏览量

更新于2024-09-05

收藏 391KB PDF 举报

"这篇文档是关于使用BERT模型进行意图分类和插槽填充的联合研究,主要探讨了如何利用BERT在自然语言理解中的潜力,尤其是在处理小规模人工标签数据时提升泛化能力。实验结果显示,基于BERT的联合模型在多个公共数据集上取得了优于传统RNN和联合学习模型的性能。"

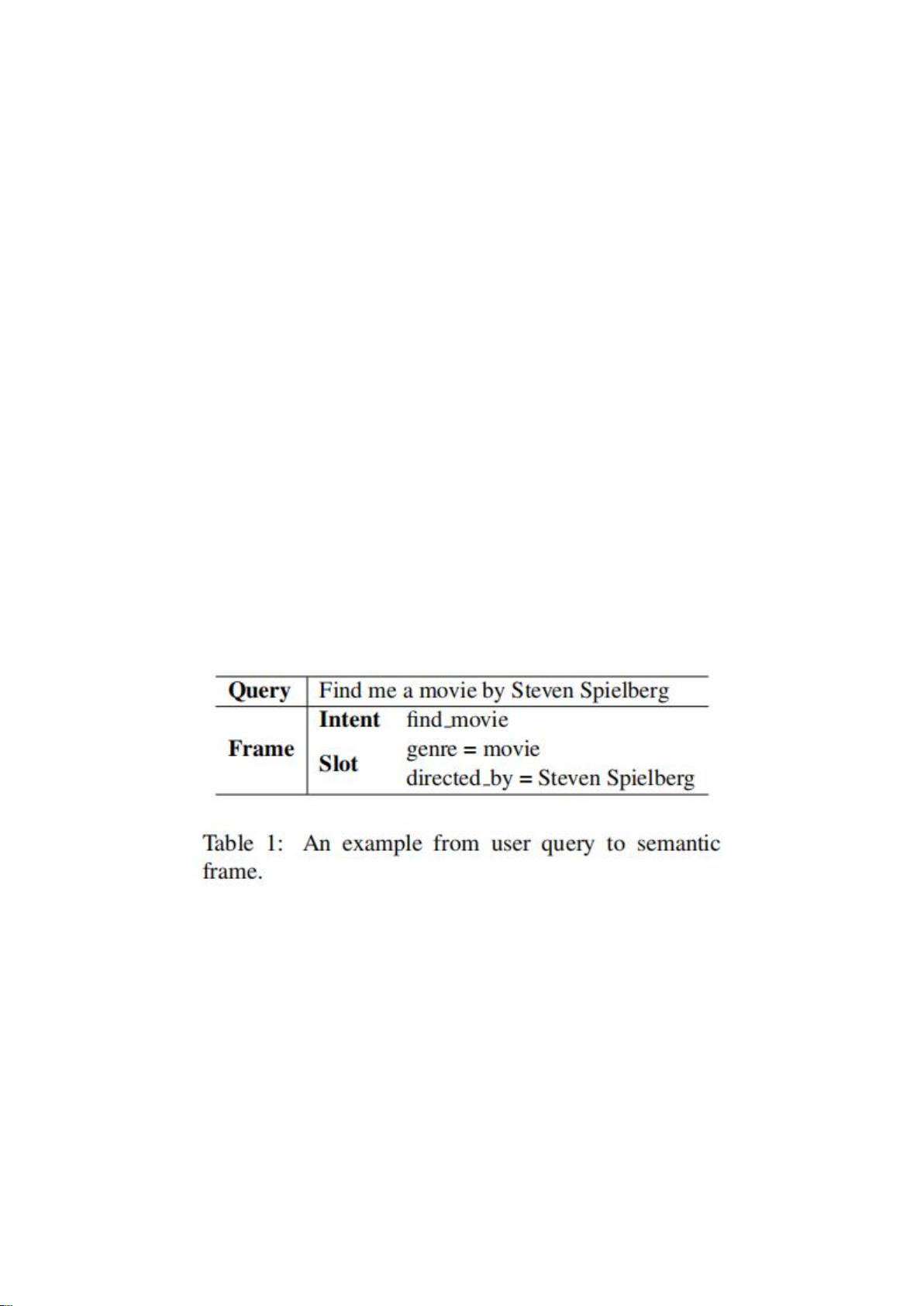

在自然语言处理领域,意图分类和插槽填充是关键的组成部分,用于理解和解析用户的口语请求。意图分类的任务是识别用户的话语意图,如在例子中用户想找到史蒂文·斯皮尔伯格导演的电影,而插槽填充则是识别并提取出具体的语义元素,如“找电影”和“史蒂文·斯皮尔伯格”。这两种任务的准确性和效率直接影响到对话系统的性能。

BERT,即双向编码器表示来自Transformer,是一种创新的语言表示模型,它通过在大规模无标注文本上预训练,学习到丰富的上下文信息,从而改进了传统的单向或双向模型。在经过微调后,BERT可以应用于各种NLP任务,并且已经在多项任务中创下了新纪录。

尽管BERT的潜力巨大,但在自然语言理解中的应用尚未得到充分研究。该论文提出了一个基于BERT的联合意图分类和插槽填充模型,试图利用BERT的深度双向表示能力,同时解决这两个任务。这种方法有望捕获任务间的相互依赖,提高整体性能。

实验比较了提出的BERT模型与基于注意力机制的递归神经网络(如GRU和LSTM)以及先前的联合学习模型。结果证明,BERT模型在意图分类的准确性、插槽填充的F1分数以及句子级语义框架的准确性方面都有显著提升。这表明,BERT的双向上下文理解能力对解决意图分类和插槽填充问题非常有效,特别是在处理低频词汇和小规模训练数据时。

总结来说,这篇文档揭示了BERT模型在自然语言理解中的优越性,特别是在意图分类和插槽填充的联合学习中,为对话系统和NLU研究提供了新的方向。通过结合BERT的深度学习能力,可以构建更强大、更准确的对话系统,更好地服务于用户需求。

2021-12-03 上传

2021-04-17 上传

2023-08-09 上传

2019-11-28 上传

2023-08-09 上传

2021-10-03 上传

2021-04-13 上传

2020-04-06 上传

2021-09-25 上传

Toyhom

- 粉丝: 33

- 资源: 3

最新资源

- Fisher Iris Setosa数据的主成分分析及可视化- Matlab实现

- 深入理解JavaScript类与面向对象编程

- Argspect-0.0.1版本Python包发布与使用说明

- OpenNetAdmin v09.07.15 PHP项目源码下载

- 掌握Node.js: 构建高性能Web服务器与应用程序

- Matlab矢量绘图工具:polarG函数使用详解

- 实现Vue.js中PDF文件的签名显示功能

- 开源项目PSPSolver:资源约束调度问题求解器库

- 探索vwru系统:大众的虚拟现实招聘平台

- 深入理解cJSON:案例与源文件解析

- 多边形扩展算法在MATLAB中的应用与实现

- 用React类组件创建迷你待办事项列表指南

- Python库setuptools-58.5.3助力高效开发

- fmfiles工具:在MATLAB中查找丢失文件并列出错误

- 老枪二级域名系统PHP源码简易版发布

- 探索DOSGUI开源库:C/C++图形界面开发新篇章