爬虫入门基础:从理论到实践

81 浏览量

更新于2024-08-28

收藏 261KB PDF 举报

【资源摘要信息】:“一看就明白的爬虫入门讲解:基础理论篇”

本文是一篇由诸葛IO创始人/CEO孔淼撰写的爬虫基础理论讲解,旨在帮助初学者理解爬虫的基本概念和工作原理。文章分为六个主要部分:

1. **我们的目的是什么**:通常,爬虫的目的是抓取网站或应用的内容,从中提取有价值的信息。这些信息可以是非结构化文本,如HTML,或者是结构化的数据。

2. **内容从何而来**:内容来源于网络请求,通过HTTP或HTTPS协议与服务器交互,获取网页或其他数据。

3. **了解网络请求**:网络请求包括GET和POST等方法,用于从服务器获取数据。GET用于获取静态资源,POST常用于提交数据。

4. **一些常见的限制方式**:网站可能通过反爬策略,如验证码、IP限制、User-Agent限制等来防止爬虫。需要通过模拟登录、更换IP、设置合理的请求间隔等方式应对。

5. **尝试解决问题的思路**:面对限制,可以采用代理IP、动态IP池、使用cookies维持会话、设置随机User-Agent、使用Selenium等工具模拟浏览器行为。

6. **效率问题的取舍**:在爬取大量数据时,要考虑爬虫的效率和资源消耗,可能需要使用多线程、分布式爬虫、任务队列等技术来提高速度和稳定性,同时要平衡与服务器的互动频率,避免被封禁。

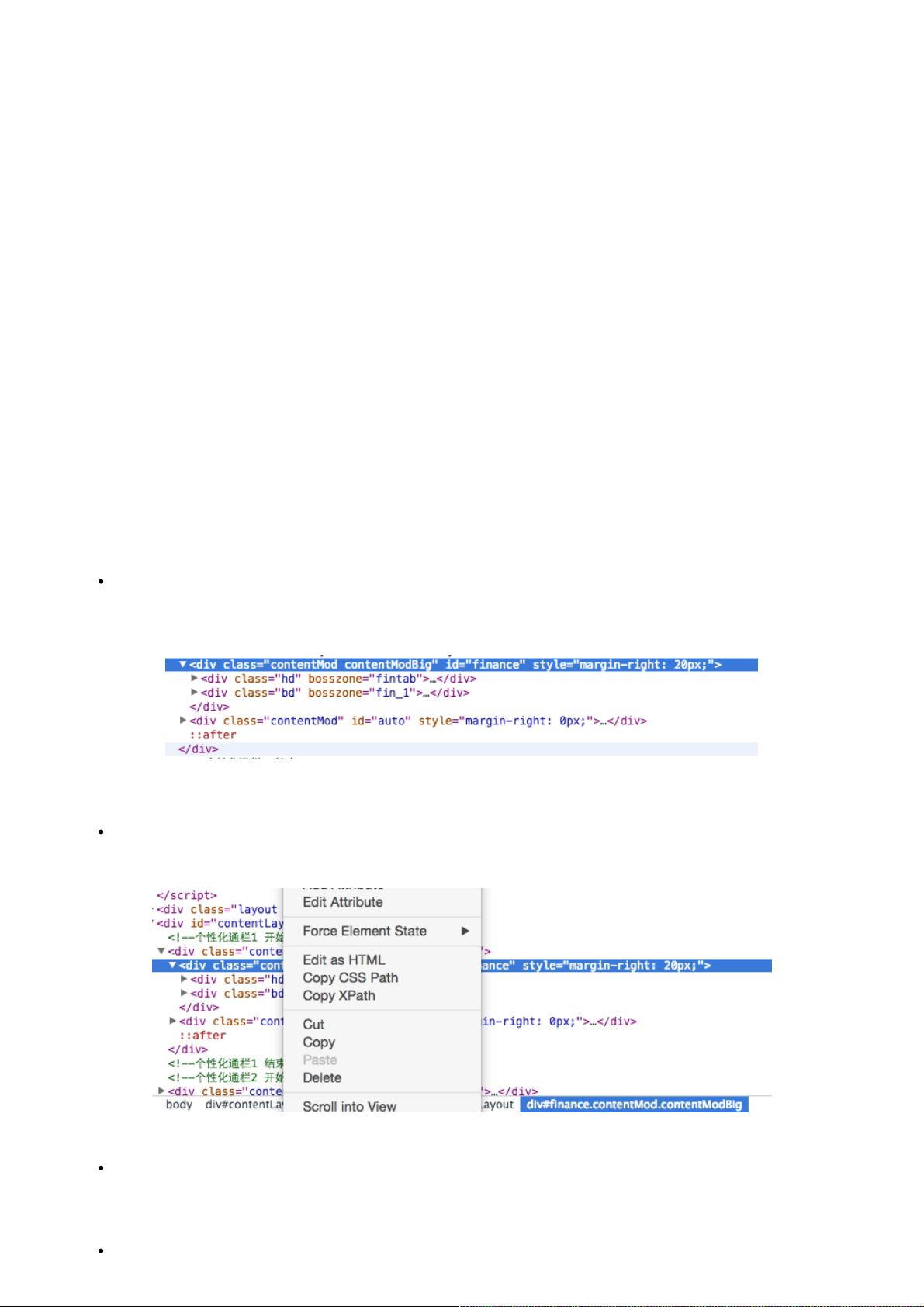

在讲解非结构化数据处理时,作者重点讨论了HTML文本。HTML虽然理论上是结构化的,但在实际爬取中,通常需要通过解析工具(如CSS选择器、XPath)或正则表达式来提取所需信息。此外,对于纯文本,可以通过分词技术进行处理,以提取关键词或进行语义分析。

对于CSS选择器,它可以精确地定位HTML元素,如通过id、class等属性选取目标。XPath则提供了另一种定位元素的方式,允许更灵活的路径表达。正则表达式适用于匹配特定格式的文本,而字符串分隔则是简单但可能不够精确的处理方法。

文章还提到,爬虫需遵循Robots协议,尊重网站的爬取规则,并注意合法合规性,以免引起法律纠纷。爬虫技术的应用广泛,从数据挖掘到市场分析,都需要对网络数据有深入的理解和高效的处理能力。学习爬虫,不仅可以提升数据分析能力,也为互联网时代的决策支持提供强大工具。

2021-08-14 上传

2019-03-21 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-06-06 上传

2023-09-09 上传

weixin_38628183

- 粉丝: 6

- 资源: 889

最新资源

- 十种常见电感线圈电感量计算公式详解

- 军用车辆:CAN总线的集成与优势

- CAN总线在汽车智能换档系统中的作用与实现

- CAN总线数据超载问题及解决策略

- 汽车车身系统CAN总线设计与应用

- SAP企业需求深度剖析:财务会计与供应链的关键流程与改进策略

- CAN总线在发动机电控系统中的通信设计实践

- Spring与iBATIS整合:快速开发与比较分析

- CAN总线驱动的整车管理系统硬件设计详解

- CAN总线通讯智能节点设计与实现

- DSP实现电动汽车CAN总线通讯技术

- CAN协议网关设计:自动位速率检测与互连

- Xcode免证书调试iPad程序开发指南

- 分布式数据库查询优化算法探讨

- Win7安装VC++6.0完全指南:解决兼容性与Office冲突

- MFC实现学生信息管理系统:登录与数据库操作