三层神经网络逼近连续函数:理论与实例

需积分: 11 172 浏览量

更新于2024-08-12

收藏 340KB PDF 举报

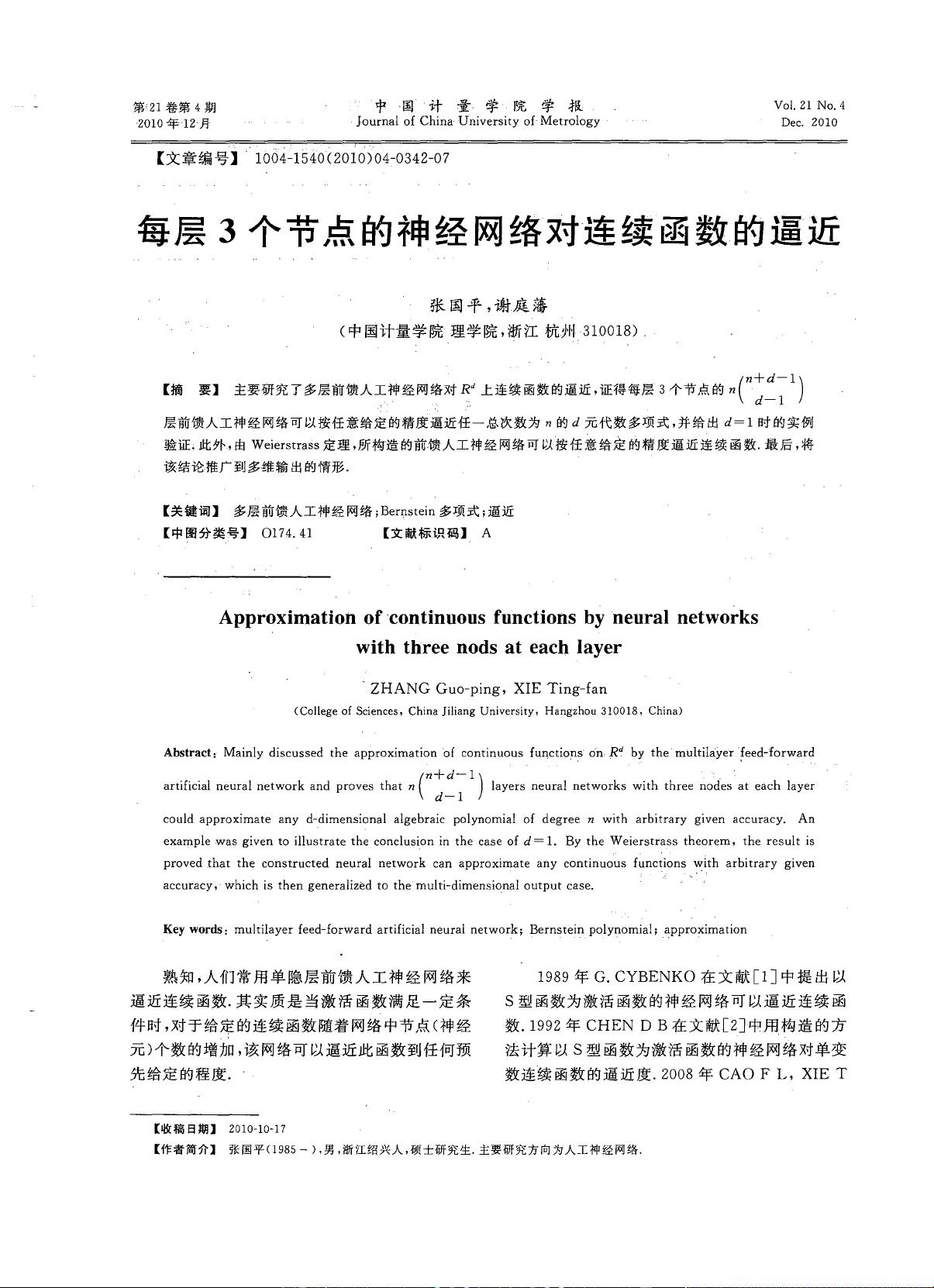

本文档深入探讨了每层包含三个节点的多层前馈人工神经网络在逼近连续函数方面的理论与应用。作者张国平和谢庭藩针对R^d(d维欧几里得空间)上的连续函数进行了细致的研究,他们证明了一个重要的结果:具有n层,每层有3个节点的神经网络能够以任意给定的精度逼近任何总次数为n的d元代数多项式。这一发现对于理解神经网络在数学建模和函数近似中的能力具有重要意义。

具体来说,通过使用Bernstein多项式,一种特殊的多项式基,论文展示了这种结构如何在单变量(d=1)的情况下进行实例验证,证明了其逼近性质的有效性。Bernstein多项式在神经网络理论中扮演了关键角色,因为它们可以方便地嵌入到网络的权重设置中,形成一种高效的学习策略。

论文进一步利用Weierstrass定理,这是实分析中的一个基石定理,它表明任何连续函数都可以在任何给定区间内被无限精细地逼近。因此,通过构建这样的神经网络,作者不仅证明了逼近多项式的可能性,也扩展了这一结论到多维输出的情况,这意味着这些网络可以处理非线性关系和复杂函数,不仅限于单个输出值。

这篇2010年发表在中国计量学院学报上的文章,其文献编号1004-1540,具有较高的学术价值,对于理解神经网络在数值分析、机器学习以及工程应用中的广泛适用性提供了坚实的理论基础。对于那些研究人工智能、深度学习或者数值计算的人来说,这是一篇值得深入阅读和参考的重要论文。

2016-11-24 上传

2011-08-18 上传

2012-08-20 上传

2020-05-06 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38738422

- 粉丝: 3

- 资源: 922

最新资源

- 黑板风格计算机毕业答辩PPT模板下载

- CodeSandbox实现ListView快速创建指南

- Node.js脚本实现WXR文件到Postgres数据库帖子导入

- 清新简约创意三角毕业论文答辩PPT模板

- DISCORD-JS-CRUD:提升 Discord 机器人开发体验

- Node.js v4.3.2版本Linux ARM64平台运行时环境发布

- SQLight:C++11编写的轻量级MySQL客户端

- 计算机专业毕业论文答辩PPT模板

- Wireshark网络抓包工具的使用与数据包解析

- Wild Match Map: JavaScript中实现通配符映射与事件绑定

- 毕业答辩利器:蝶恋花毕业设计PPT模板

- Node.js深度解析:高性能Web服务器与实时应用构建

- 掌握深度图技术:游戏开发中的绚丽应用案例

- Dart语言的HTTP扩展包功能详解

- MoonMaker: 投资组合加固神器,助力$GME投资者登月

- 计算机毕业设计答辩PPT模板下载