Flume:分布式日志聚合系统的可靠性与可扩展性解析

72 浏览量

更新于2024-08-29

收藏 282KB PDF 举报

"Flume日志收集"

Flume是Apache Hadoop生态中的一个关键组件,专门设计用于高效地收集、聚合和移动大量日志数据。它是一个分布式、可靠且高可用的系统,允许用户自定义数据源来收集数据,并将处理后的数据发送到各种可定制的数据接收端。

### Flume的主要特性

1. 可靠性

Flume提供了三种不同的可靠性级别以确保数据不丢失。最高等级的end-to-end可靠性意味着数据在被传输到接收方之前会先保存到磁盘,只有在成功传输后才会删除。Store-on-failure策略是在接收方崩溃时将数据存储在本地,等待恢复后继续发送。最低级别的Best effort策略则仅在数据发送后不做确认。

2. 可扩展性

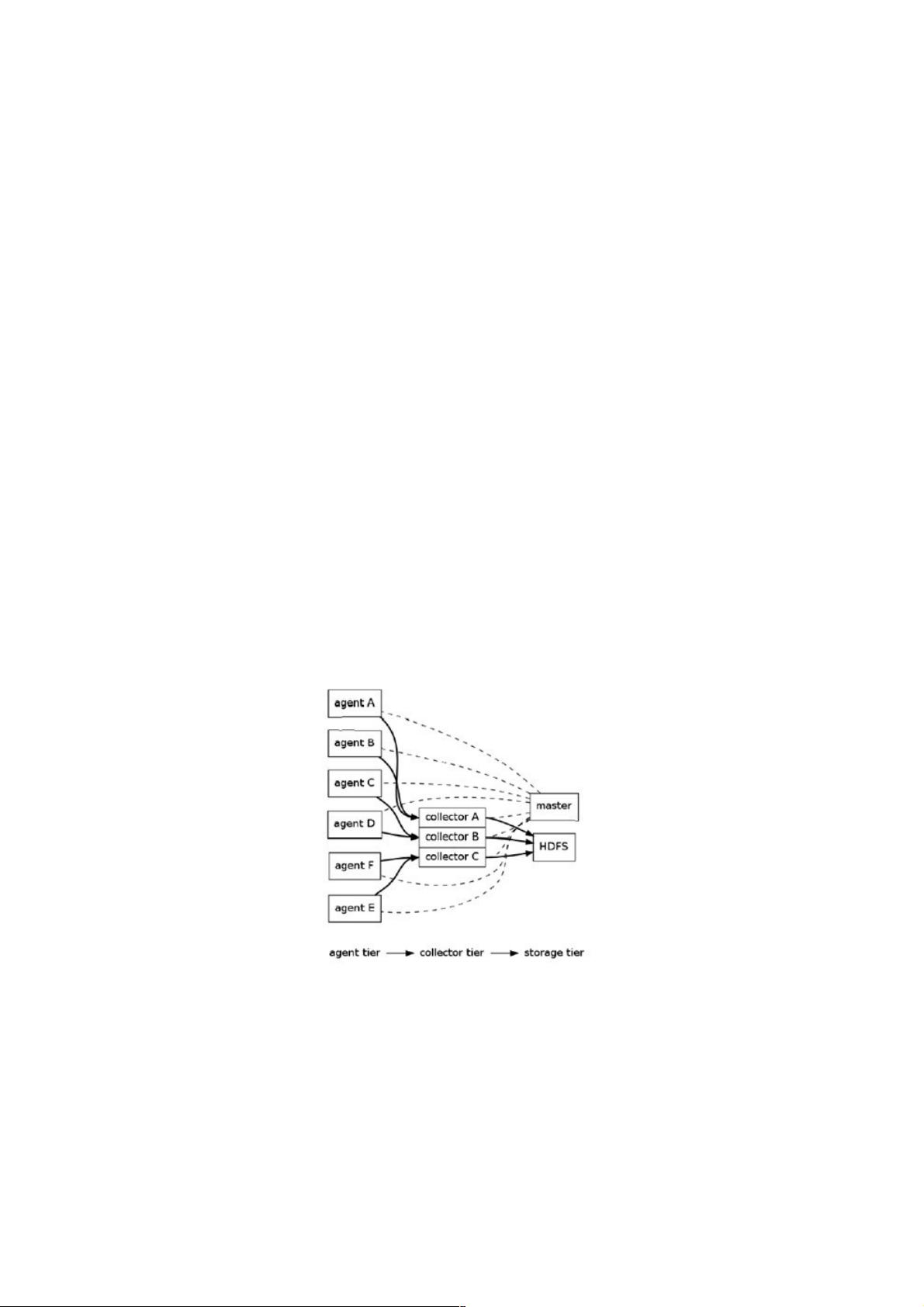

Flume的三层架构(agent、collector和storage)使其具有良好的可扩展性。agent和collector可以通过添加更多实例进行水平扩展,以处理更大规模的数据流量。通过使用多个master并借助ZooKeeper进行管理和负载均衡,Flume避免了单点故障问题。

3. 可管理性

所有的agent和collector都由master统一管理,便于监控和维护。多master设置下,Flume利用ZooKeeper和gossip协议保证动态配置数据的一致性。用户可以通过Web界面或shell脚本对数据流进行管理和配置。

4. 功能可扩展性

用户可以为Flume开发自定义的agent、collector和storage组件,以满足特定需求。Flume内置了多种预定义组件,如file、syslog等数据源,以及file、HDFS等数据存储选项。

### Flume架构

Flume的架构分为三个层次:

- Agent

Agent是Flume的基本工作单元,包含source和sink。Source负责从各种日志源(如应用程序、网络设备等)获取数据,而sink负责将数据发送到下一个处理阶段或最终目的地。

- Collector

Collector用于聚合来自多个agent的数据,可能进一步处理这些数据,然后将它们传递给storage。

- Storage

Storage是数据的最终归宿,可以是本地文件系统、HDFS、数据库或其他持久化存储解决方案。

Flume的Master和Node协同工作,Node根据Master上的配置动态调整其角色,作为Agent或Collector。这种灵活性使得Flume能够快速适应不断变化的日志收集需求。

Flume通过其强大的功能和灵活性,成为大数据环境中日志管理和分析的首选工具。它的设计考虑了高可用性和容错性,确保在大规模分布式系统中可靠地处理日志数据。通过合理配置和扩展,Flume能够有效地处理PB级别的日志数据,为日志分析和业务洞察提供强有力的支持。

点击了解资源详情

109 浏览量

122 浏览量

127 浏览量

2021-09-29 上传

426 浏览量

点击了解资源详情

weixin_38614462

- 粉丝: 4

最新资源

- 安装Oracle必备:unixODBC-2.2.11-7.1.x86_64.rpm

- Spring Boot与Camel XML聚合快速入门教程

- React开发新工具:可拖动、可调整大小的窗口组件

- vlfeat-0.9.14 图像处理库深度解析

- Selenium自动化测试工具深度解析

- ASP.NET房产中介系统:房源信息发布与查询平台

- SuperScan4.1扫描工具深度解析

- 深入解析dede 3.5 Delphi反编译技术

- 深入理解ARM体系结构及编程技巧

- TcpEngine_0_8_0:网络协议模拟与单元测试工具

- Java EE实践项目:在线商城系统演示

- 打造苹果风格的Android ListView实现与下拉刷新

- 黑色质感个人徒步旅行HTML5项目源代码包

- Nuxt.js集成Vuetify模块教程

- ASP.NET+SQL多媒体教室管理系统设计实现

- 西北工业大学嵌入式系统课程PPT汇总