深度解析Prompt-Tuning:微调新范式与应用探索

需积分: 5 184 浏览量

更新于2024-06-19

1

收藏 17.21MB PDF 举报

在本文中,我们将深度探讨Prompt-Tuning,这是一种全新的微调范式,尤其在深度学习领域,如大型语言模型(LLM)、自动创意生成内容(AIGC)以及如何利用这些模型构建特定领域的应用。作者王嘉宁通过NewBeeNLP公众号分享了他对prompt的理解,强调了其在自然语言处理(NLP)中的重要性。

首先,预训练语言模型(Pre-trained Language Models,PLMs)是通过大量未标注数据预先训练的基础模型,如BERT、GPT等,它们通过自监督学习任务(如Masked Language Modeling, NSP)来学习语言的普遍规律。Prompt作为一种指令或提示,引入是为了解决传统fine-tuning中过度拟合的问题,它能更高效地利用模型的泛化能力,避免重新训练整个模型。

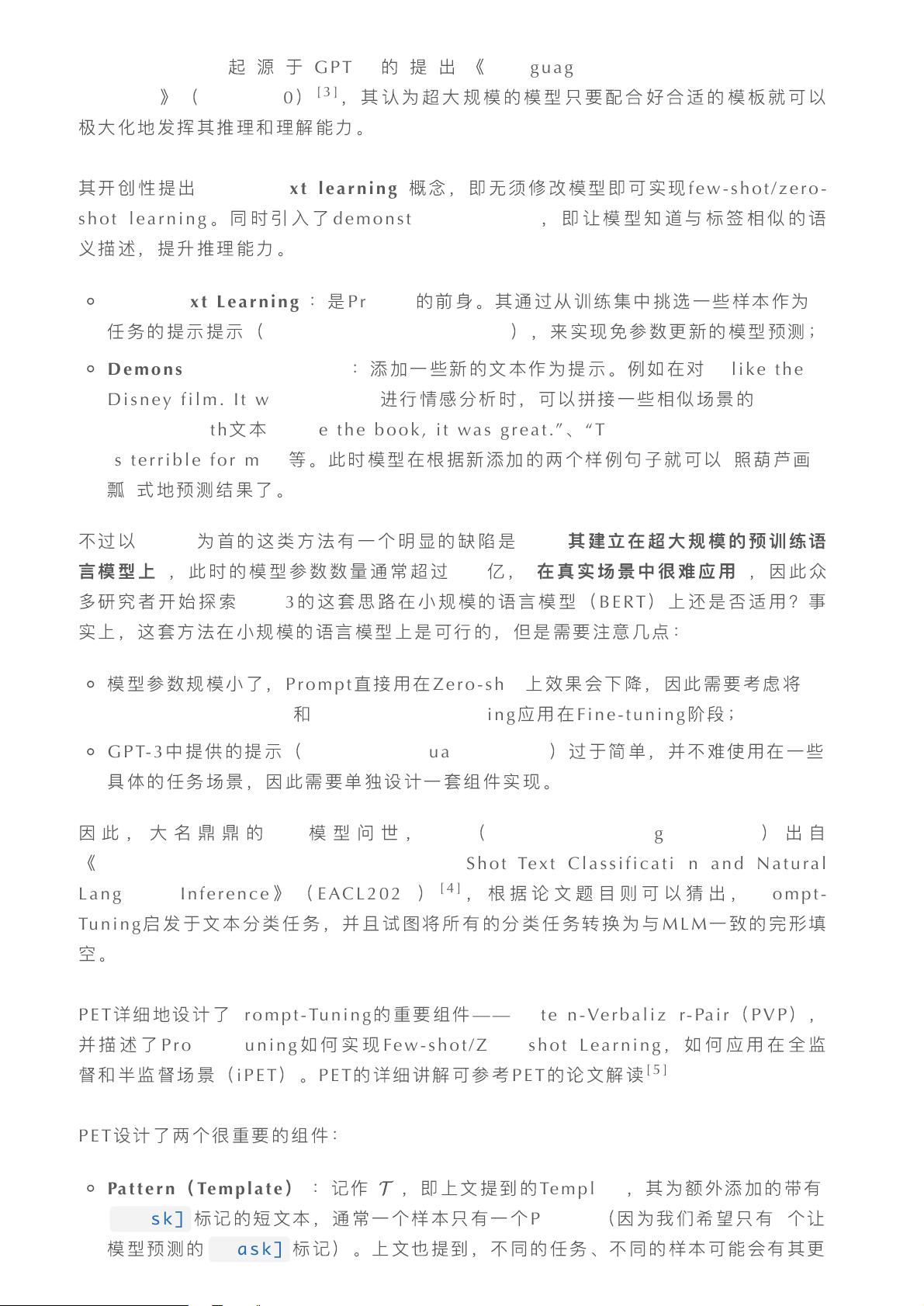

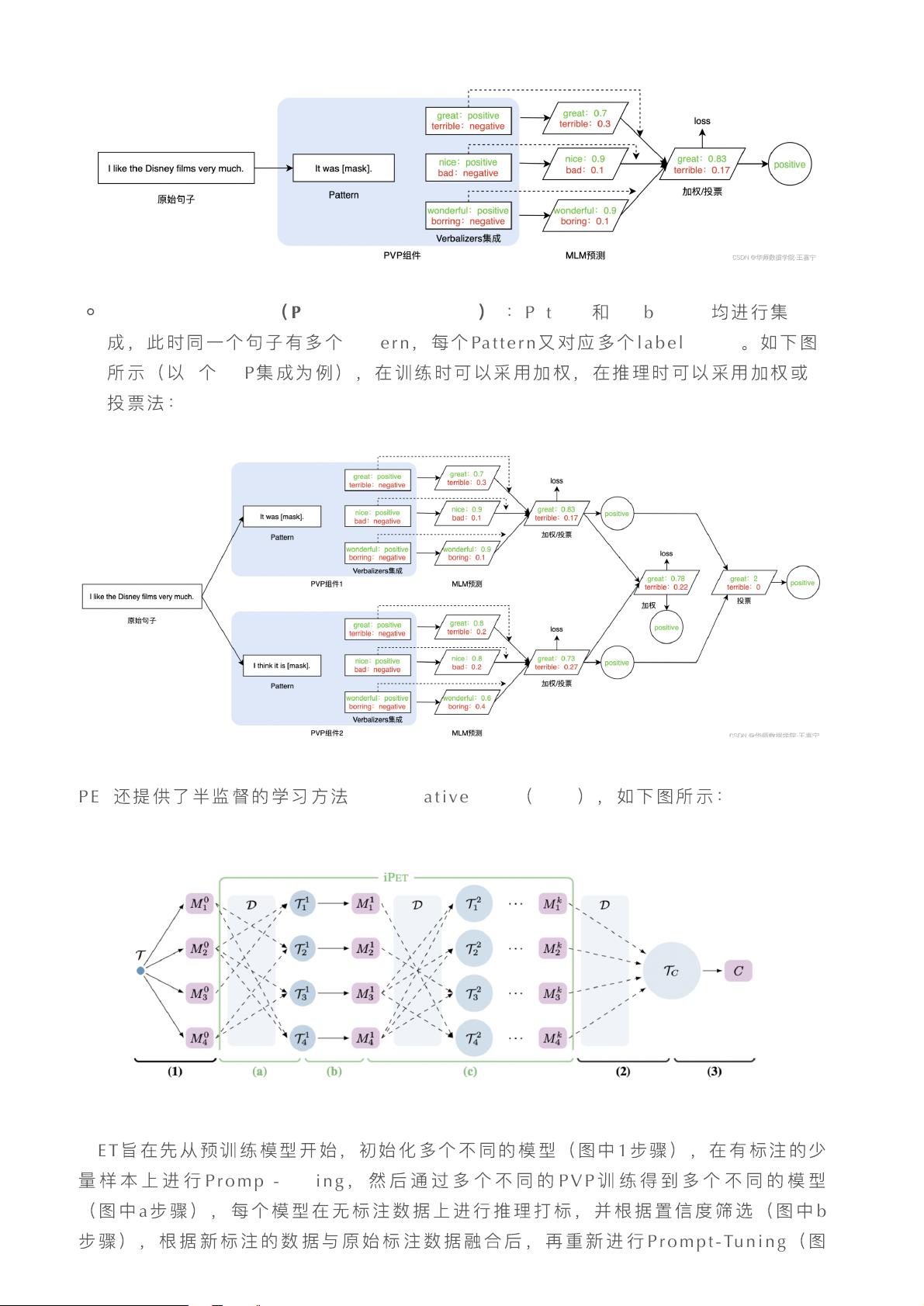

自2020年底以来,prompt技术经历了快速发展,包括离散和连续prompt的探索,以及针对超大规模模型的In-Context Learning(在上下文中学习)和Chain-Of-Thought(思维链)等创新方法。In-ContextLearning允许模型在不额外参数调整的情况下,仅通过示例或上下文理解新任务,而Chain-Of-Thought则鼓励模型展示思考过程,增强理解和生成能力。

对于不同的NLP任务,prompt的设计至关重要。这涉及到任务类型、上下文适应性和表达清晰度。例如,在文本分类任务中,可能需要创建明确的类别指示;而在问答或生成任务中,可能需要构造能够引导模型回答的问题形式。

在处理超大规模模型时,prompt-tuning展示了如何在保持模型参数有效性的前提下,进行有针对性的微调,以适应特定应用场景。这对于资源有限的情况尤其重要,因为它可以显著减少对新数据的需求。

面对黑盒模型,prompt技术提供了一种理解和控制模型决策的方法,使用户能够通过巧妙设计的提示来引导模型的行为,提高透明度和可控性。ChatGPT中的prompt技术展示了这一理念的应用,通过精心设计的提示引导模型产生高质量的回答。

文章最后展望了prompt技术的未来发展趋势,预训练语言模型将继续朝着对话式、生成式和多模态方向发展,强调与人类交互的自然性和安全性。同时,prompt-tuning作为核心技术,将在模型效率、性能优化和模型可解释性方面发挥关键作用。

通过阅读这篇博客,读者将深入理解prompt的概念、其在不同场景下的应用策略,以及它如何推动了预训练语言模型的进化,从而为研究人员和实践者提供了宝贵的知识和洞见。

2024-07-02 上传

2470 浏览量

2470 浏览量

点击了解资源详情

234 浏览量

179 浏览量

2024-11-06 上传

2024-11-06 上传

will4025

- 粉丝: 0

- 资源: 5

最新资源

- ipdrone

- BestRoute:以水平线和垂直线组成的网格形式的图形优化问题,驾驶员可以在该网格上行驶。 他想根据不同的标准(成本、持续时间、两者的贡献)为他找到最有利可图的路线。 一方面是计算最快和最便宜的路线,尊重速度限制。 第二部分是

- column-compression

- javascript:js

- 咨询建议书标准模板

- galaxiasoftwareteam.github.io

- s4:srnd.org自操作松弛系统

- STM32定时器捕获高电平时间程序

- 东风乘龙品牌整合规划及推广

- SBM-New-Landing_page

- Emotion-Tracer-with-Ellie

- madara-generator:轻松生成Madara来源

- open-source-starter:启动开源项目所需的一切

- MyCommTool.rar

- 某物业公司保洁操作流程的标准化

- young-hun-jo.github.io:GitHun页面