苏宁大数据平台的Spark应用与自动化分析

107 浏览量

更新于2024-08-29

收藏 2.32MB PDF 举报

苏宁大数据平台的架构设计与SparkApp自动化分析

苏宁大数据平台的计算引擎由离线计算、流式计算和OLAP引擎三部分组成。离线计算主要依赖于Spark和Hive,用于离线数据分析和挖掘。Spark提供高效处理能力,而Hive则提供了SQL接口,方便用户进行数据查询和分析。

流式计算方面,苏宁采用两种方式:准实时计算基于SparkStreaming,满足秒至分钟级的业务需求;实时流计算则由39个Storm集群支持,这些集群由1200台Openstack虚拟机(400台实体机)组成,苏宁早期还自主研发了StormSQL引擎Libra,使得Storm可以支持SQL操作。随着技术的发展,苏宁开始逐渐引入Flink,利用其强大的窗口计算和EventTime处理功能来应对更多复杂业务场景。

在OLAP领域,苏宁推崇Druid和ES作为主要引擎。Druid用于实时指标聚合计算,而ES则因其快速索引定位能力而被用于明细查询。

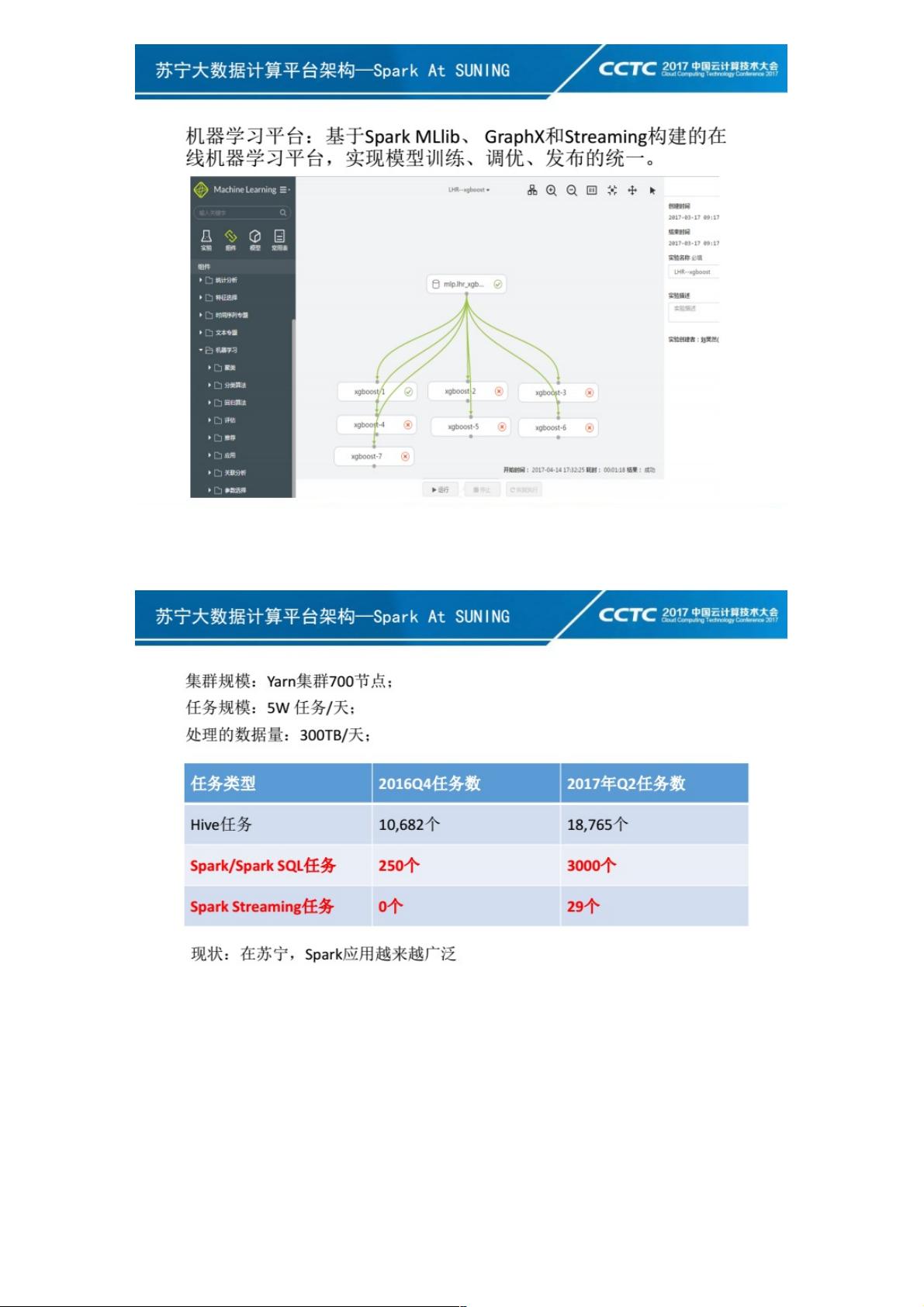

在平台化和工具支持方面,苏宁搭建了CBT任务流调度平台,它能够调度和管理多种类型的Spark、SparkSQL和数据交换任务。SSMP平台则专注于SparkStreaming任务的管理和调度,确保24小时的稳定运行。此外,苏宁还有一个在线机器学习平台,基于SparkMLlib实现,支持GPU环境下的深度学习,并提供模型训练、优化和发布的全套流程。

离线计算集群规模庞大,拥有700多个节点,每天处理超过5万个任务,数据量达到300TB。从图表中可以看出,苏宁的业务对Hive依赖较重,但正在逐步将Hive任务迁移至SparkSQL,以提升效率和性能。同时,Spark任务的数量也在持续增长,反映出Spark在苏宁大数据平台中的重要性日益增强。

苏宁大数据平台充分利用Spark的灵活性和高性能,结合其他如Hive、Storm、Druid、ES等工具,构建了一套完整的数据分析和处理体系,并通过自动化分析和故障诊断工具提升运维效率和服务质量。

162 浏览量

266 浏览量

点击了解资源详情

2021-09-30 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38735782

- 粉丝: 5

- 资源: 979