【自动化数据处理】:Sqoop与Oozie,调度作业的自动化策略

发布时间: 2024-10-26 03:51:30 阅读量: 30 订阅数: 21

Oozie调度SparkSQL样例代码_oozie_hive_

# 1. 自动化数据处理概述

随着大数据技术的不断进步,自动化数据处理已经成为IT行业提高效率、保障数据质量的关键手段。自动化不仅减少了重复性的手动劳动,还通过标准化流程和实时监控减少了数据错误的发生。本章将对自动化数据处理的概念、核心组件和应用场景进行简要介绍,为后续章节深入探讨特定工具如Sqoop和Oozie的使用与集成奠定基础。

自动化数据处理可以理解为一系列预先设定的规则和技术的组合,目的是使数据的抽取、转换和加载(ETL)过程尽可能地少有人为干预。在实际操作中,自动化数据处理涉及数据的采集、清洗、转换、存储和分析等环节,每一个环节都有可能借助不同的技术或工具来实现。

在探讨自动化数据处理的策略和工具之前,重要的是要认识到自动化能够带来的优势,包括但不限于提升数据处理的速度和准确性,减少因人为操作失误造成的数据问题,以及能够处理更大规模的数据集。接下来的章节将进一步阐释如何通过特定工具实现数据处理的自动化,及其在大数据环境中的具体应用。

# 2. Sqoop的基础知识与应用

### 2.1 Sqoop简介及数据迁移原理

#### 2.1.1 Sqoop的定义和作用

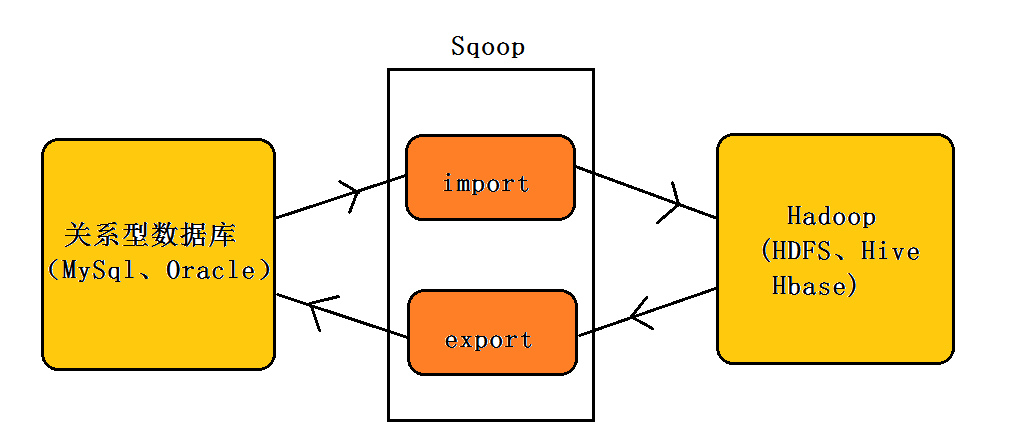

Apache Sqoop 是一个开源工具,旨在高效地在 Apache Hadoop 和结构化数据存储(如关系数据库)之间传输大量数据。它能够将批量导入(导入数据到 Hadoop)和导出(从 Hadoop 导出数据)操作简化为易于理解和管理的任务。Sqoop 利用 MapReduce 来并行化数据传输过程,并且最大限度地减少对源数据库系统的影响。

Sqoop 对于数据仓库任务来说是一个关键组件,尤其是对于那些需要频繁从传统数据库中提取数据,进行批量分析,然后将分析结果反馈到数据库中的场景。它为数据工程师提供了一种快速、可靠的方式来将数据从关系型数据库迁移到 Hadoop 集群中,反之亦然。

#### 2.1.2 数据迁移的基本流程和组件

Sqoop 的数据迁移流程主要涉及以下组件:

- **Sqoop客户端**:用于提交导入或导出任务。

- **数据源**:如关系数据库管理系统(DBMS),用于提供要迁移的数据或接收数据的系统。

- **数据传输协议**:如 JDBC,用于Sqoop和数据源之间的通信。

- **数据目标**:Hadoop 文件系统(HDFS)或 HBase,用于存储导入的数据或作为导出操作的数据源。

基本流程包括:

1. **数据识别**:通过Sqoop客户端指定要迁移的数据表或查询。

2. **数据传输**:通过JDBC连接到数据源并使用MapReduce作业来传输数据。

3. **数据导入或导出**:将数据存储到Hadoop的目标位置或从Hadoop读取数据并写入到目标数据库。

### 2.2 Sqoop的核心功能与使用案例

#### 2.2.1 数据导入导出工具的使用

数据导入是将外部数据存储在 Hadoop 中的过程,而数据导出是将数据从 Hadoop 环境中导出到外部存储系统的过程。Sqoop 提供了命令行工具来执行这些操作。以下是导入操作的基本命令:

```bash

sqoop import \

--connect jdbc:mysql://localhost:3306/mydb \ # 数据库连接字符串

--username root \ # 数据库用户名

--password mypassword \ # 数据库密码

--table mytable \ # 指定数据库中的表名

--target-dir /user/hive/warehouse/mytable \ # 数据导入到HDFS的目标目录

--fields-terminated-by ','; # 字段分隔符

```

此命令将指定的数据库表 `mytable` 中的数据导入到 HDFS 的指定路径。同样,数据导出会使用类似的命令,但方向相反。

#### 2.2.2 数据类型映射与转换

Sqoop 在迁移过程中自动处理数据类型映射。它会将关系型数据库中的数据类型转换为 Hadoop 环境中相应的类型。例如,MySQL 中的 `INT` 类型会转换为 Hadoop 中的 `IntWritable` 类型。然而,在某些情况下,可能需要手动指定或调整这些映射,Sqoop 通过 `--map-column-java` 参数提供了这样的灵活性。

```bash

sqoop import \

--connect jdbc:mysql://localhost:3306/mydb \

--username root \

--password mypassword \

--table mytable \

--target-dir /user/hive/warehouse/mytable \

--map-column-java 'id=Long, name=String'; # 映射数据类型

```

#### 2.2.3 大数据环境下的数据迁移策略

数据迁移策略需要考虑数据量大小、数据访问模式、集群资源和数据一致性等因素。在大数据环境下,通常需要采用分批处理的方式来迁移大量数据,以减少对源数据库的负载,并确保 Hadoop 集群的稳定性。Sqoop 的批处理通过 `--split-by` 参数来实现。

```bash

sqoop import \

--connect jdbc:mysql://localhost:3306/mydb \

--username root \

--password mypassword \

--table mytable \

--target-dir /user/hive/warehouse/mytable \

--split-by id \ # 按某个字段分批

--num-mappers 10; # 同时运行的Map任务数

```

### 2.3 Sqoop的高级配置与优化

#### 2.3.1 优化数据传输性能的方法

为了优化数据传输的性能,需要考虑执行的并行度、数据压缩、任务调度等因素。一个重要的配置是调整 `num-mappers` 参数来控制并行度。Sqoop 会为每个 mapper 创建一个数据库连接,所以需要合理选择这个值,以避免数据库连接过多而影响性能。

另一个关键点是数据压缩。使用 `--compress` 和 `--compression-codec` 参数可以启用数据压缩,减少网络传输的数据量。

```bash

sqoop import \

--connect jdbc:mysql://localhost:3306/mydb \

--username root \

--password mypassword \

--table mytable \

--target-dir /user/hive/warehouse/mytable \

--num-mappers 10 \

--compress \ # 启用压缩

***press.GzipCodec; # 使用Gzip压缩算法

```

#### 2.3.2 Sqoop的并行处理和故障恢复机制

Sqoop 支持并行处理,它通过拆分任务到多个 MapReduce 任务来提高效率。配置并行度需要权衡资源使用和性能增益。配置合理的 `--num-mappers` 参数可以显著

0

0