【数据清洗整合】:数据清洗与Sqoop,优化ETL流程的黄金法则

数据迁移实践:Sqoop从MySQL到HDFS、Hive的数据传输详解

1. 数据清洗整合基础与重要性

在当今的信息时代,数据已经成为企业最宝贵的资源之一。然而,这些原始数据往往包含错误、不一致和重复的信息,使得数据分析和决策过程变得复杂和不可靠。因此,数据清洗整合成为了数据科学、数据分析和数据仓库等领域的一个基础而关键的步骤。

1.1 数据清洗整合的必要性

数据清洗整合的主要目的是提高数据的质量,保证数据的准确性和一致性。这对企业了解市场动态、做出策略决策和优化业务流程至关重要。没有经过清洗和整合的数据,就像是一条杂乱无章、泥沙俱下的河流,无法直接为灌溉和饮用提供帮助。

1.2 数据清洗整合的影响

通过有效的数据清洗整合,企业可以:

- 提高数据分析结果的可靠性;

- 优化业务流程和决策效率;

- 降低系统存储成本并提升系统性能。

数据清洗整合不仅改善了数据的质量,还为后续的数据应用铺平了道路,例如数据仓库构建、商业智能报告、机器学习模型训练等。

在下一章节中,我们将深入探讨Sqoop工具,它是在数据清洗整合过程中将数据从关系型数据库高效导入到Hadoop生态系统中的重要工具。通过其强大的数据迁移和转换功能,Sqoop在数据清洗整合工作中扮演着不可或缺的角色。

2. Sqoop工具详解

2.1 Sqoop的安装与配置

2.1.1 Sqoop的环境搭建

Sqoop是一款开源工具,主要用于在Hadoop与关系型数据库之间高效地传输批量数据。安装Sqoop前,首先需要确保Java环境已经搭建好,并且要求JDK的版本至少为Java 8。接着,下载并解压Sqoop的安装包,然后通过修改Sqoop的配置文件来指定Hadoop的配置目录,确保Sqoop可以找到Hadoop的环境配置。

下面是一个简单的Sqoop环境搭建流程:

- 首先下载Sqoop,从其官方网站下载最新的稳定版本。

- 解压下载的文件,命令如下:

- tar -zxvf sqoop-版本号.tar.gz

- 配置Sqoop环境变量,编辑用户的

.bashrc或.bash_profile文件,添加Sqoop的bin目录到PATH变量中:

- export PATH=$PATH:/path/to/sqoop/bin

- 检查Java环境变量,确保Java已正确安装,并且JAVA_HOME指向了正确的Java安装目录。

2.1.2 Sqoop的核心组件和架构

Sqoop的架构设计让它能够高效地执行数据传输任务。Sqoop的核心组件包括:

- Sqoop客户端:用户与Sqoop进行交互的主要接口。

- Sqoop服务器:可选组件,可以执行长期运行的任务。

- 连接器:负责Hadoop与特定数据库之间的连接,支持多种数据库系统,如MySQL, Oracle等。

- 映射器:将关系型数据库的数据表映射到Hadoop的数据目录结构。

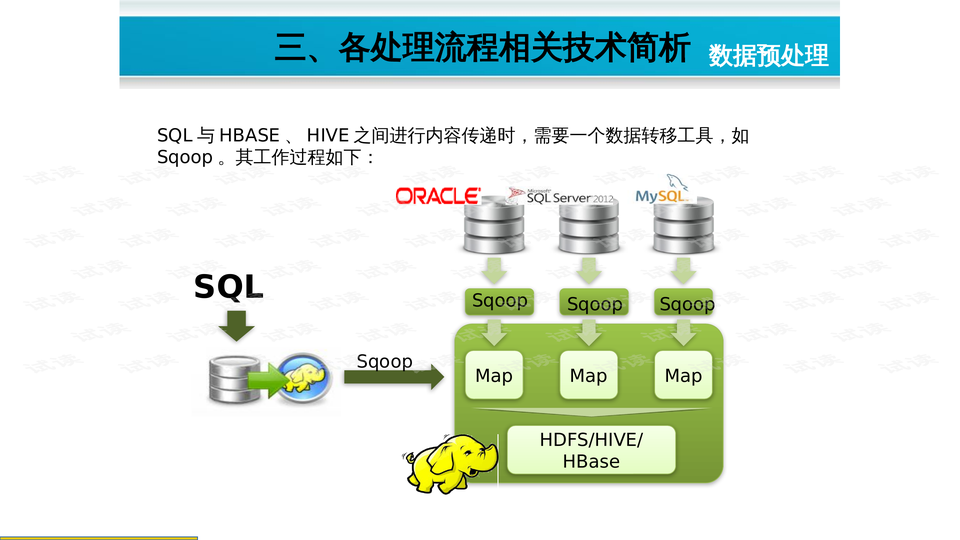

Sqoop的基本工作流程是:Sqoop客户端通过连接器读取关系型数据库中的数据,并利用映射器将数据切分为多个部分,每个部分由一个Mapper任务在Hadoop集群上并行处理。

2.2 Sqoop的数据导入导出机制

2.2.1 导入数据到Hadoop的步骤与技巧

导入数据到Hadoop涉及几个关键步骤,包括数据库连接、数据选择和数据传输。使用Sqoop导入数据的常见命令如下:

- sqoop import \

- --connect jdbc:mysql://localhost:3306/database_name \

- --username username \

- --password password \

- --table table_name \

- --target-dir /user/hive/warehouse/database_name.db/table_name

在导入数据时,可以考虑一些优化技巧:

- 分区:对数据进行分区,可以提高导入的并行度,并且有助于后续的Hive查询优化。

- 列选择:如果不需要导入表中的所有列,可以选择性地只导入需要的列。

- 预提取数据:使用Sqoop的

--where参数来限定要导入的数据,减少导入的数据量,提高效率。

2.2.2 从Hadoop导出数据到关系型数据库的方法

从Hadoop导出数据到关系型数据库,Sqoop同样提供了灵活的选项。基本的命令格式如下:

- sqoop export \

- --connect jdbc:mysql://localhost:3306/database_name \

- --username username \

- --password password \

- --table table_name \

- --export-dir /user/hive/warehouse/database_name.db/table_name \

- --input-fields-terminated-by '\t'

在这个过程中,可以使用以下技巧来优化导出操作:

- 字段分隔符:使用

--input-fields-terminated-by参数来指定字段的分隔符,以确保数据能够正确地被数据库接收。 - 增量导出:使用

--check-column和--last-value参数来实现增量更新,只导出变更的数据。

2.3 Sqoop的高级特性与优化

2.3.1 Sqoop的并行数据传输

Sqoop支持通过并行传输来提高数据传输的速度。在导入或导出数据时,Sqoop可以启动多个Map任务,每个任务处理数据的一个分区。并行性可以通过--num-mappers参数来控制。

- sqoop import --connect ... --table ... --num-mappers 10 ...

在并行传输中需要注意的是,高并行度虽然可以加快数据传输速度,但同时也可能增加数据库的负载。因此,在生产环境中需要根据数据库的性能来调整并行度。

2.3.2 Sqoop连接器的高级配置

Sqoop连接器配置允许用户对如何连接数据库进行更细致的控制。它包括数据库连接超时设置、批处理大小以及是否启用压缩等选项。例如,可以设置连接器的批处理大小来优化性能:

- sqoop import --connect ... --batch ... --batch-fetch-size 1000 ...

以上代码表示,在导入数据时,每个数据库连接可以一次性抓取1000条记录,而不是默认的单条。这可以减少数据库I/O的次数,提高数据传输效率。

通过这些高级特性的应用,Sqoop的数据导入导出过程可以更加高效和灵活地适应不同的数据处理需求。在实际操作中,还需要结合具体的业务场景和数据特性来合理配置这些参数。

表格:Sqoop连接器选项比较

| 选项 | 描述 | 默认值 |

|---|---|---|

| –batch | 启用批处理模式 | false |

| –batch-fetch-size | 设置批处理的抓取大小 | 10 |

| –compress | 启用数据压缩 | false |

| –connect | 指定JDBC URL | null |

| –delete-target-dir | 删除目标目录之前导入失败则退出 | false |

| –direct | 使用直接路径传输 | false |

| –fetch-size | 设置JDBC的抓取大小 | 100 |

| –incremental | 增量导入模式,需要指定–check-column和- |