【大数据处理新趋势】:Sqoop与Spark,框架整合的前沿案例

发布时间: 2024-10-26 03:38:33 阅读量: 32 订阅数: 21

java+sql server项目之科帮网计算机配件报价系统源代码.zip

# 1. 大数据处理的现状与挑战

大数据是现代信息社会的重要资源,它推动着业务决策、产品创新和社会进步。随着互联网、物联网等技术的发展,数据量的爆发式增长带来前所未有的机遇和挑战。在此背景下,大数据处理技术应运而生,旨在通过有效管理和分析巨量数据,从中挖掘出有价值的信息。

本章节将深入探讨大数据处理的现状,分析其在各行业中的应用,并揭示在实现高效数据处理方面所面临的挑战。从数据采集、存储到数据处理,再到最终的数据分析和利用,每个环节都充满了技术挑战。同时,我们将讨论大数据生态系统的多样性和复杂性,以及如何在保障数据安全的前提下,实现数据价值的最大化。在接下来的章节中,我们将详细了解如何利用Sqoop和Spark等大数据处理框架应对这些挑战,并通过具体的实践案例,展示如何在实际工作中解决遇到的问题。

# 2. Sqoop框架的理论与实践

## 2.1 Sqoop基础概念

### 2.1.1 Sqoop简介

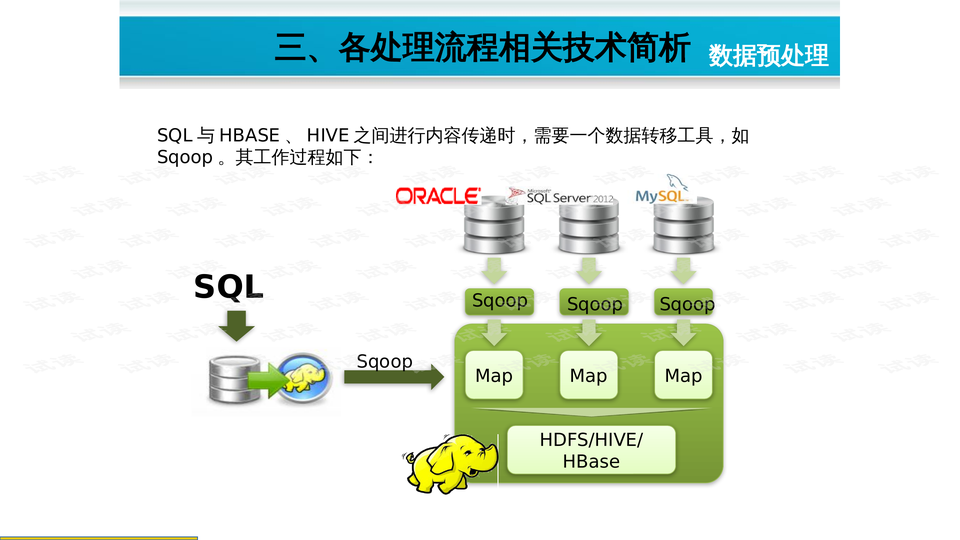

Sqoop是一个开源工具,专门用于在Hadoop的HDFS(Hadoop Distributed File System)和关系数据库服务器之间高效传输批量数据。它是Apache基金会下的一个子项目,为大数据环境提供了一个便捷的数据迁移路径。

Sqoop的设计目的是使数据的导入导出操作对于用户来说既简单又高效。通过使用Sqoop,可以将关系数据库中的数据快速转移到Hadoop集群进行分析处理,也可以将Hadoop集群中的处理结果导出回关系数据库,以供其它系统使用。

### 2.1.2 Sqoop的工作原理

Sqoop工作时,会将数据传输任务分解成多个小任务,这些小任务会并行执行,以提高整体的数据迁移速度。它通过一个称为“MapReduce”的框架来实现这一过程,MapReduce允许Sqoop在Hadoop集群的多个节点上运行任务。

当Sqoop从关系数据库导出数据时,它会创建一个MapReduce任务,并且该任务的每个Mapper会从数据库中读取一部分数据。读取完成后,Mapper将数据写入到HDFS中。相反的过程发生在数据导入场景中:Sqoop会读取HDFS中的数据,并将每条记录写入到关系数据库的表中。

Sqoop还能够自动处理数据类型转换问题,以及并发控制和错误恢复机制,使得整个数据迁移过程既稳定又可靠。

## 2.2 Sqoop的高级特性

### 2.2.1 数据导入和导出优化

Sqoop提供了多种参数来优化数据导入导出过程,包括但不限于批处理大小、并发任务数、数据分区等。

批处理大小(`--batch`)和并发任务数(`-m` 或 `--num-mappers`)是影响数据迁移效率的重要参数。通过合理设置这些参数,可以显著提高数据迁移的速率。

Sqoop还允许用户通过分区参数(`--split-by`)来启用Map端的切片,允许数据被均匀地分配到各个Mapper任务中,进一步提高了并行处理的能力。

### 2.2.2 Sqoop与Hadoop生态系统的集成

Sqoop与Hadoop生态系统中的其他组件如Hive和HBase的集成,使得它不仅仅局限于简单的数据迁移,还可以扩展到更复杂的数据处理场景中。

例如,数据可以被导入到Hive表中进行更高级的数据分析和查询。而HBase作为一个NoSQL数据库,可以用于存储那些需要快速读写的大量数据。通过Sqoop,可以非常方便地在这些组件之间转移数据,为处理大规模数据集提供灵活性。

接下来的章节,我们会探讨如何利用Sqoop的这些高级特性,解决实际应用中的数据导入导出优化问题,并通过案例分析来展示Sqoop与Hadoop生态系统的集成效果。

# 3. Spark框架的理论与实践

## 3.1 Spark核心概念

### 3.1.1 Spark架构简述

Apache Spark是一种强大的大数据处理框架,其核心架构由以下几个主要组件构成:

- **Driver Program**: Spark应用程序的入口点,负责创建SparkContext并执行用户程序。它运行用户的main()函数并创建SparkContext。

- **Cluster Manager**: 管理集群资源,支持Standalone模式、YARN、Mesos等。它负责接收Driver Program的资源请求并分配资源。

- **Worker Node**: 集群中的节点,运行计算任务和存储数据。每个节点上运行一个Executor,它负责执行任务并返回结果给Driver Program。

- **Executor**: 为应用程序提供执行环境,执行任务,并通过Block Manager进行内存和磁盘存储。

Spark通过这些组件协同工作,支持大数据处理的各种操作,包括数据读取、转换、分析、输出等。

### 3.1.2 RDD与数据流处理

弹性分布式数据集(RDD)是Spark的核心抽象,它代表了一个不可变、分布式的数据集合。RDD有以下特点:

- **不可变性**: 一旦创建,无法被改变。

- **分区**: 数据分布在不同节点上进行并行处理。

- **可容错性**: 如果某个节点上的RDD分区丢失,可以通过依赖关系重新计算。

RDD支持两种类型的操作:transformation(转换)和action(行动)。转换操作用于创建新的RDD,而行动操作则触发

0

0