【Sqoop功能拓展】:自定义插件开发,高级技巧揭秘

发布时间: 2024-10-26 03:58:05 阅读量: 36 订阅数: 29

# 1. Sqoop简介与基本使用

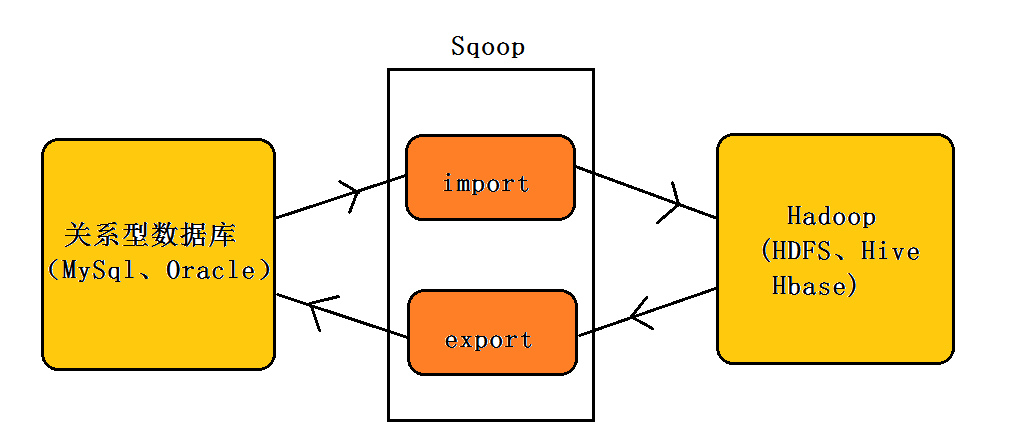

## 1.1 数据导入导出工具Sqoop

Sqoop是一个开源工具,用于在Hadoop与传统的数据库服务器之间高效传输大数据。它能够将关系型数据库中的表数据导入到Hadoop的HDFS中,或将数据从HDFS中导出到外部数据库系统。

## 1.2 Sqoop基本使用

Sqoop的基本使用包括连接数据库、导入数据到HDFS、导出数据到关系型数据库。通过命令行界面执行以下步骤可以完成基本的数据迁移任务:

1. **配置数据库连接**:首先需要配置数据库连接参数,如主机名、端口、数据库名和用户凭证。

2. **导入操作**:使用`import`命令将表数据导入到HDFS,可选指定分隔符、字段、表列等。

3. **导出操作**:使用`export`命令将数据从HDFS导出到数据库表中,支持更新、删除等操作。

例如,从MySQL数据库导入数据到HDFS的命令如下:

```bash

sqoop import \

--connect jdbc:mysql://<database_host>:<port>/<database_name> \

--username <username> \

--password <password> \

--table <table_name> \

--target-dir <hdfs_directory> \

--num-mappers 1

```

在这一章中,我们简单介绍了Sqoop是什么以及如何进行基本的数据导入和导出操作,为后面的章节奠定了基础,涉及了Sqoop操作的入门知识。随着我们深入了解,将会探索到更多高级功能和个性化定制的插件开发技巧。

# 2. Sqoop的架构与工作原理

### Sqoop架构深度解析

Sqoop的架构设计得非常巧妙,它能够有效地在Hadoop和外部数据存储系统之间传输数据。 Sqoop的核心是一个独立的Java程序,它使用MapReduce的机制来进行大规模并行数据导入和导出。Sqoop能够与关系型数据库管理系统(RDBMS)无缝交互,比如MySQL、Oracle和PostgreSQL等,以及其他数据存储系统,比如HBase和MongoDB。

下面让我们通过几个关键组件来深入理解Sqoop的架构:

#### 2.1.1 Sqoop客户端

Sqoop客户端是用户与Sqoop交互的界面,它提供了命令行界面(CLI)和Java API。用户通过客户端提交数据导入导出任务,这些任务会被翻译成相应的MapReduce任务,再由Hadoop集群执行。

#### 2.1.2 Sqoop服务器

Sqoop服务器为管理服务,其负责接收客户端的任务请求,调度任务执行,并监控任务状态。它允许用户远程提交Sqoop作业,并可以集成到其他工作流管理工具中。

#### 2.1.3 数据传输模块

这是Sqoop的核心,负责管理数据从RDBMS到Hadoop(或反之)的传输。它使用连接器(connectors)与外部系统通讯,这些连接器是可插拔的,允许Sqoop与多种数据源交互。

### Sqoop工作原理详解

理解Sqoop的工作原理首先要了解它处理数据导入导出的过程。Sqoop采用MapReduce框架来实现数据的并行处理,这确保了它能够处理大量数据。

#### 2.2.1 数据导入过程

在数据导入过程中,Sqoop通过以下步骤将数据从RDBMS导入到Hadoop中:

1. 用户通过Sqoop客户端提交导入命令。

2. 客户端将命令转换成MapReduce作业并提交给Hadoop集群。

3. Hadoop的MapReduce框架会启动多个Map任务,并行地从RDBMS中读取数据。

4. 数据通过网络传输到HDFS,并被写入到相应的目录中。

#### 2.2.2 数据导出过程

数据导出过程是导入过程的逆过程:

1. 用户发起导出命令,指定要从HDFS导出的数据和目标RDBMS。

2. 客户端将命令转换为MapReduce作业,并提交给Hadoop集群。

3. MapReduce作业的Map任务从HDFS读取数据,并通过Sqoop的数据传输模块发送到RDBMS。

4. 数据被逐条或批量插入到目标数据库中。

###Sqoop的工作原理和架构的实用化

#### 实践:在Linux环境下安装Sqoop

在开始使用Sqoop之前,首先需要完成安装。以下是在Linux环境下安装Sqoop的步骤:

1. 下载Sqoop的安装包。

2. 解压安装包到指定目录。

3. 配置环境变量,主要添加Sqoop的`bin`目录到`PATH`环境变量中,以便可以在任何位置使用`sqoop`命令。

```bash

export SQOOP_HOME=/path/to/sqoop

export PATH=$PATH:$SQOOP_HOME/bin

```

4. 验证Sqoop安装是否成功,通过运行`sqoop --version`来检查。

#### 深入理解:Sqoop的数据传输机制

Sqoop的数据传输机制是它能够高效工作的核心。它依赖于可插拔的连接器系统,允许用户自定义数据传输逻辑。我们可以看到,Sqoop将外部数据源抽象成一系列的数据库表,然后通过MapReduce框架并行处理这些表。

### 总结

通过本章的介绍,我们了解了Sqoop的架构和工作原理。从架构的角度,我们解析了Sqoop客户端、服务器和数据传输模块。从工作原理的角度,我们深入理解了数据的导入和导出过程。最后,我们通过实践安装Sqoop和理解其数据传输机制,进一步巩固了知识点。

在下一章节,我们将继续深入,探讨如何进行Sqoop的自定义插件开发。这将包括环境搭建、插件类型概览、以及创建简单的自定义插件实例。

# 3. 自定义插件开发基础

## 3.1 插件开发环境搭建

### 3.1.1 安装和配置Java开发环境

为了进行Sqoop自定义插件的开发,首先需要搭建一个合适的开发环境。Java是编写Sqoop插件的主要语言,因此,我们需要安装一个稳定的Java开发环境。

- **下载并安装JDK**: 访问Oracle官网或其他JDK提供商,下载适合你操作系统的Java开发工具包(JDK)。例如,如果你正在使用Linux系统,你可以通过包管理器安装OpenJDK。

- **设置JAVA_HOME环境变量**: 确保在系统的环境变量中设置JAVA_HOME,使其指向JDK的安装目录。这是因为Sqoop及其他Java工具依赖于这个环境变量来找到Java的执行环境。

- **配置CLASSPATH环境变量**: CLASSPATH环境变量是Java运行时用来查找类文件的路径。通常,它应该包含JDK的lib目录。

- **验证Java环境**: 通过打开终端(或命令行窗口)并运行`java -version`和`javac -version`命令来验证Java是否正确安装。

### 3.1.2 Sqoop源码获取与构建

为了开发自定义插件,我们可能需要修改Sqoop的源码或深入理解其工作原理。

- **克隆Sqoop仓库**: 使用Git工具从Apache的代码仓库中克隆Sqoop的源代码。可以通过执行`git clone ***`来完成。

- **构建Sqoop源码**: 在克隆的目录下,通常会有一个构建脚本。对于Sqoop,这个脚本通常是`build.sh`(在Unix-like系统上)或`build.bat`(在Windows系统上)。运行此脚本将下载所有依赖项并编译源代码。根据系统和网络速度的不同,这一过程可能需要一些时间。

- **安装构建的Sqoop**: 编译完成后,可以通过运行`ant install`来安装构建的Sqoop到本地Maven仓库,这将使得你在本地安装和测试自定义插件成为可能。

## 3.2 插件开发入门

### 3.2.1 Sqoop插件类型概览

Sqoop允许用户通过插件扩展其功能,根据功能不同,插件可以分为不同类型:

- **Import插件**: 用于将外部数据导入到Hadoop的HDFS中。

- **Export插件**: 用于将数据从HDFS导出到外部系统。

- **Codegen插件**: 用于生成访问外部数据库的Java代码。

- **ConnectionManager插件**: 用于管理与外部系统之间的连接。

了解这些类型有助于我们根据需求选择或开发相应的插件。

### 3.2.2 创建一个简单的自定义插件实例

以下是一个创建一个简单的Export插件的示例。

- **创建插件的Java类**: 创建一个实现`ExportJob`接口的Java类,例如`SimpleExportPlugi

0

0