解决ChatGPT爬取中文网页乱码问题:编码一致性关键

需积分: 0 21 浏览量

更新于2024-08-04

收藏 341KB DOCX 举报

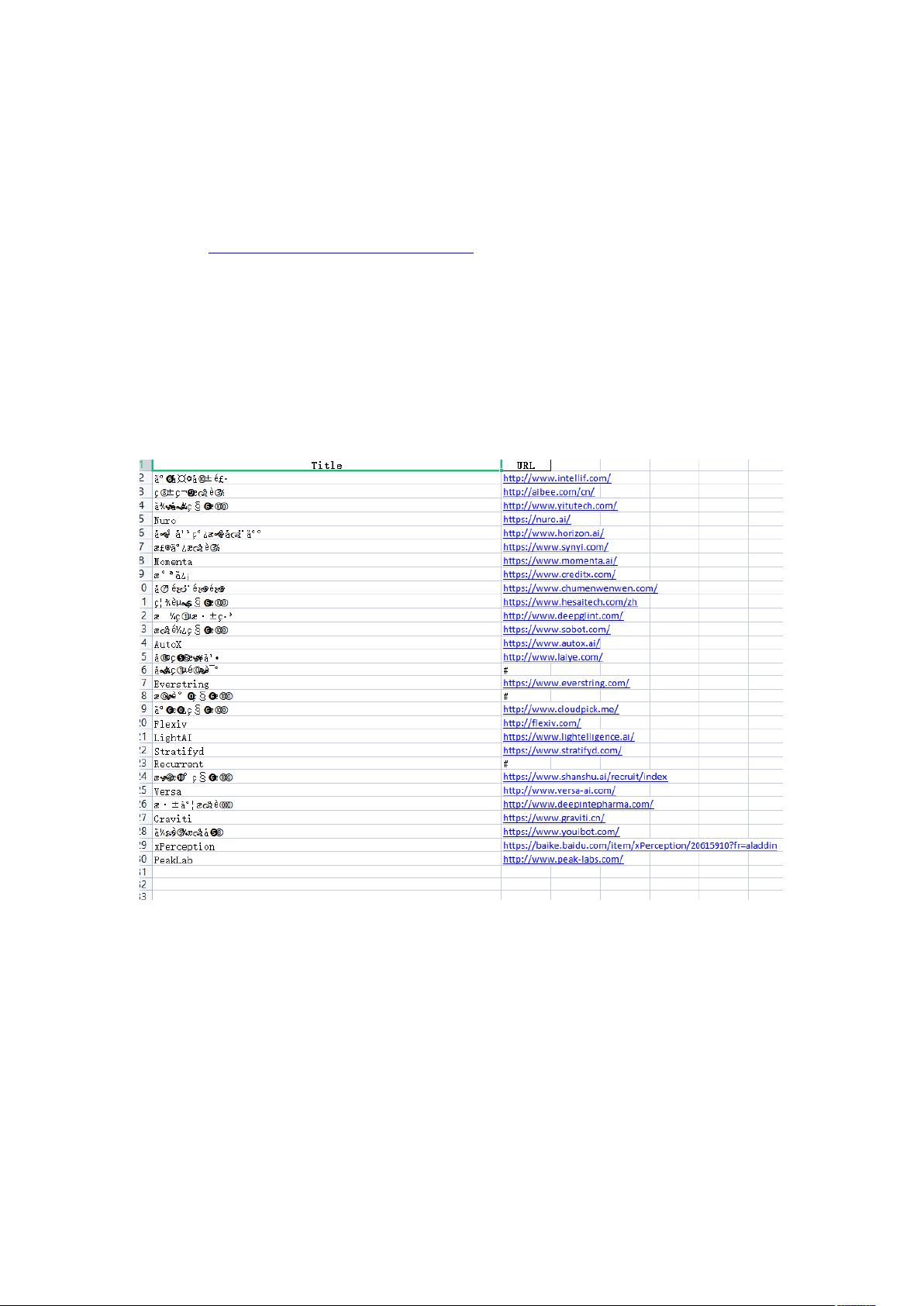

在零代码编程的世界里,利用ChatGPT编写爬虫程序来抓取网页数据是一项常见的任务。然而,在处理中文网站时,可能会遇到编码问题。在尝试使用ChatGPT编写的Python程序爬取https://www.zhenfund.com/Case/?id=3 的页面数据时,遇到了中文字符的乱码问题。程序原本能够正确解析网页,定位到id="ma_3"下的div元素,以及其中的li元素、img元素的alt值和a元素的href值,但在将数据保存至Excel时,由于编码不匹配,出现了乱码。

在遇到这类问题时,首先要理解的是网页的编码格式通常为UTF-8,这是互联网上最常用的字符集,确保了中文字符的正确显示。当系统的默认编码与网页的编码格式相同时,无需显式指定编码,爬取过程能顺利进行。但在这个例子中,尽管爬虫本身没有问题,但在将CSV文件导入Excel时出现乱码,原因在于源文件(即抓取的数据)的编码和Excel读取时的默认编码不一致。

解决这个问题的关键在于设置正确的编码。ChatGPT提供的解决方案是在代码中添加`r.encoding = r.apparent_encoding`,这允许程序自动检测并识别目标文件的编码格式,从而避免手动匹配每种可能的编码。通过这种方法,ChatGPT指导的修改使得程序能够正确识别并处理网页的UTF-8编码,从而解决了乱码问题。

总结起来,零代码编程中遇到中文乱码问题,主要涉及编码一致性问题。理解目标网页的编码,正确设置数据读取和写入时的编码格式,是解决这类问题的关键。ChatGPT在提供基础代码框架的同时,也能引导用户通过适当的编码调整来优化程序,使其适应不同编码环境。对于零代码用户来说,这提示我们在使用类似工具时,不仅要注意代码的生成,还要了解其背后的原理,以便灵活应对可能出现的问题。

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

2023-05-15 上传

2023-11-24 上传

2023-10-17 上传

2023-10-16 上传

2024-09-30 上传

AIGCTribe

- 粉丝: 2345

- 资源: 22

最新资源

- CS330:对比图形和可视化

- 西门子PLC工程实例源码第526期:用S7-214定位控制具有位置监测和校正.rar

- xenoblade2-data

- Tajam2:使用CodeSandbox创建

- checkmk-pagespeed-plugin:特工检查页面速度得分

- 优克着火了-项目开发

- 制作超低功耗ESP8266 IoT项目植物护理设备,无需编码-电路方案

- js_invert-color

- Repetitio:iOS 应用程序——学习词汇,永远不会忘记

- nutzwx:微信(weixin) IN Nutz

- 电影ang刷新

- Insteon网关-项目开发

- progress-tracking-formalization:经过验证的进度跟踪,可及时进行数据流

- arrays-to-object:将嵌套数组转换为对象

- 西门子PLC工程实例源码第524期:用PT100电阻温度传感器测量温度并监视温度.rar

- axiom:用于Salesforce.com的单点登录解决方案的学习,测试和故障排除工具