信息论基础:哈工大贾世楼研究生课程讲义解析

需积分: 16 61 浏览量

更新于2024-08-02

收藏 312KB DOC 举报

"哈尔滨工业大学贾世楼教授的信息论研究生课程讲义,主要探讨了第二章中的平均交互信息量I(X,Y)的相关特性。"

在信息论中,平均交互信息量I(X,Y)是一个核心概念,它衡量的是信源X与信宿Y之间的信息关联程度。在统计平均的意义下,它描述了信源、信道和信宿组成的通信系统的信息传输效率。I(X,Y)的非负性是一个重要的性质,表明在任何情况下,信源与信宿之间至少存在正向的信息传递。

平均交互信息量I(X,Y)的非负性可以通过对数的上凸性来证明。如果f(x)是一个上凸函数,如f(x)=logx,那么对于概率分布π,有f(∑πixi)≥∑πif(xi)。应用这个性质到I(X,Y),我们可以推导出I(X,Y)≥0。只有当X和Y完全独立,即P(X,Y)=P(X)P(Y),平均交互信息量I(X,Y)才会等于零。这意味着,接收者在收到Y的符号时,总能从Y中获取关于X的信息,除非X和Y完全独立。

平均交互信息量的另一个关键特性是它的互易性,即I(X,Y)=I(Y,X)。这表示Y中关于X的信息量与X中关于Y的信息量是相等的。这种互易性反映了信息传递的双向性,尽管观察角度可能不同,但从X到Y和从Y到X的信息量是等价的。通过信息熵的差异,可以表示为I(X,Y)=H(X)-H(X/Y)=H(Y)-H(Y/X),其中H(X/Y)和H(Y/X)分别是条件熵,表示在已知Y的情况下X的熵和在已知X的情况下Y的熵。

此外,当X和Y独立时,联合熵H(X,Y)等于它们各自的熵之和,即H(X,Y)=H(X)+H(Y),同时条件熵H(X/Y)=H(X)且H(Y/X)=H(Y),这意味着在没有相互依赖的情况下,从一方获取的信息不会增加另一方的不确定性。

在信息传输过程中,后验熵H(X/Y)总是小于或等于先验熵H(X),这是后熵不增加原理,确保信息处理不会凭空增加信息。同样,H(Y/X)≤H(Y)也反映了这一原则。这些原理是信息理论中的基本定律,对理解和优化通信系统的性能至关重要。

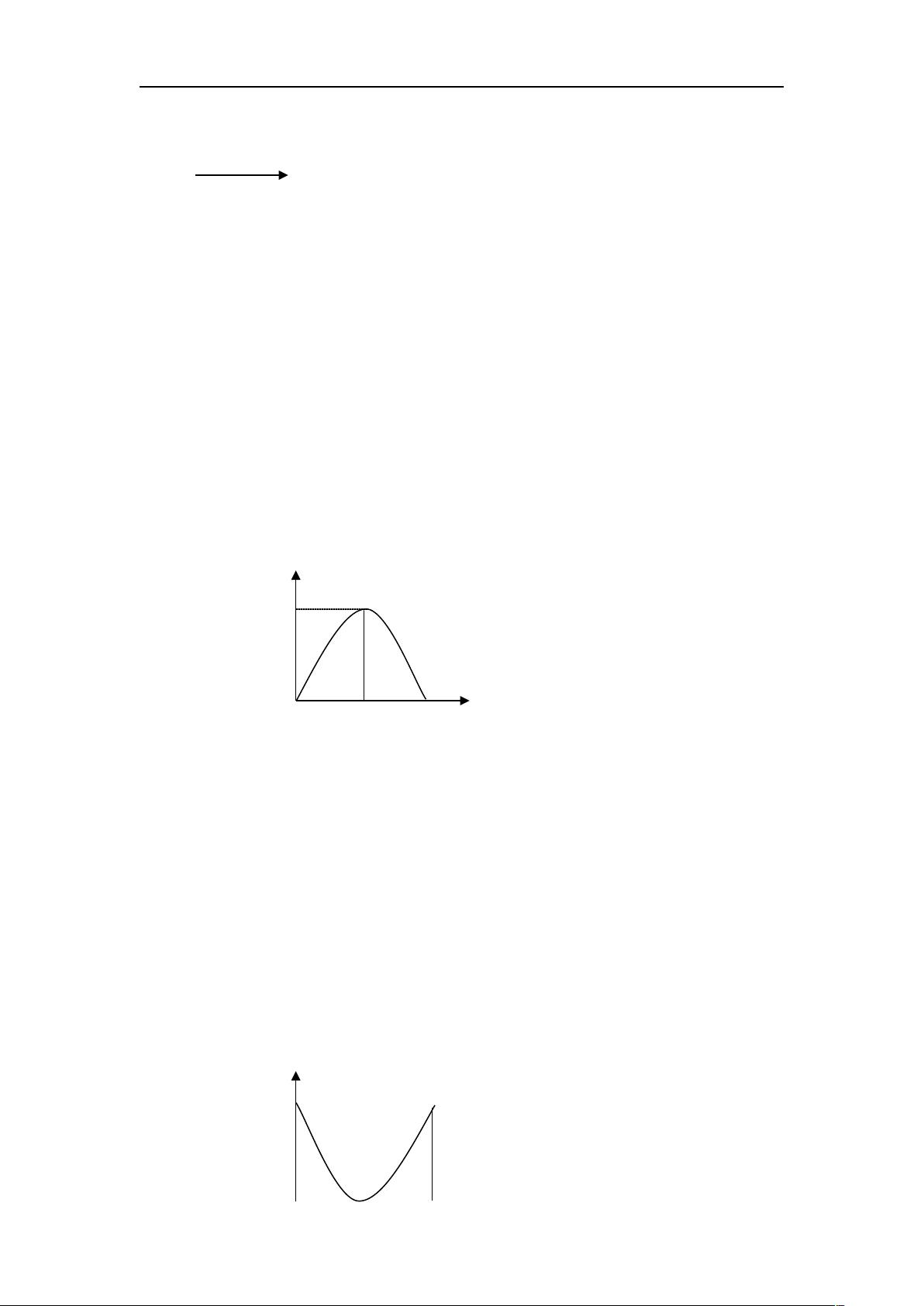

图示部分可能展示了I(X,Y)如何作为两个随机变量分布的重叠部分,直观地解释了X和Y之间的信息共享程度。平均交互信息量I(X,Y)就是这种共享信息的量化度量。

哈尔滨工业大学的这份信息论课程讲义深入探讨了平均交互信息量的非负性、互易性和其在通信系统中的实际意义,这些都是理解和应用信息理论不可或缺的基础知识。

135 浏览量

186 浏览量

114 浏览量

2010-09-25 上传

898 浏览量

186 浏览量

chen_lovelotus

- 粉丝: 1

最新资源

- 掌握PerfView:高效配置.NET程序性能数据

- SQL2000与Delphi结合的超市管理系统设计

- 冲压模具设计的高效拉伸计算器软件介绍

- jQuery文字图片滚动插件:单行多行及按钮控制

- 最新C++参考手册:包含C++11标准新增内容

- 实现Android嵌套倒计时及活动启动教程

- TMS320F2837xD DSP技术手册详解

- 嵌入式系统实验入门:掌握VxWorks及通信程序设计

- Magento支付宝接口使用教程

- GOIT MARKUP HW-06 项目文件综述

- 全面掌握JBossESB组件与配置教程

- 古风水墨风艾灸养生响应式网站模板

- 讯飞SDK中的音频增益调整方法与实践

- 银联加密解密工具集 - Des算法与Bitmap查看器

- 全面解读OA系统源码中的权限管理与人员管理技术

- PHP HTTP扩展1.7.0版本发布,支持PHP5.3环境