决策树原理详解:ID3算法与局限性

需积分: 0 105 浏览量

更新于2024-08-05

收藏 3.74MB PDF 举报

"决策树原理更新1"

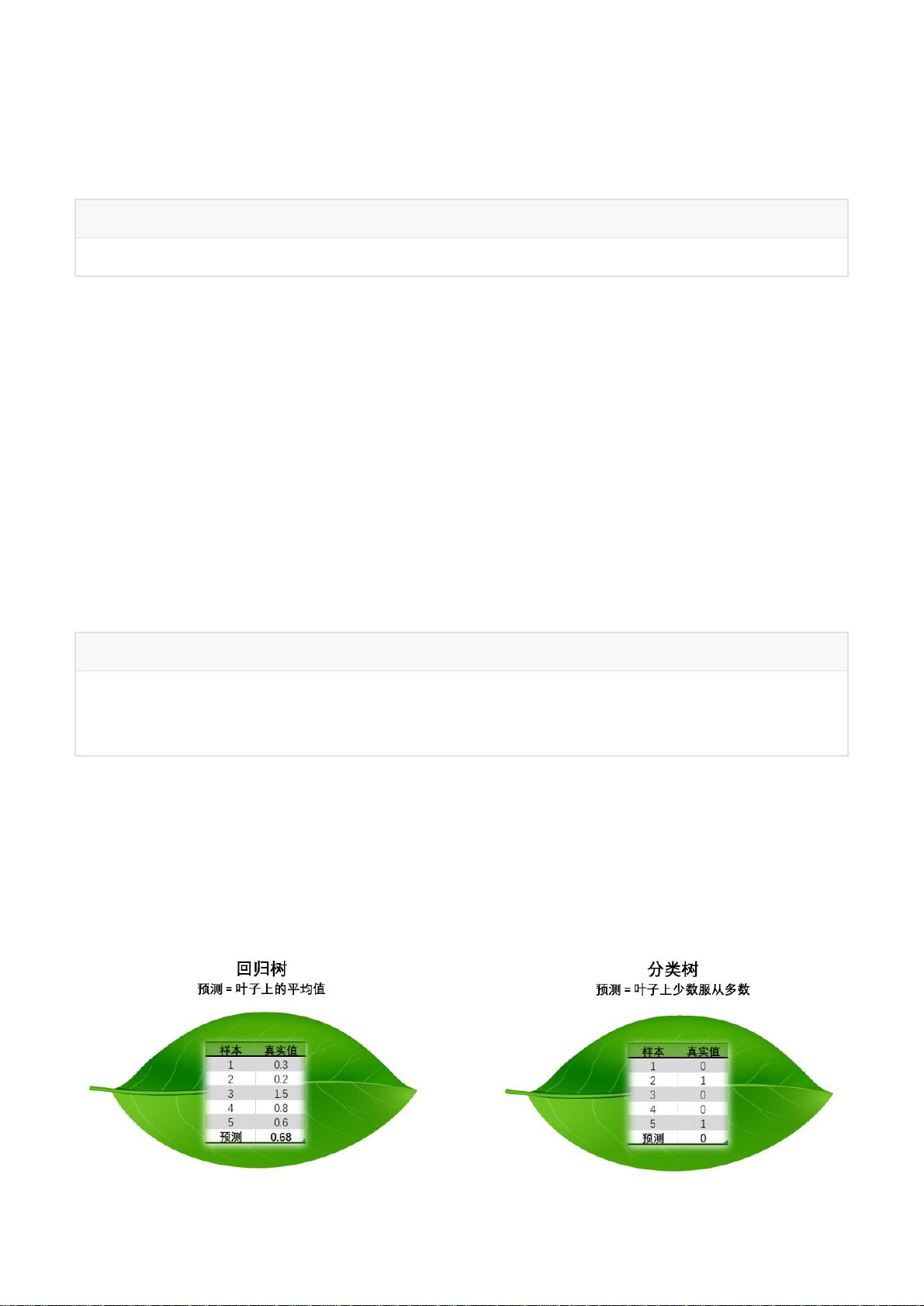

决策树是一种在机器学习中广泛应用的有监督学习算法,主要用于分类和回归任务。其工作原理基于一系列特征的测试,通过构建一个树形结构来表示不同特征值与最终类别之间的关系。在决策树中,每个内部节点代表一个特征,每个分支代表该特征的一个可能值,而叶节点则对应类别决策。

1.1 决策树是如何工作的

决策树算法首先从整个数据集开始,通过选择最优特征来划分数据,形成树的根节点。接着,算法会递归地对子数据集进行同样的特征选择过程,直到满足停止条件(如达到预设的最大深度、最小样本数或信息增益阈值等)。在决策过程中,算法会尝试找到使数据集纯度(例如,Gini指数、熵或信息增益)最大化的特征,以达到局部最优的分类效果。

1.2 构建决策树

1.2.1 ID3算法

ID3(Iterative Dichotomiser 3)是最早的决策树算法之一,它使用信息增益作为特征选择的标准。然而,ID3算法存在局限性,比如对连续特征的处理不足,且容易受离群值影响,还可能导致过拟合。

1.2.2 简单实例

在构建决策树的过程中,通常会遇到一个简单的例子:根据动物的特征(如是否哺乳、是否有鳞片等)来分类动物。ID3算法会根据信息增益选择最佳特征,然后根据该特征的各个值创建分支,直到所有数据被正确分类。

1.2.3 ID3的局限性

ID3算法对于连续变量处理不理想,且容易偏向于选择具有更多取值的特征,这可能导致树结构过于复杂。此外,如果所有特征都是连续的,或者数据集中存在缺失值,ID3就无法正常工作。

1.3 C4.5算法 & CART算法

为了克服ID3的局限性,出现了C4.5和CART(Classification and Regression Trees)算法。C4.5引入了信息增益比,解决了ID3对多值特征的偏好问题,并能处理连续变量。CART则用于同时处理分类和回归问题,采用基尼不纯度或Gini指数作为分裂标准,并支持二元切分。

1.3.1 修改局部最优化条件

C4.5和CART算法在构建决策树时,不再单纯追求局部最优,而是考虑全局最优。它们通过设定剪枝策略,如预剪枝和后剪枝,防止决策树过深导致过拟合。

1.3.2 连续变量处理手段

C4.5和CART算法对连续变量的处理方式是将连续范围划分为多个区间,每个区间作为一个新的特征值,然后进行特征选择和树的构建。

决策树的生长过程涉及许多策略和调整,如特征选择方法、剪枝策略、停止条件等。这些策略直接影响决策树的准确性和泛化能力。在实际应用中,决策树常与其他技术(如随机森林、AdaBoost)结合,以提高模型性能并减少过拟合的风险。通过理解和掌握决策树的基本原理,我们可以更好地利用这一强大工具解决各种实际问题。

125 浏览量

2018-08-16 上传

2018-08-20 上传

2023-05-21 上传

2023-06-08 上传

2024-01-04 上传

2023-06-10 上传

2023-11-01 上传

2023-05-30 上传

嗨了伐得了

- 粉丝: 21

- 资源: 290

最新资源

- 解决Eclipse配置与导入Java工程常见问题

- 真空发生器:工作原理与抽吸性能分析

- 爱立信RBS6201开站流程详解

- 电脑开机声音解析:故障诊断指南

- JAVA实现贪吃蛇游戏

- 模糊神经网络实现与自学习能力探索

- PID型模糊神经网络控制器设计与学习算法

- 模糊神经网络在自适应PID控制器中的应用

- C++实现的学生成绩管理系统设计

- 802.1D STP 实现与优化:二层交换机中的生成树协议

- 解决Windows无法完成SD卡格式化的九种方法

- 软件测试方法:Beta与Alpha测试详解

- 软件测试周期详解:从需求分析到维护测试

- CMMI模型详解:软件企业能力提升的关键

- 移动Web开发框架选择:jQueryMobile、jQTouch、SenchaTouch对比

- Java程序设计试题与复习指南