大规模语言模型的缩放、涌现与推理

需积分: 5 138 浏览量

更新于2024-06-22

收藏 3.11MB PDF 举报

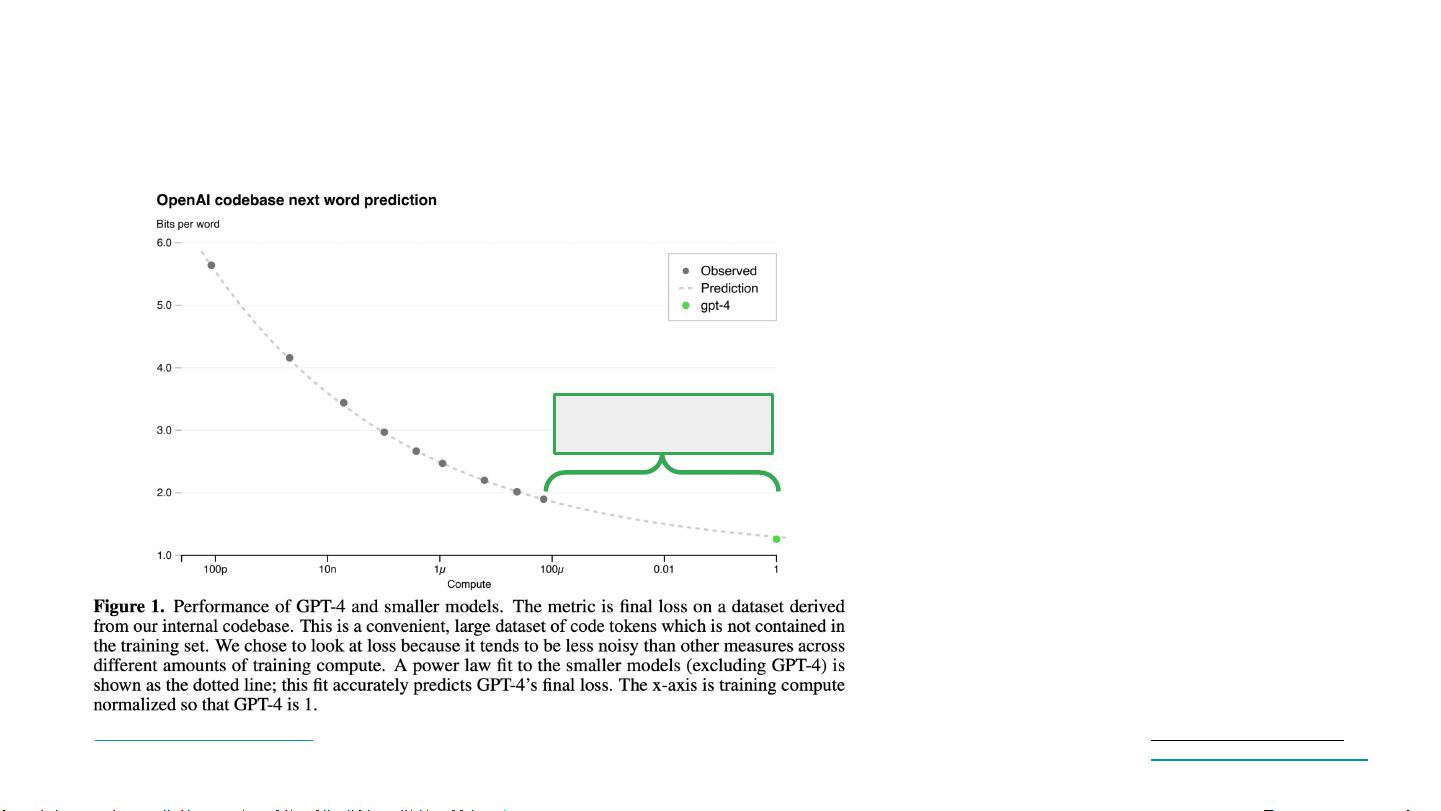

“Scaling, emergence, and reasoning (Jason Wei, Vandy).pdf 讨论了大型语言模型的扩展性、涌现能力和推理能力。作者 Jason Wei 分析了模型规模、训练数据量、计算资源与语言模型性能的关系,并探讨了模型如何通过预测下一个单词来学习,以及推理能力作为一种涌现能力的表现。”

正文:

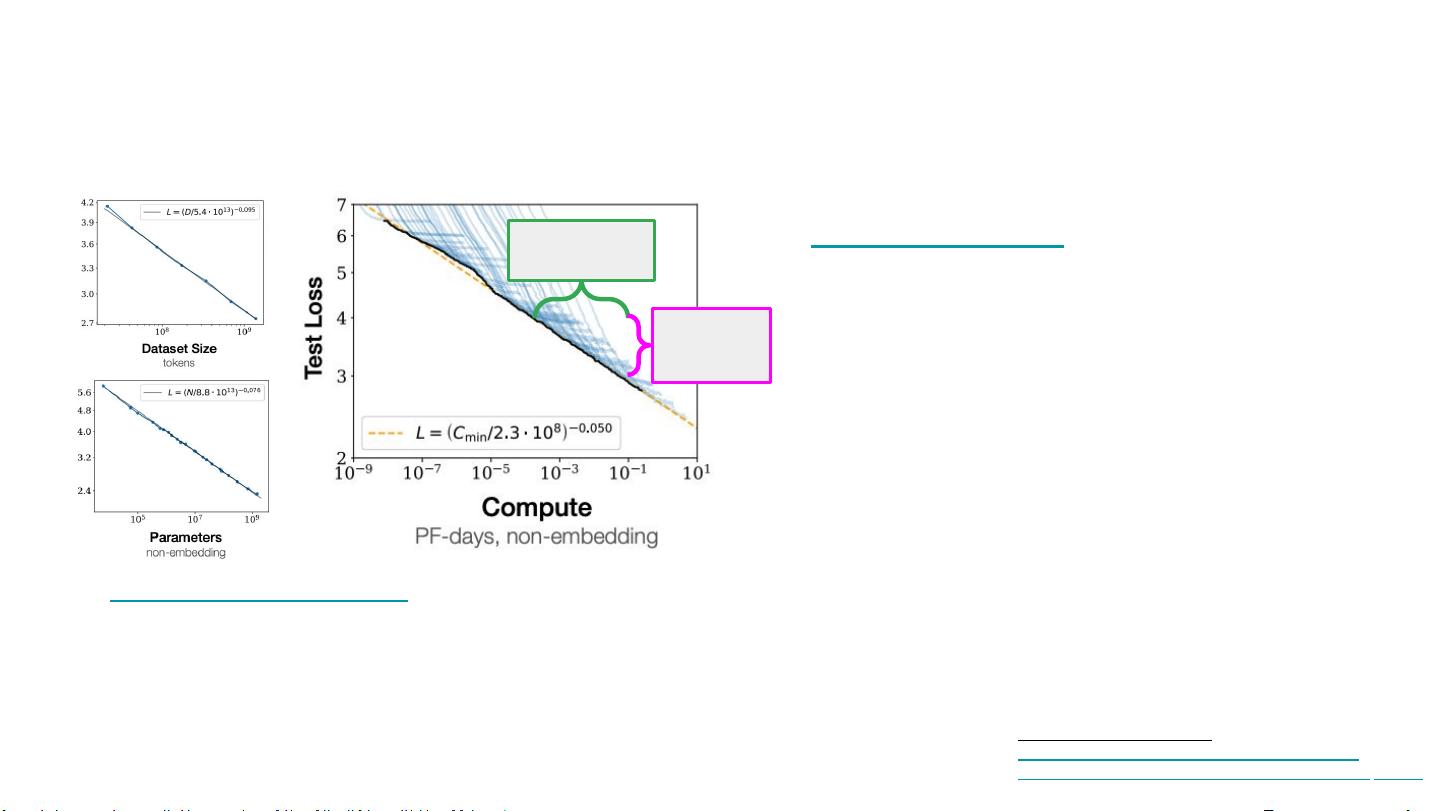

在现代人工智能领域,尤其是自然语言处理(NLP)中,大规模语言模型已经成为研究的焦点。这些模型的“扩展性”(Scaling)指的是随着模型参数数量、训练数据规模和计算资源的增加,模型性能的提升趋势。Jason Wei 的报告中,他详细阐述了这一概念,并讨论了扩展性的测量方法和挑战。

1. 扩展性(Scaling)及其测量:

- 模型规模:通常以模型的参数数量来衡量,例如 PaLM(2022)有5400亿个参数,而 GPT-3(2020)则有1750亿个参数。

- 训练数据:表示模型在训练过程中看到的令牌(tokens)数量,如 PaLM 使用了7800亿个令牌,而 BERT-base(2018)使用了2500亿个。

- 训练计算:通常用浮点运算次数(FLOPs)来度量,PaLM 的训练计算量达到了2.5e24 FLOPs,相比之下,BERT-base 的训练计算量为1.6e20 FLOPs。

2. 扩展性的挑战:

- 技术挑战:随着模型规模的增长,训练和优化变得极其复杂,需要大量的计算资源和高效的算法。

- 经济挑战:大规模模型的训练成本高昂,包括硬件投入和能源消耗。

- 环境影响:大规模计算可能对环境产生负面影响,如碳排放问题。

- 泛化和效率:更大的模型并不总是意味着更好的性能,可能存在过拟合或计算效率低下的问题。

3. 涌现能力(Emergent Abilities):

- 语言模型通过预测下一个单词来学习语言的结构和模式,这个过程可能会带来未预期的、在较小模型中未显现的能力。

- 涌现能力是指在模型规模扩大后,未明确训练却自然出现的新功能,如对话理解、文本生成和逻辑推理等。

- 例子包括:GPT-3展示了在无额外训练的情况下进行数学问题解答和代码编写的能力。

4. 推理能力(Reasoning)与提示(Prompting):

- 通过链式思维(Chain-of-thought prompting),模型可以逐步展示其解决问题的过程,这被视为一种涌现的推理能力。

- 推理能力的评估通常涉及模型能否理解和应用知识,进行逻辑分析,解决复杂任务。

- 多数投票技巧(Majority vote trick)是利用多个模型的输出结果来提高推理的准确性和稳定性。

Jason Wei 的报告深入探讨了这些关键主题,为理解大规模语言模型如何通过扩展性提升性能,以及如何在没有明确编程的情况下发展出高级能力提供了有价值的见解。这种研究对于推动AI的发展和优化具有重要意义,尤其是在寻求更智能、更可持续的解决方案方面。

2023-09-21 上传

2017-09-10 上传

2010-08-06 上传

2023-06-11 上传

2023-04-06 上传

2023-06-11 上传

2023-03-27 上传

2023-05-19 上传

2023-03-27 上传

车东-csdn

- 粉丝: 1035

- 资源: 139

最新资源

- Ex_Ui登陆界面-易语言

- 行业分类-设备装置-同步提取大豆油脂和浓缩蛋白的方法.zip

- Bibtool-开源

- alware:二进制行为检查器-syscall,net-traffic等

- CrownMonolithic:使用python后端重构初始的泥潭浏览器游戏

- -PERSONS-PORTFOLIO:PERSONS PORTFOLIO

- BibSite-开源

- redux-cool:建立Redux逻辑,而不会感到紧张

- 股票查询-易语言

- .xKeep

- 行业分类-设备装置-可调式套筒和可调式棘轮套筒扳钳.zip

- emilmassey.github.io:我的个人网页

- discord-mass-ban:用户或漫游器令牌可以使用不和谐的批量禁止工具,以完全清除具有所需权限的服务器

- Dsc

- RK3566和RK3568硬件参考设计指导

- CDMLLoader:用于设计设备Mod应用程序的标记语言