深度学习基础:神经网络与反向传播

需积分: 0 40 浏览量

更新于2024-08-05

收藏 1.01MB PDF 举报

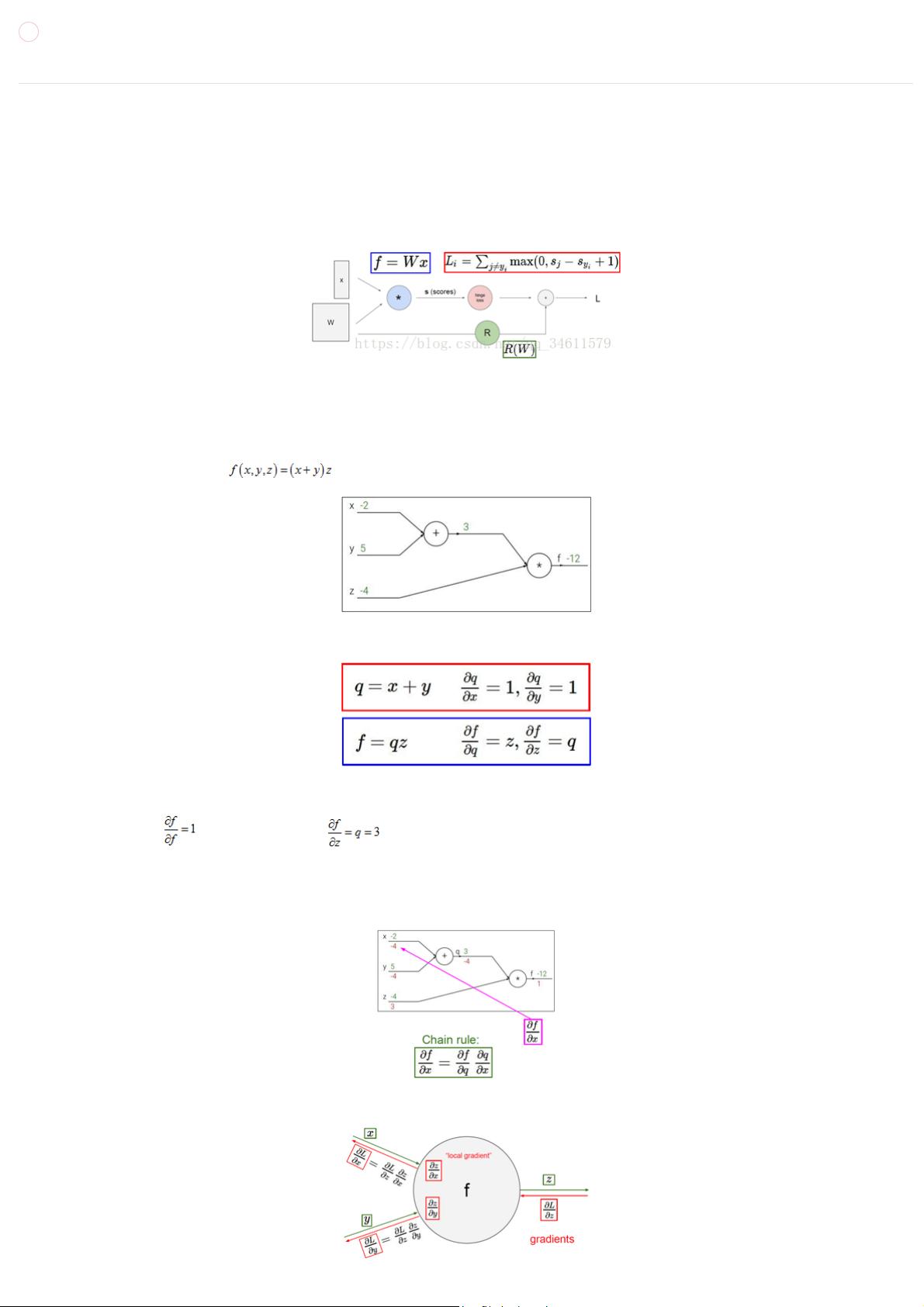

"神经网络1,讲解了反向传播在神经网络中的应用,通过计算图展示了反向传播如何计算复杂函数的梯度"

在神经网络的学习中,反向传播算法是一项核心的技术,它使得我们能够在庞大的神经网络模型中有效地计算梯度,进而更新网络权重以优化模型性能。在描述中提到,由于神经网络通常包含大量的参数,手动写出所有参数的梯度公式是不切实际的,这就需要反向传播算法来自动化这一过程。

反向传播的基本思想源于微积分中的链式法则,它允许我们通过对计算图的反向遍历来求解复杂的函数对各个变量的偏导数,即梯度。计算图是一种可视化工具,用来表示数学计算的过程,其中的节点代表计算步骤,边则表示这些步骤之间的依赖关系。

以一个简单的例子为例,假设我们有函数 f(x) = x * (w + q) * y - z,我们可以通过计算图进行前向传播,计算出最终的结果,然后再进行反向传播,计算每个变量的梯度。在反向传播过程中,从输出端开始,利用链式法则计算每个节点的梯度,如f的梯度、z的梯度、q的梯度等,直至计算出输入变量x的梯度。

在更复杂的情况下,如涉及到最大值运算的函数,反向传播仍然有效。例如,对于函数 g(w, z) = max(w, z),其计算图中,当w > z时,w的梯度为1,z的梯度为0;反之,当w < z时,w的梯度为0,z的梯度为1。这是因为最大值运算在梯度中体现了“选择”行为,只有选择的那个变量的梯度为1,另一个为0。同时,如果一个节点连接到多个后续节点,那么在反向传播时,来自不同路径的梯度会在该节点处相加。

反向传播在神经网络中的应用不仅仅是计算梯度,它还用于计算偏导数,这对于训练神经网络至关重要。在反向传播过程中,每个节点不仅计算自身的梯度,还会接收上游节点传递下来的梯度,然后乘以其本地梯度,将结果传递给与其相连的下游节点。通过这种方式,反向传播能够有效地处理具有大量非线性变换和并行结构的神经网络,使得我们能够在大规模的神经网络模型中实现高效的训练。

2019-05-02 上传

1003 浏览量

2021-10-04 上传

2022-08-04 上传

2022-08-04 上传

2023-01-04 上传

2019-08-13 上传

2021-09-07 上传

2023-02-08 上传

maXZero

- 粉丝: 29

- 资源: 303

最新资源

- 探索数据转换实验平台在设备装置中的应用

- 使用git-log-to-tikz.py将Git日志转换为TIKZ图形

- 小栗子源码2.9.3版本发布

- 使用Tinder-Hack-Client实现Tinder API交互

- Android Studio新模板:个性化Material Design导航抽屉

- React API分页模块:数据获取与页面管理

- C语言实现顺序表的动态分配方法

- 光催化分解水产氢固溶体催化剂制备技术揭秘

- VS2013环境下tinyxml库的32位与64位编译指南

- 网易云歌词情感分析系统实现与架构

- React应用展示GitHub用户详细信息及项目分析

- LayUI2.1.6帮助文档API功能详解

- 全栈开发实现的chatgpt应用可打包小程序/H5/App

- C++实现顺序表的动态内存分配技术

- Java制作水果格斗游戏:策略与随机性的结合

- 基于若依框架的后台管理系统开发实例解析