决策树与AdaBoost:集成学习的力量

需积分: 19 152 浏览量

更新于2024-07-18

1

收藏 358KB PPT 举报

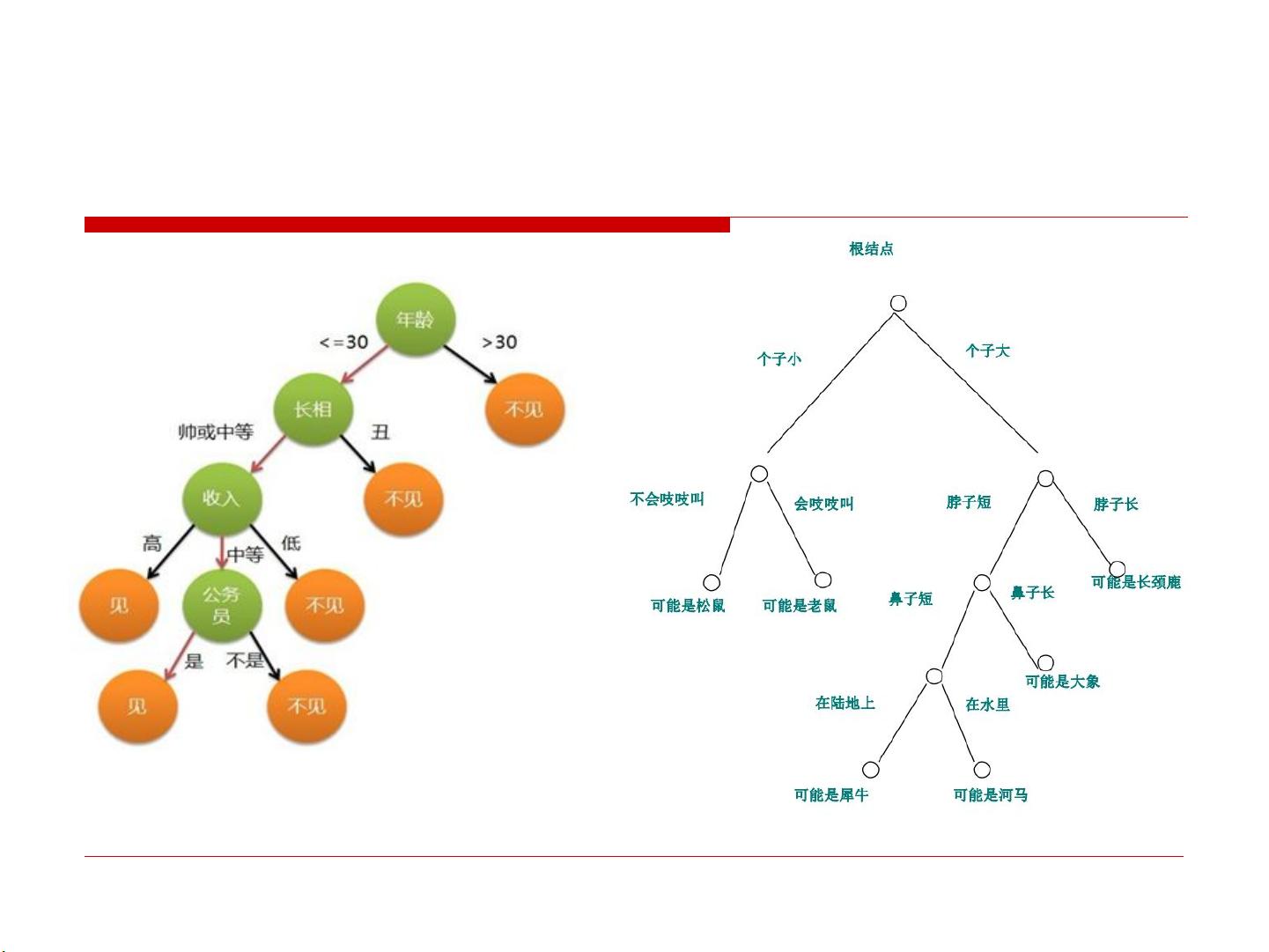

决策树与Adaboost是机器学习领域的重要组成部分,它们在构建高效预测模型方面起着关键作用。决策树是一种强大的归纳学习工具,通过树状结构表示数据的概念空间,能够处理不相关多概念的学习任务,因其易于理解和应用而在众多领域得到广泛应用。

Adaboost,全称Adaptive Boosting,是一种集成学习方法,尤其适用于将一系列性能相对简单的弱分类器组合成一个强大且准确的预测器。它通过自适应调整样本权重,重视那些先前分类错误的样本,以提高后续分类器的训练效果。在每一轮迭代中,新加入的弱分类器会针对加权后的数据进行训练,目标是减小整体预测误差。当达到预设的错误率阈值或达到最大迭代次数时,最终形成的强分类器能显著提高预测精度。

AdaBoost的核心算法包括以下几个步骤:

1. 初始化:所有样本具有相同的权重,弱分类器对所有样本进行分类。

2. 计算错误率:计算当前弱分类器的误分类样本权重。

3. 更新权重:错误分类的样本权重增加,正确分类的样本权重减小。

4. 训练新分类器:使用加权样本训练新的弱分类器。

5. 结合弱分类器:将所有弱分类器的预测结果加权求和,形成最终分类。

决策树学习算法如ID3、C4.5和CART是生成决策树的方法,它们通过自顶向下的递归过程,选择信息增益最大的属性来划分数据,直到达到纯度或达到预定的停止条件。信息增益是一个衡量特征对分类重要性的指标,通过比较特征引入前后的不确定度变化来确定最优分割点。

AdaBoost和决策树结合使用时,可以通过迭代方式,每次用调整过的样本集训练决策树,然后将每个决策树的预测结果作为投票,最终得出整体分类。这种集成方法有效地提高了预测的稳定性和准确性,尤其在面对复杂、非线性问题时,显示出强大的学习能力。

决策树和Adaboost是数据挖掘和机器学习中两个互补且实用的技术,它们的结合在实际应用中展现出了卓越的性能和广泛的价值。理解并掌握这两种技术,对于提升机器学习模型的性能和实用性至关重要。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-09-23 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

260 浏览量

alading2018

- 粉丝: 0

- 资源: 16

最新资源

- 《LINUX与UNIX SHELL编程指南》读书笔记

- DELL MD3000 软件安装配置

- 程序设计模式解说 - 追MM版

- ASP.NET中数据库的使用实训指导.pdf

- SELinux usage guide

- spring+hibernate+struts的配置整和

- ansys技巧全集(很好的ansys技巧 英文版) 很多书上都没有的技巧

- wavecom 模块常用AT指令手册.pdf

- HTTP协议中文版.pdf

- 汽车测距预警及险警系统结构与设计研究

- iReport使用手册

- 中国移动代理服务器(MAS)设备规范.doc

- 转发:嵌入式视频处理基本原理

- MS SQL全库导入oracle

- jbpm中文入门指南

- core java I 笔记