腾讯TDW计算引擎:深度解析Shuffle在MapReduce与Spark中的关键作用

32 浏览量

更新于2024-08-28

收藏 625KB PDF 举报

腾讯大数据之TDW计算引擎解析——Shuffle

腾讯分布式数据仓库(TDW)作为腾讯公司的重要离线数据处理平台,基于开源软件Hadoop和Hive构建,经过针对大规模数据和复杂计算场景的优化,已发展至大规模集群,日处理作业量庞大。为了适应多样化计算需求,TDW正朝着实时化方向演进,提供高效、稳定的服务。

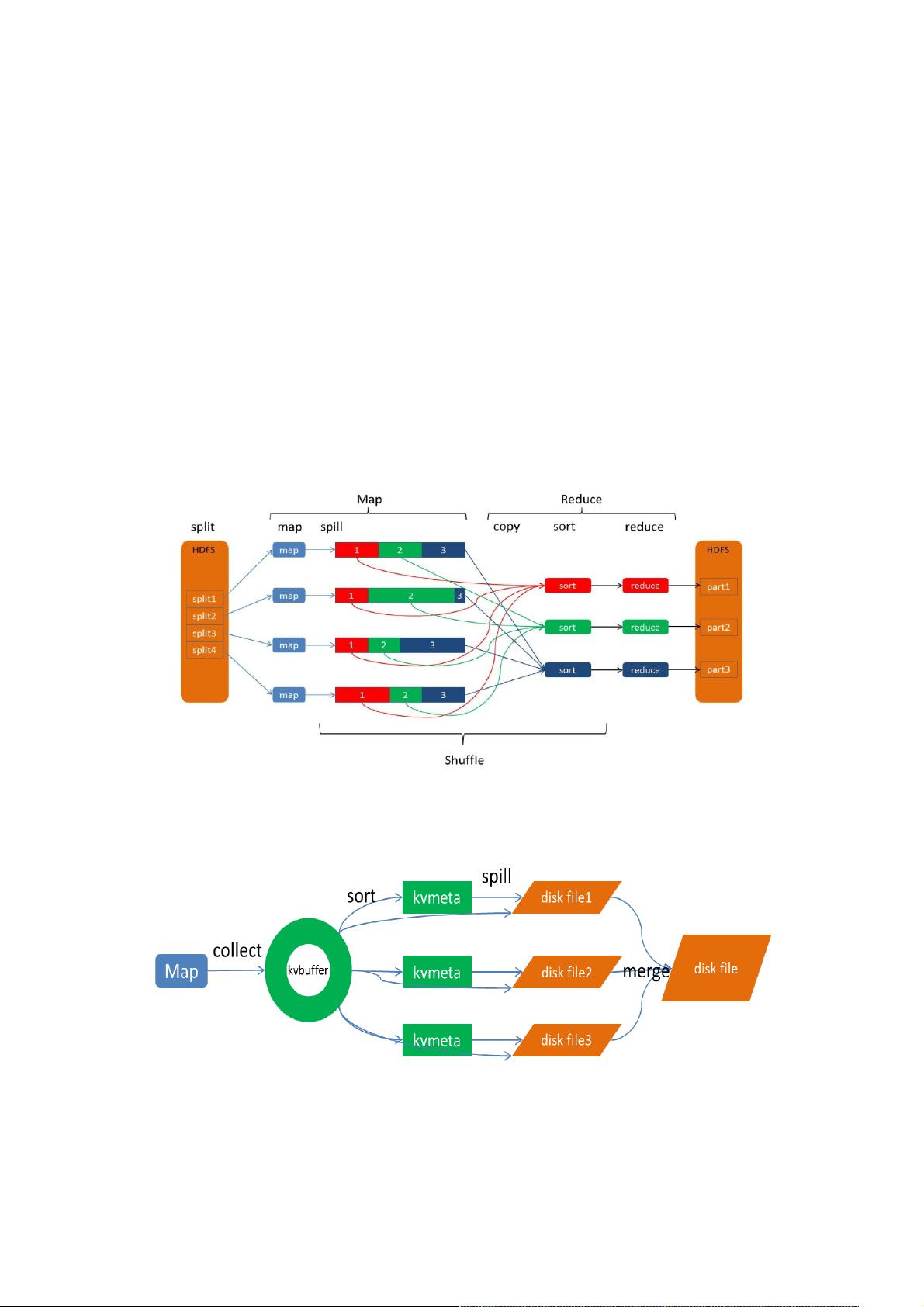

TDW的计算引擎分为MapReduce和Spark两个部分,核心组件之一就是Shuffle,它是这两个引擎中的关键数据传输和重组操作。Shuffle的过程可以理解为将数据从无规则分布转变为有序分组,这对于MapReduce的两个主要阶段——Map和Reduce至关重要。Map阶段处理原始数据,生成中间结果,而Reduce阶段则需要这些有序的中间结果进行聚合计算。

在MapReduce中,Shuffle涉及以下几个步骤:

1. **Spill过程**:当内存不足以存储所有中间结果时,Map任务会将数据写入磁盘,即Spill,包括排序、溢写和合并操作,确保数据有序性。

2. **Collect**:Map任务不断收集<key,value>对,并放入内存中的环形数据结构Kvbuffer,同时存储索引数据(Kvmeta)以支持快速查找。

Spark引擎同样包含Shuffle,但其性能优化显著,尤其是在实时计算场景中。与MapReduce相比,Spark的Shuffle通常更为高效,因为它使用内存计算和局部性原理,减少了磁盘I/O,从而提升了整体计算速度。

对TDW来说,深入理解Shuffle并优化这一过程至关重要。通过对比MapReduce和Spark的Shuffle机制,可以挖掘出更高效的执行策略,降低延迟,提升资源利用率。未来,随着技术的发展,TDW将继续优化Shuffle,可能采用新的内存管理技术、数据分区策略或分布式计算架构,以实现更卓越的性能和扩展性。

Shuffle是TDW计算引擎中不可或缺的核心技术,它对于处理大规模数据、保证计算效率和优化资源分配起着决定性作用。深入研究和优化Shuffle是推动TDW进一步提升性能和服务质量的关键。

2018-07-19 上传

2016-08-15 上传

点击了解资源详情

点击了解资源详情

2016-05-14 上传

2022-11-11 上传

2022-11-11 上传

140 浏览量

2014-05-29 上传

weixin_38727087

- 粉丝: 6

- 资源: 965

最新资源

- MATLAB实现小波阈值去噪:Visushrink硬软算法对比

- 易语言实现画板图像缩放功能教程

- 大模型推荐系统: 优化算法与模型压缩技术

- Stancy: 静态文件驱动的简单RESTful API与前端框架集成

- 掌握Java全文搜索:深入Apache Lucene开源系统

- 19计应19田超的Python7-1试题整理

- 易语言实现多线程网络时间同步源码解析

- 人工智能大模型学习与实践指南

- 掌握Markdown:从基础到高级技巧解析

- JS-PizzaStore: JS应用程序模拟披萨递送服务

- CAMV开源XML编辑器:编辑、验证、设计及架构工具集

- 医学免疫学情景化自动生成考题系统

- 易语言实现多语言界面编程教程

- MATLAB实现16种回归算法在数据挖掘中的应用

- ***内容构建指南:深入HTML与LaTeX

- Python实现维基百科“历史上的今天”数据抓取教程