Transformer的崛起:NLP领域的未来趋势分析

需积分: 9 126 浏览量

更新于2024-07-17

收藏 6.59MB PDF 举报

"全面拥抱Transformer,探讨NLP领域中CNN、RNN与Transformer的演变与前景"

在自然语言处理(NLP)领域,模型架构的更新迭代不断推动技术的进步。2018年,Transformer模型的出现,尤其以BERT为代表的预训练模型,极大地提升了NLP任务的性能。Transformer以其独特的自注意力机制,有效解决了RNN(循环神经网络)在处理长序列时的计算效率问题,以及CNN(卷积神经网络)在捕捉全局依赖关系上的局限性。

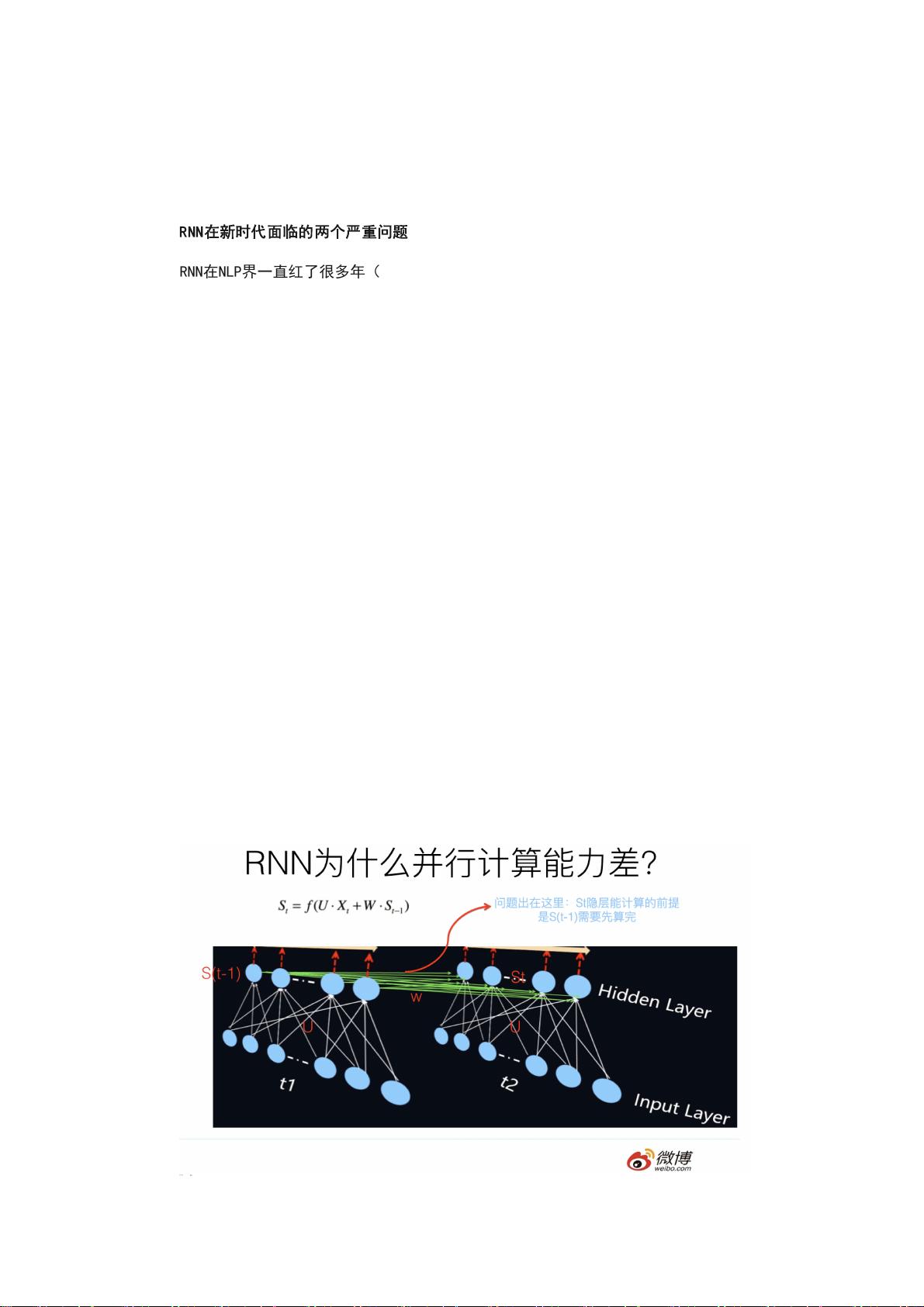

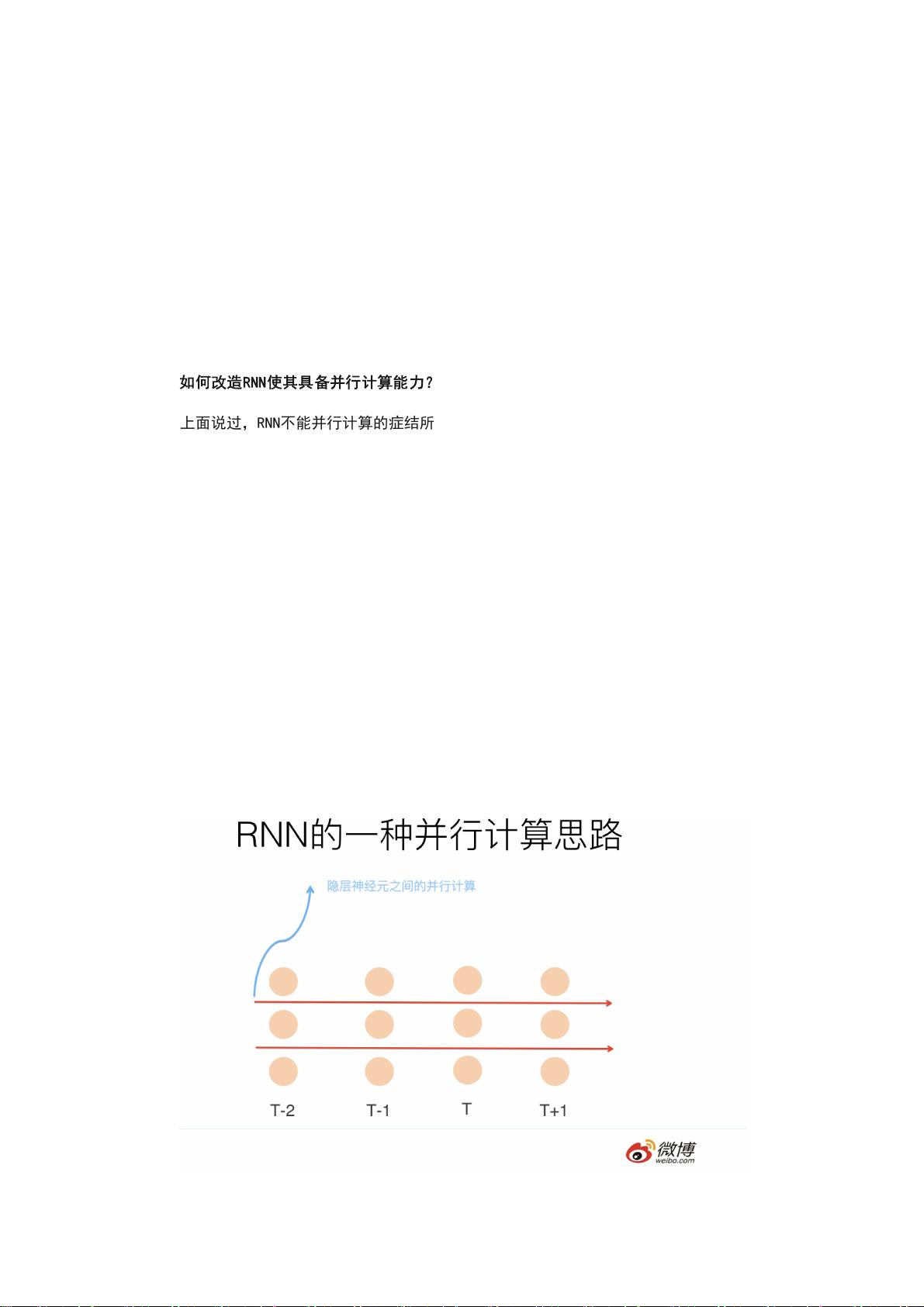

RNN在过去一段时间内是NLP中的重要特征抽取器,因其在处理序列数据时能够捕获时间依赖性而备受青睐。然而,RNN在处理长距离依赖时存在梯度消失或爆炸的问题,这限制了其在某些复杂任务上的表现。随着Transformer的崛起,RNN的地位逐渐被替代,因为Transformer通过自注意力机制可以在并行计算中处理全局依赖,显著提高了计算效率。

CNN在图像处理领域有着显著成就,但在NLP中,尽管其能有效捕捉局部特征,但对长距离依赖的处理能力相对较弱。尽管如此,通过改进和创新,如使用更深层次的残差网络和多尺度卷积,CNN仍有可能在某些特定NLP任务中发挥作用,但其成为主流特征抽取器的可能性相对较小。

Transformer模型的崛起在于其高效、并行的处理方式以及强大的建模能力。自注意力层使得Transformer能够在处理任意长度的输入时,同时考虑所有位置的信息,这对于理解和生成复杂的语言结构至关重要。此外,Transformer的预训练-微调范式,如BERT,已经在众多NLP任务上取得了前所未有的效果,这进一步巩固了其在NLP领域的核心地位。

未来,Transformer可能会继续演化和发展,适应更多类型的NLP任务。比如,针对低资源语言学习,或者将Transformer应用于语音识别、机器翻译等领域。同时,研究者们也在探索Transformer的变体,以减少计算复杂度,提高效率,例如使用更轻量级的头部设计和动态卷积等。

NLP领域的特征抽取器经历了从RNN到CNN再到Transformer的转变,Transformer凭借其优势正逐步成为主流。RNN的角色逐渐淡化,CNN则可能在特定场景下保持一定影响力,而Transformer及其后续发展将是推动NLP技术前进的关键力量。

567 浏览量

274 浏览量

433 浏览量

567 浏览量

132 浏览量

138 浏览量

点击了解资源详情

1393 浏览量

2025-03-13 上传

RobinQueue

- 粉丝: 2

最新资源

- HaneWin DHCP Server 3.0.34:全面支持DHCP/BOOTP的服务器软件

- 深度解析Spring 3.x企业级开发实战技巧

- Android平台录音上传下载与服务端交互完整教程

- Java教室预约系统:刷卡签到与角色管理

- 张金玉的个人简历网站设计与实现

- jiujie:探索Android项目的基础框架与开发工具

- 提升XP系统性能:4G内存支持插件详解

- 自托管笔记应用Notes:轻松跟踪与搜索笔记

- FPGA与SDRAM交互技术:详解读写操作及代码分享

- 掌握MAC加密算法,保障银行卡交易安全

- 深入理解MyBatis-Plus框架学习指南

- React-MapboxGLJS封装:打造WebGL矢量地图库

- 开源LibppGam库:质子-伽马射线截面函数参数化实现

- Wa的简单画廊应用程序:Wagtail扩展的图片库管理

- 全面支持Win7/Win8的MAC地址修改工具

- 木石百度图片采集器:深度采集与预览功能