Esri大数据平台HDFS搭建详解:从基础到实战

需积分: 0 75 浏览量

更新于2024-06-30

收藏 4.74MB DOCX 举报

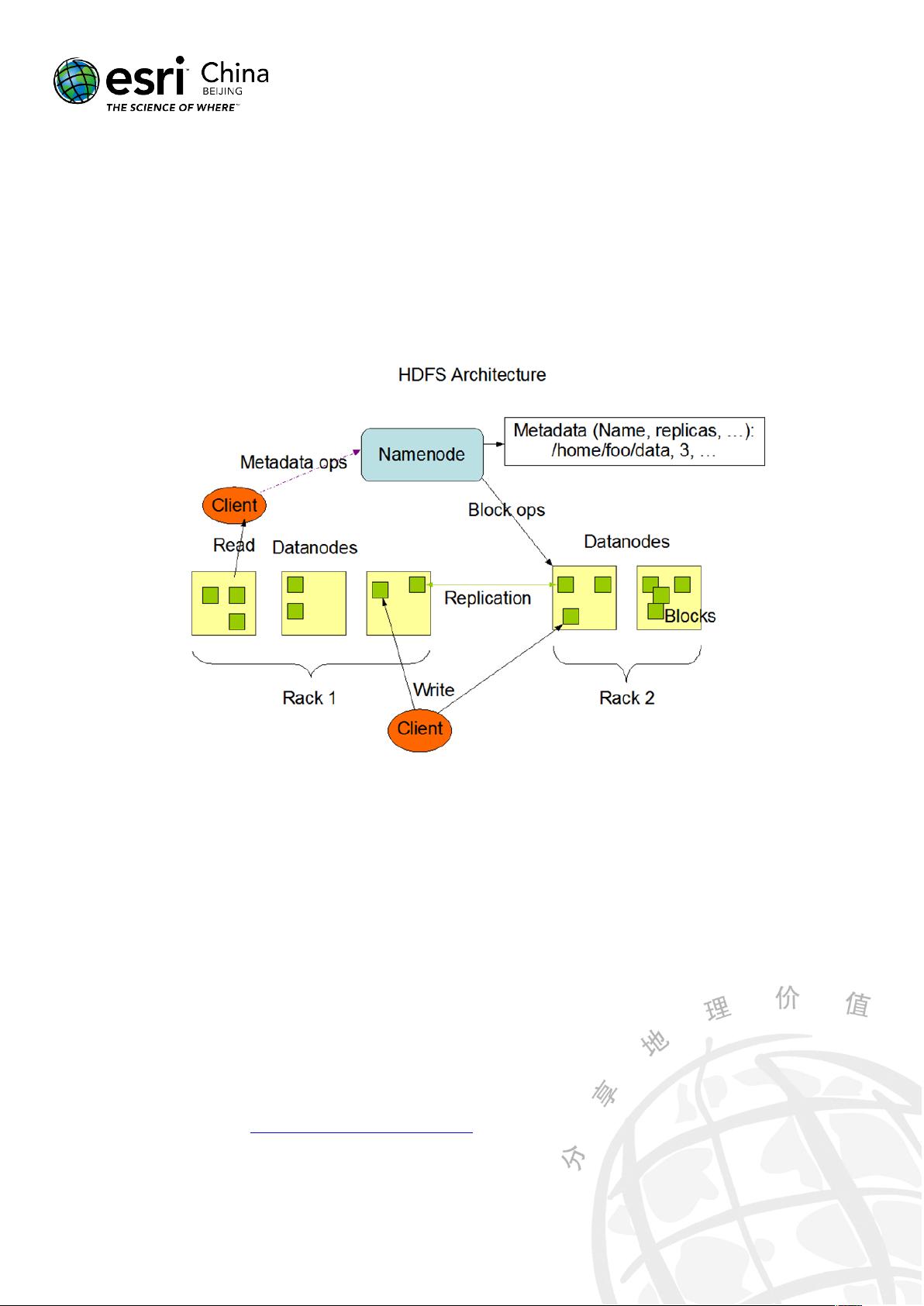

本文档是关于Esri大数据平台搭建指南的详细教程,专注于HDFS(Hadoop Distributed File System)部分。HDFS是一种分布式文件系统,被设计用于处理大规模数据集,具有高容错性和高吞吐量的特点,特别适合在大数据环境下运行。文档提供了具体的硬件和软件环境要求,包括四台CentOS服务器,每台配备4核CPU,4GB内存,以及40GB磁盘空间。操作系统选用的是CentOS 6.8,其他Linux版本也可以参考,但可能会有少许命令差异。

作者首先介绍了基础环境的准备,包括安装CentOS操作系统,添加并配置Hadoop用户(如'hadoop'及其密码),关闭防火墙并确保其不会在启动时自动运行。然后,文档指导如何配置主机名与IP地址映射,以及创建并管理JDK和Hadoop的安装路径,确保文件权限设置正确。

为了便于操作,推荐使用Xshell进行远程命令执行和Xftp进行文件传输,尤其是在虚拟机环境中,可以通过克隆虚拟机并修改MAC地址、IP和主机名来简化部署过程。接着,文档说明了如何将Hadoop和JDK文件传输到指定目录,解压并重命名,并且调整Hadoop安装目录的权限。

HDFS的搭建过程中,除了基础环境的设置,还包括HDFS的安装和配置,虽然具体步骤未详述,但可以推测这部分内容会涉及Hadoop的主/从架构,namenode和datanode的配置,以及HDFS配置文件的编辑,如core-site.xml和hdfs-site.xml,以定义文件系统的元数据存储、块大小、副本策略等关键参数。

在整个指南中,读者可以了解到如何在一个实际的HDFS环境中搭建Esri大数据平台,这对于理解和实践Hadoop技术,尤其是处理大规模地理空间数据至关重要。无论是对Hadoop新手还是经验丰富的开发者,这份文档都能提供宝贵的参考资料。

点击了解资源详情

点击了解资源详情

191 浏览量

2022-08-08 上传

2022-08-08 上传

2022-08-08 上传

2010-04-23 上传

2021-01-06 上传

191 浏览量

士多霹雳酱

- 粉丝: 23

- 资源: 299

最新资源

- http错误(常用错误解释和处理)

- Thinking In C#(Prentice Hall)

- 网络工程师模拟试题及答案

- 软件测试.测试技术,

- 《深入浅出C# 中文版 图文皆译》

- 面向数据集成的空间数据源wrapper 技术的研究.pdf

- ds18b20中文资料(来自网上)

- 概率论与数理统计浙大四版

- Sniffer Pro 4.7 入门指南

- Websphere 集群安装与配置

- 基于DELPHI的公司进销存管理系统

- 在AIX 5.2 上安装oracle 10g 数据库

- 《数字信号处理》试题库

- lotus script lotus script lotus script

- 人工神经网络的基准地价评估方法研究

- AIX 中文安装手册