mini_imagenet优化研究:低频与高频模型结合策略

需积分: 0 109 浏览量

更新于2024-08-04

收藏 85KB DOCX 举报

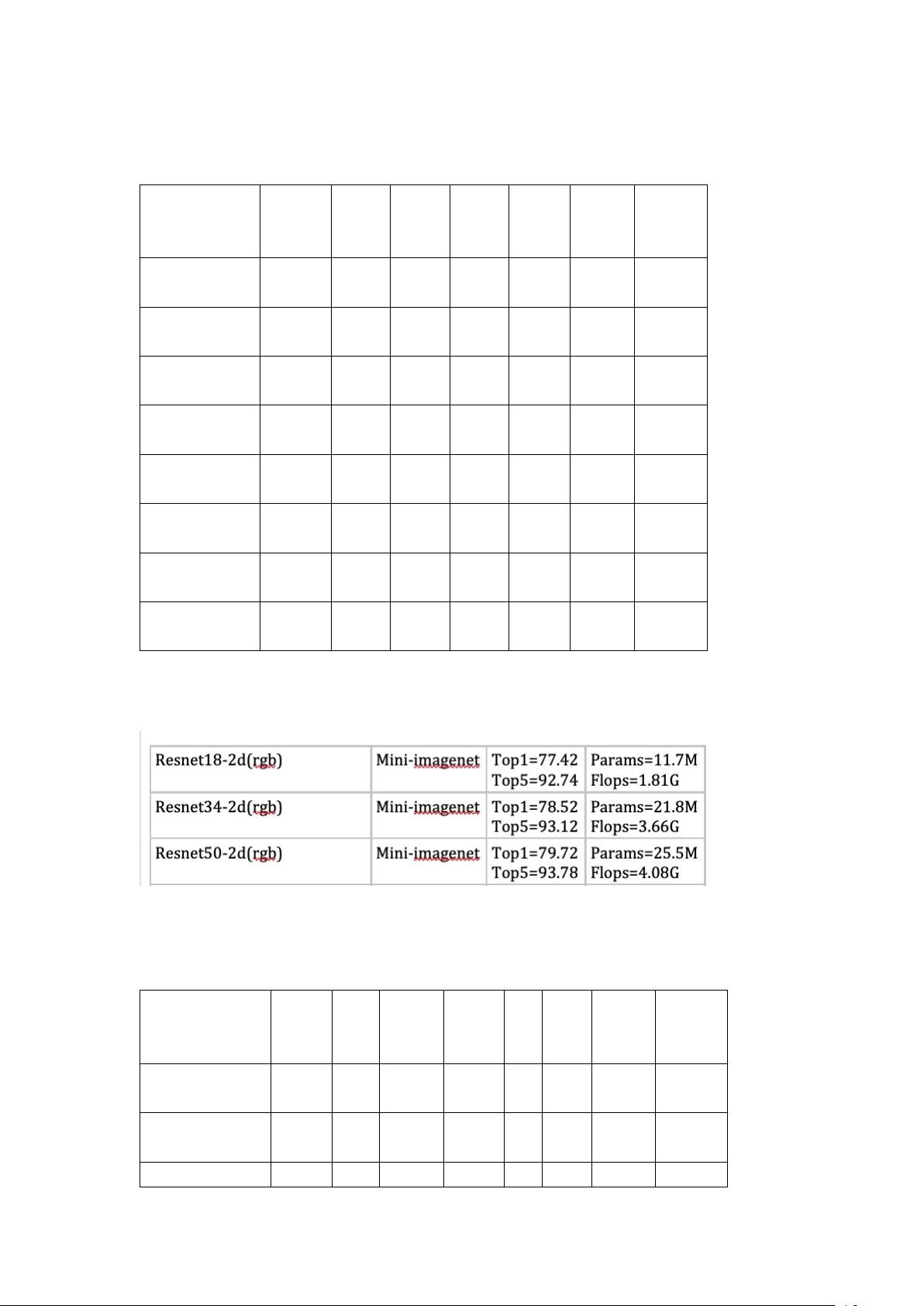

"这是关于Mini ImageNet数据集的训练和优化策略记录,主要涉及3D卷积(3ddct)、优化算法(SGD)、损失函数(NLLLoss和CrossEntropyLoss)、学习率调度(cosine annealing learning rate scheduler)、批次大小(batch size)以及预训练模型的使用情况。同时,提到了不同模型结构和训练策略对性能的影响,包括低频模型和高频模型的联合训练和独立使用,以及不同阈值下内存占用的计算。"

在训练深度学习模型时,选择合适的参数对于优化模型性能至关重要。本记录中提到了几个关键的训练参数:

1. **3D卷积(3ddct)**:3D卷积在处理三维数据,如视频序列时非常有用,它能捕获空间和时间维度上的特征。与2D卷积相比,它增加了对时间维度的处理能力。

2. **优化算法(SGD)**:随机梯度下降是最常用的优化算法之一,用于更新网络权重以最小化损失函数。这里使用了SGD,但未提及是否包含动量或Nesterov加速。

3. **损失函数**:记录中提到了两种损失函数,**NLLLoss**(负对数似然损失)通常用于多分类问题,而**CrossEntropyLoss**也是常见的多分类损失函数,可能在这里被用于替代NLLLoss。

4. **学习率调度(cosine annealing learning rate scheduler)**:这种调度器会按照余弦退火的规律调整学习率,开始时高,然后逐渐降低,最后回归到一个较低的值,有助于模型在训练初期快速探索空间,后期则稳定收敛。

5. **批次大小(batch size)**:记录中提到了两种设置,128和256,较大的批次大小可以更好地利用GPU并行计算能力,但可能会导致内存需求增加。

6. **预训练模型**:在某些实验中没有使用预训练模型(not pretrained),这表示模型是从随机初始化开始训练的,而不是基于预先在大规模数据集上训练的权重。

此外,还探讨了不同的模型结构和训练策略:

- **低频模型和高频模型**:低频模型可能用于捕捉全局或基础特征,而高频模型处理更复杂或局部的细节。在某些配置中,低频模型的输出在测试时作为参考,仅当其置信度不足时才会使用高频模型。

- **训练与测试流程**:在不同的策略中,低频模型的训练与测试流程有所变化,有时不参与训练,有时则与高频模型一起训练。

- **低频模型的阈值(bound)**:在不同的bound设置下,模型的性能有所不同,表现为准确率的变化。bound值决定了何时切换到高频模型,对内存占用也有直接影响。

- **两个损失函数的结合**:记录中提到将仅由低频模型产生的输出和低频与高频模型共同产生的输出的损失相加,这种做法可能有助于平衡模型在不同层次特征上的学习。

最后,`Partmodelsum`可能是指将这些不同的模型部分进行组合,以提升整体性能。这种组合策略在评估阶段表现出了较好的准确率,随着bound值的降低,模型的性能逐步提高。

这份记录展示了在Mini ImageNet数据集上进行模型优化的多种方法,涵盖了从基本的超参数选择到复杂模型结构和训练策略的探索,旨在找到最佳的性能与资源利用率之间的平衡。

2022-03-23 上传

136 浏览量

2021-03-27 上传

点击了解资源详情

点击了解资源详情

黄涵奕

- 粉丝: 978

- 资源: 327