类间距离特征空间传递:提升语义分割效率

130 浏览量

更新于2024-06-19

收藏 606KB PDF 举报

"本文主要探讨了在语义分割任务中,如何通过知识蒸馏技术有效传递类间距离特征,以提升轻量级学生网络的性能。传统的语义分割知识蒸馏方法多关注像素级特征对齐和类内特征的提取,而忽略了类间距离这一关键信息的传递。为解决此问题,文章提出了一种名为类间距离分布(IDD)的方法,旨在将教师网络的类间距离特征空间有效地传递给学生网络。同时,考虑到语义分割任务对位置信息的敏感性,文章还设计了一个位置信息蒸馏模块,以增强学生网络对位置信息的编码能力。实验结果证明,这种方法能显著提高学生网络在Cityscapes、PascalVOC和ADE20K等数据集上的语义分割准确率,实现了最先进的性能。例如,它使基准模型(PSPNet+ResNet18)在Cityscapes数据集上的性能有所提升。本文的研究为深度学习驱动的语义分割模型的轻量化和高效化提供了新的思路。"

在语义分割任务中,深度学习,特别是基于卷积神经网络(CNN)的方法已经取得了显著的进步。然而,这些模型往往计算量大,不适用于对效率有严格要求的场景。为了解决这一问题,研究者们致力于开发轻量级的网络架构,如ENet、ESPNet、ICNet和STDC等。尽管这些网络在减少计算成本方面取得了一定的成果,但在保持高精度的同时,往往难以找到理想的平衡点。

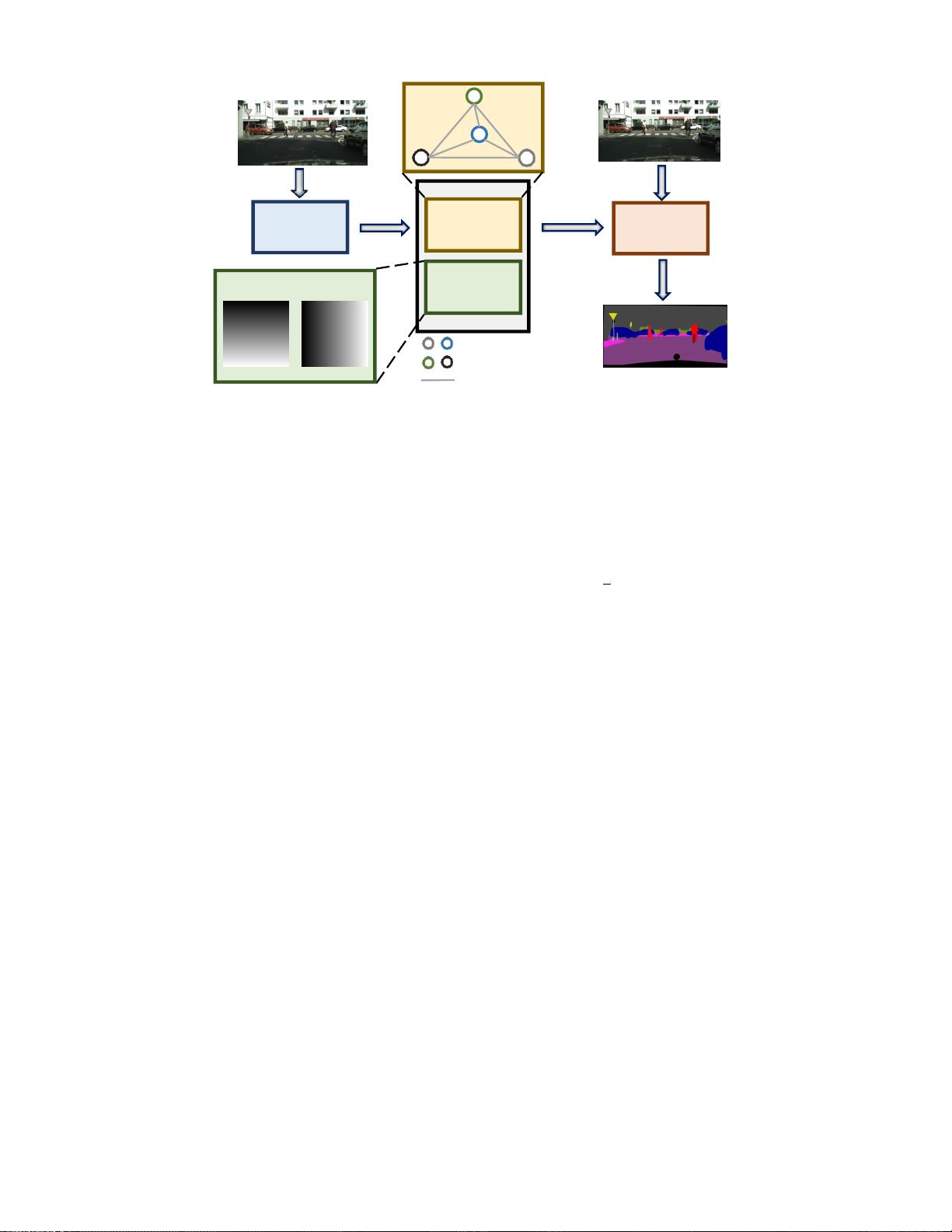

本文的核心贡献在于提出了一种新的知识蒸馏策略,即类间距离特征空间传递。传统知识蒸馏主要关注像素级别的特征对齐以及类内的特征一致性,而类间距离作为区分不同类别的重要指标,却没有得到充分重视。教师网络通常能够捕获更丰富的类间距离信息,而学生网络由于结构简单、参数较少,往往无法达到同样的效果(见图一)。为此,文章引入了类间距离分布(IDD),通过这个方法,教师网络的类间距离特性可以被有效地转移到学生网络,从而提升学生网络的分割精度。

此外,考虑到语义分割对图像位置信息的高度依赖,作者还构建了一个位置信息蒸馏模块。这个模块有助于学生网络更好地学习并编码位置信息,这对于执行语义分割任务至关重要。实验结果显示,结合IDD和位置信息蒸馏,学生网络的性能得到显著增强,特别是在多个常用的语义分割数据集上,如Cityscapes、PascalVOC和ADE20K,都达到了最先进的水平。

这项工作不仅强调了类间距离在知识蒸馏中的重要性,也为轻量级模型的性能优化提供了一个新的视角,对于推动深度学习在资源受限环境下的语义分割应用具有重要意义。

2024-08-04 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

cpongm

- 粉丝: 5

- 资源: 2万+

最新资源

- JDK 17 Linux版本压缩包解压与安装指南

- C++/Qt飞行模拟器教员控制台系统源码发布

- TensorFlow深度学习实践:CNN在MNIST数据集上的应用

- 鸿蒙驱动HCIA资料整理-培训教材与开发者指南

- 凯撒Java版SaaS OA协同办公软件v2.0特性解析

- AutoCAD二次开发中文指南下载 - C#编程深入解析

- C语言冒泡排序算法实现详解

- Pointofix截屏:轻松实现高效截图体验

- Matlab实现SVM数据分类与预测教程

- 基于JSP+SQL的网站流量统计管理系统设计与实现

- C语言实现删除字符中重复项的方法与技巧

- e-sqlcipher.dll动态链接库的作用与应用

- 浙江工业大学自考网站开发与继续教育官网模板设计

- STM32 103C8T6 OLED 显示程序实现指南

- 高效压缩技术:删除重复字符压缩包

- JSP+SQL智能交通管理系统:违章处理与交通效率提升