Transformer架构解析:注意力即一切

需积分: 45 146 浏览量

更新于2024-09-11

3

收藏 1.34MB PDF 举报

"Attention Is All You Need" 是一篇由 Ashish Vaswani、Noam Shazeer、Niki Parmar、Jakob Uszkoreit、Llion Jones、Aidan N. Gomez、Łukasz Kaiser 和 Illia Polosukhin 等人合作撰写的深度学习论文,发表于第31届神经网络信息处理系统会议(Neural Information Processing Systems, NIPS 2017)。这篇开创性的文章提出了Transformer架构,这是一种基于自注意力机制(Self-Attention)的序列建模方法,彻底改变了自然语言处理(NLP)领域的处理方式。

在传统的循环神经网络(RNN)中,长期依赖问题一直是限制其性能的重要因素。然而,Transformer通过抛弃RNN中的递归结构,引入了全连接注意力机制,使得模型能够同时考虑输入序列中的所有元素,无需逐个向前或向后传递信息。这一创新不仅提高了模型的计算效率,而且在诸如机器翻译等任务上取得了显著的性能提升。

文中提到的主要贡献包括:

1. **Self-Attention**:由Jakob Uszkoreit提出,作为一种新颖的注意力机制,它允许模型直接对输入序列中的任意位置进行交互,而不仅仅是依赖先前的上下文信息。这使得模型能够捕捉到更全局的上下文关系。

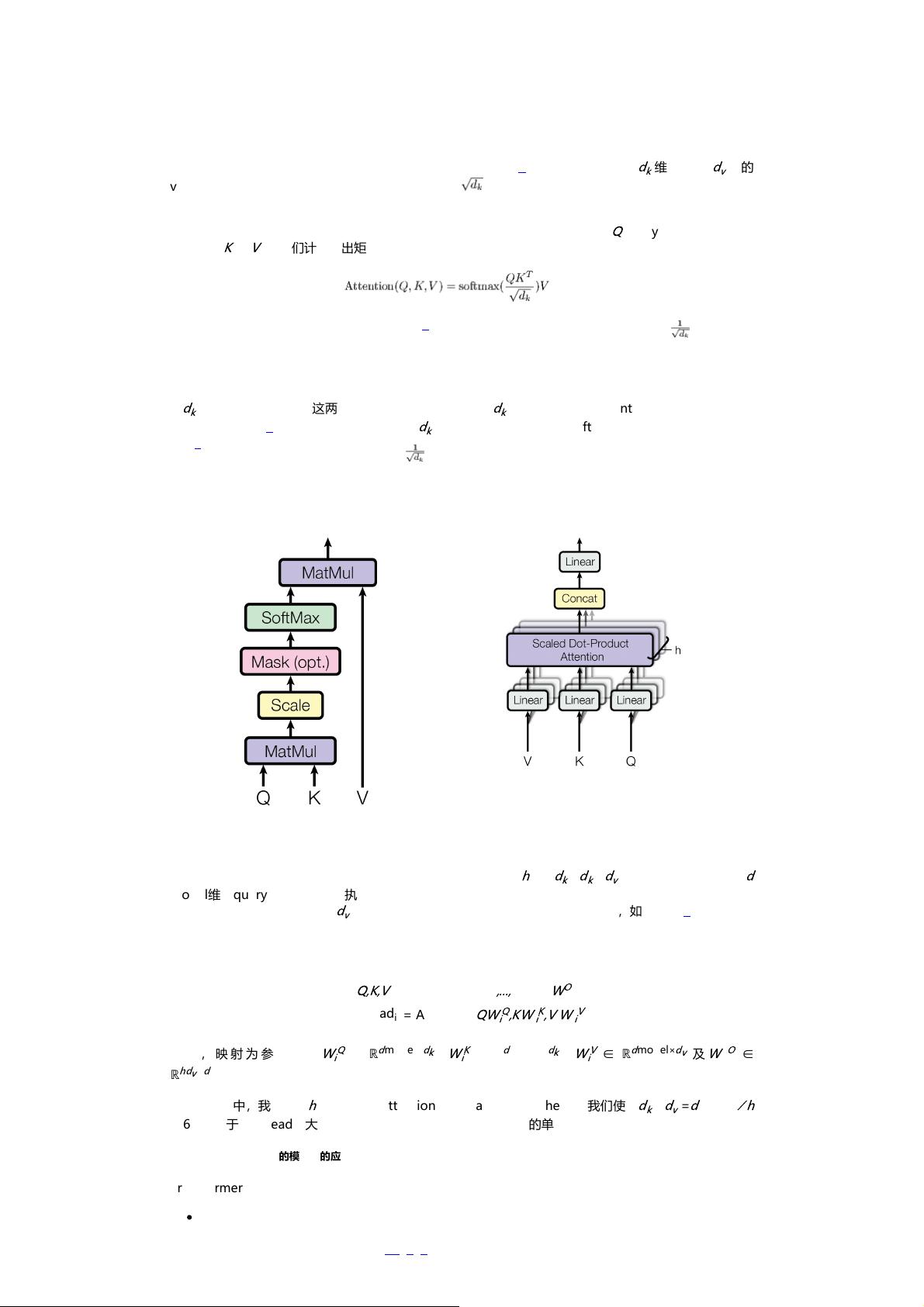

2. **Multi-Head Attention**:Ashish Vaswani和Illia Polosukhin共同设计,将注意力分为多个独立的“头”(heads),每个头专注于不同类型的特征,从而增强了模型的表达能力。

3. **Positional Encoding**:Noam Shazeer提出了一种参数化的位置编码方法,用于在不依赖于循环结构的情况下提供序列的顺序信息,解决了Transformer中缺乏明确顺序信息的问题。

4. **Tensor2Tensor**:Niki Parmar、Llion Jones和Aidan N. Gomez负责设计和优化了Tensor2Tensor库,这是一个用于大规模训练Transformer和其他复杂模型的框架,极大地推动了研究的进展。

5. **高效推理与可视化**:Llion Jones致力于开发更高效的推理算法和模型可视化工具,帮助团队理解模型内部的工作原理。

6. **Google Brain和Google Research背景**:所有作者在Google的研究环境中工作,他们的成果为自然语言处理领域带来了革命性的突破,加速了Transformer模型在业界的应用。

"Attention Is All You Need"这篇论文通过介绍Transformer架构,开启了深度学习中自注意力机制的新篇章,对现代NLP的发展产生了深远影响。其核心思想是将模型的关注点集中于处理序列数据时的全局上下文关联,从而实现了性能上的显著提升。

158 浏览量

2025-03-09 上传

975 浏览量

2024-07-04 上传

255 浏览量

395 浏览量

绝不原创的飞龙

- 粉丝: 4w+

最新资源

- Delphi编程实现获取MAC地址教程

- 轻松部署:简单易用的代理服务器软件指南

- 专业U盘数据恢复工具—轻松恢复格式化或误删文件

- 个人网站的设计与JavaScript应用

- Ext JS初学者必备实用教程指南

- DCS-168E集团电话交换机软件V1.6.8更新发布

- 在Windows上安装和配置MongoDB教程

- PopChar输入特殊字符工具v6.2功能体验与安装教程

- 中型企业高性能数据存储方案对比:IBM TSM vs Symantec NBU6.0

- Direct3D游戏编程入门:源码解析与教程

- Holberton School算法面试准备特训

- 全面分享Java程序设计课后答案

- 轻巧华丽的1MB音乐播放器:AirPlayer使用体验

- ASP.NET实现拆线与柱状图展示及代码教程

- 金融公司java工程师不同级别笔试题解析

- Laravel框架精髓与学习资源:实践中的愉悦与创造力