GNN可解释性:揭秘图神经网络的决策机制

需积分: 8 184 浏览量

更新于2024-07-01

收藏 3.54MB PDF 举报

"Simone Scardapane 的报告——Graph Neural Networks: Explainability,主要探讨了图神经网络(GNN)的可解释性问题以及如何评估这些解释方法。报告指出,GNN在图表示学习中广泛应用,但其决策过程往往被视为黑盒,这导致了理解和信任模型预测的挑战。"

在深度学习领域,图神经网络(GNNs)已经成为处理图数据的强大工具,尤其在社交网络分析、化学分子结构识别和推荐系统等应用中展现出优异性能。然而,如同其他深度学习模型,GNNs也面临可解释性问题。这是因为复杂的神经网络架构使得模型的决策过程难以被直观理解和解释,这被称为“黑盒”问题。

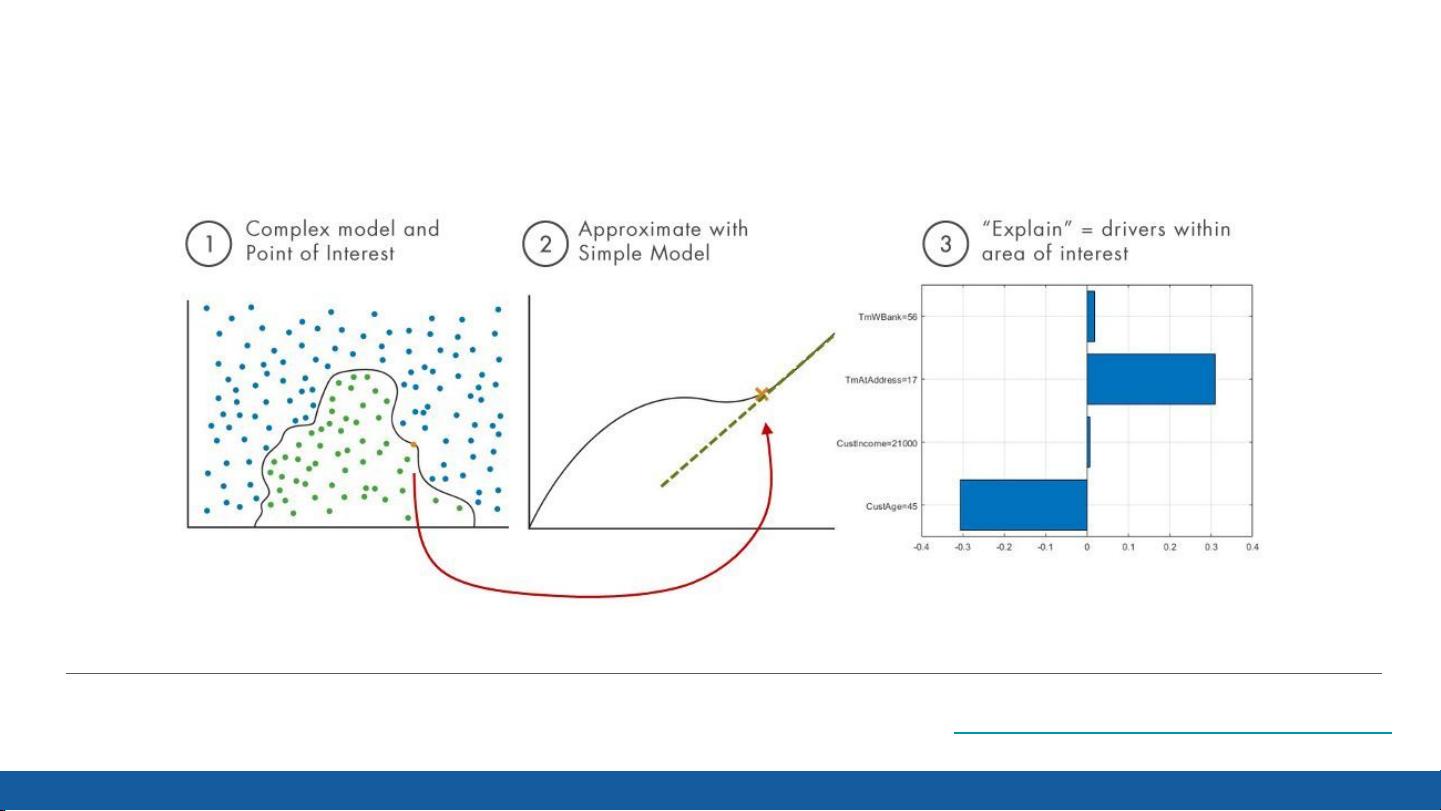

可解释人工智能(XAI)是研究如何提高模型预测的透明度和理解度的领域。XAI试图在强大的表示能力(如深度学习模型)和内在可解释性(如线性回归或决策树)之间找到平衡。通常,简单模型易于理解,但可能无法处理复杂任务;而复杂的模型虽然能够解决复杂问题,却缺乏明显的解释性。

报告中提到,大部分XAI方法主要针对同一方法的实践者,即主要用于模型调试,而非终端用户。对于非专业人士(例如临床工作人员),提供准确且一致的解释更加困难。不同的解释方法可能会给出不同的“解释”,并且缺乏统一的评估标准,这给实际应用带来了挑战。

GNN的解释性方法通常分为两类:局部解释和全局解释。局部解释关注于理解单个节点或边的预测结果是如何产生的,而全局解释则尝试揭示整个模型的运作机制。这些方法包括但不限于:可视化节点特征传播、重要性得分分配、可解释的图卷积层设计等。

解释GNN的方法评估主要包括一致性、稳定性、鲁棒性和可操作性等方面。一致性是指解释应与模型的预测一致;稳定性意味着相同的输入应产生相似的解释;鲁棒性则是指小的输入变化不应导致显著的解释变化;可操作性则强调解释应能指导模型的改进或优化。

Simone Scardapane的报告深入浅出地介绍了GNN的可解释性问题,并提出了评估解释方法的关键指标,这对于推动GNN在关键领域的应用,如医疗、金融和社会科学等,具有重要意义。通过提升GNN的可解释性,我们可以更好地理解和信任这些模型的决策,进而增强其在实际应用中的采纳和影响力。

2022-04-19 上传

2022-05-21 上传

2019-11-18 上传

2021-08-30 上传

2022-02-14 上传

2019-10-30 上传

2023-03-16 上传

2020-03-29 上传

努力+努力=幸运

- 粉丝: 17

- 资源: 136

最新资源

- PureMVC AS3在Flash中的实践与演示:HelloFlash案例分析

- 掌握Makefile多目标编译与清理操作

- STM32-407芯片定时器控制与系统时钟管理

- 用Appwrite和React开发待办事项应用教程

- 利用深度强化学习开发股票交易代理策略

- 7小时快速入门HTML/CSS及JavaScript基础教程

- CentOS 7上通过Yum安装Percona Server 8.0.21教程

- C语言编程:锻炼计划设计与实现

- Python框架基准线创建与性能测试工具

- 6小时掌握JavaScript基础:深入解析与实例教程

- 专业技能工厂,培养数据科学家的摇篮

- 如何使用pg-dump创建PostgreSQL数据库备份

- 基于信任的移动人群感知招聘机制研究

- 掌握Hadoop:Linux下分布式数据平台的应用教程

- Vue购物中心开发与部署全流程指南

- 在Ubuntu环境下使用NDK-14编译libpng-1.6.40-android静态及动态库