深入理解Java ConcurrentHashMap:源码解析与性能优化

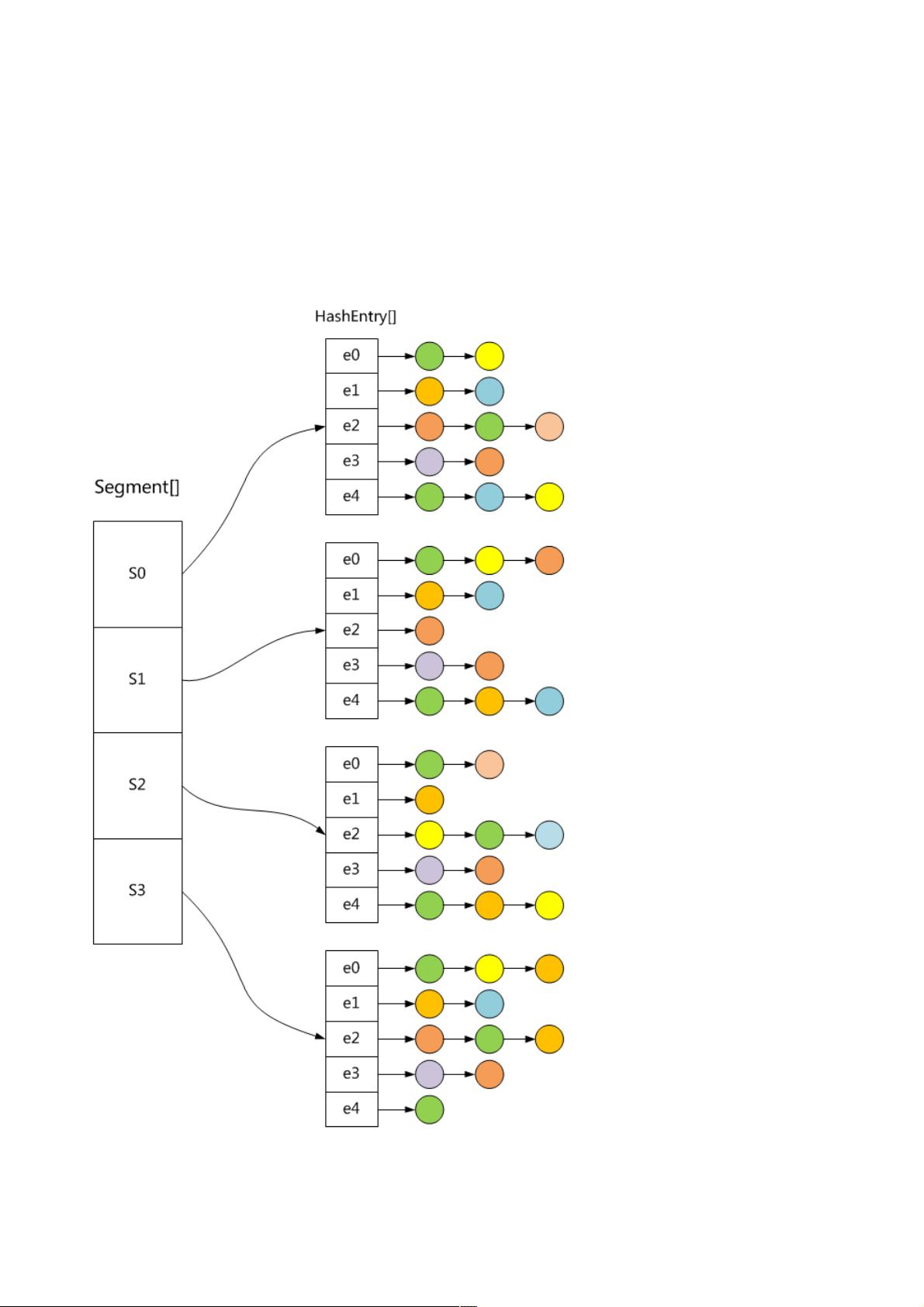

本文将深入探讨Java并发系列中的一个重要数据结构——ConcurrentHashMap。ConcurrentHashMap是Java标准库中为解决多线程环境下哈希表操作性能问题而设计的一种高级线程安全的哈希表实现。相比于传统的HashMap,ConcurrentHashMap在设计上采用了分段锁(Segment-based locking)策略,以实现细粒度的并发控制。

首先,我们了解到ConcurrentHashMap的关键特性:

1. **初始容量**:默认初始容量设为16,这是为了优化内存效率,允许在早期阶段就进行扩容。

2. **加载因子**:默认加载因子为0.75,意味着当哈希表接近满载时(元素数量接近于容量的75%),会触发扩容操作。

3. **并发级别**:默认并发级别设置为16,表示哈希表被划分为16个独立的分段,每个分段有自己的锁,减少了全局锁的竞争。

4. **最大容量**:理论上限为2^30,确保了哈希表的扩展性。

5. **分段锁的限制**:最小分段数量为2,最大可达2^16个,通过这种方式实现了对不同部分的并行访问。

6. **重试机制**:在尝试获取锁之前,会进行多次重试,减少因其他线程持有锁导致的阻塞。

7. **分段锁的计算**:通过`segmentMask`和`segmentShift`分别表示分段索引的计算方式,保证了线程安全。

在ConcurrentHashMap的设计中,关键在于如何将全局的哈希表分解成多个小的、独立的部分,并为每个部分提供单独的锁。这样,当多个线程同时操作不同的哈希表区域时,它们可以并行地进行插入、删除和查找操作,极大地提高了并发性能。这种设计避免了像HashTable那样对整个哈希表进行全局加锁,从而减少了锁的竞争,降低了死锁的风险。

为了更好地理解ConcurrentHashMap,读者需要关注以下几个部分:

- **分段锁的实现**:理解如何根据键的哈希值计算出对应分段,并使用对应的锁进行操作。

- **扩容与合并**:当哈希表达到预设的负载因子时,如何动态地调整分段大小以及合并分段,以保持性能。

- **读写锁定**:ConcurrentHashMap如何区分读操作和写操作,以允许读操作在没有冲突的情况下并行执行。

- **并发算法**:如何在多线程环境中维护哈希表的正确性和一致性,比如冲突解决策略和并发插入策略。

通过深入研究ConcurrentHashMap的源码,开发者可以更好地理解和应用这个高效、线程安全的哈希表结构,提高多线程应用的并发性能。这对于理解和优化并发编程,特别是在高并发场景下的Java应用来说,具有很高的实用价值。

171 浏览量

点击了解资源详情

169 浏览量

148 浏览量

147 浏览量

193 浏览量

点击了解资源详情

260 浏览量

142 浏览量

weixin_38744902

- 粉丝: 9

- 资源: 933

最新资源

- witx-codegen:用于AssemblyScript,Zig等的WITX代码和文档生成器

- ml-toolkit-deployments:OCP上的KubeFlow和ODH变体的文档过程

- Daily-Challenges:每日编程器

- 基于SSM的果蔬商城系统论文+项目导入演示+源码

- Gmail-autocomplete:一个 chrome 扩展,可以在输入您自己的电子邮件 ID 时自动完成 gmail 电子邮件正文和主题。 如果您经常发送类似格式的邮件(例如每日状态报告),这会很有用

- ApplicationInsights-Python:适用于Python的Application Insights SDK

- Classifikation_regularization

- Bonn Open Synthesis System (BOSS)-开源

- adf管道触发

- epg

- associateFiles_matlab_associateFiles_

- icingaweb2-module-grafana:用于Icinga Web 2的Grafana模块(支持InfluxDB和Graphite)

- svm+tdm_gcc.zip

- MakeBSSGreatAgain-Auth-API:MakeBSSGreatAgain项目的身份验证API

- 3d-convex-hulls:使用 OpenCL 对 3D 凸包的极简分治算法进行自下而上的适配

- QMtrim:AviSynth的简单量化运动Trim()生成器-开源